Wichtige Erkenntnisse

- Bis 2030 wird Human-in-the-Loop ein zentrales Designelement für vertrauenswürdige und erklärbare KI sein.

- Vorschriften werden menschliche Überwachung bei sensiblen KI-Entscheidungen verlangen.

- Mensch-KI-Synergie treibt ethische und skalierbare Automatisierung voran.

Eine hybride Zukunft für KI und Menschen

Mit Blick auf das Jahr 2030 wird eine Sache immer klarer: Die erfolgreichsten KI-Systeme sind nicht die schnellsten oder am stärksten automatisierten, sondern diejenigen, denen Nutzer am meisten vertrauen. Dieses Vertrauen entsteht durch das Gleichgewicht von Automatisierung und menschlicher Expertise.

Die Anfangszeit der KI zeigte, dass autonome Systeme zwar robust sein können, aber oft Risiken wie Bias, mangelnde Transparenz und unerwartetes Verhalten mitbringen. Diese Herausforderungen haben das Interesse an HITL-Systemen und menschenzentrierter KI neu belebt – nicht als Notlösung, sondern als zukunftsweisende Designstrategie.

Schätzungen zufolge werden bis 2026 über 90 % der Online-Inhalte von KI erzeugt werden statt von Menschen. Diese Entwicklung hebt die Bedeutung von Vertrauen und Aufsicht in automatisierten Systemen besonders hervor, wie Oodaloop feststellt.

Die Grundlagen zu diesem Konzept erläutert unser praktischer Leitfaden zu Human-in-the-Loop KI: Definition und Vorteile, der Anwendung und Nutzen von HITL im Unternehmen erklärt.

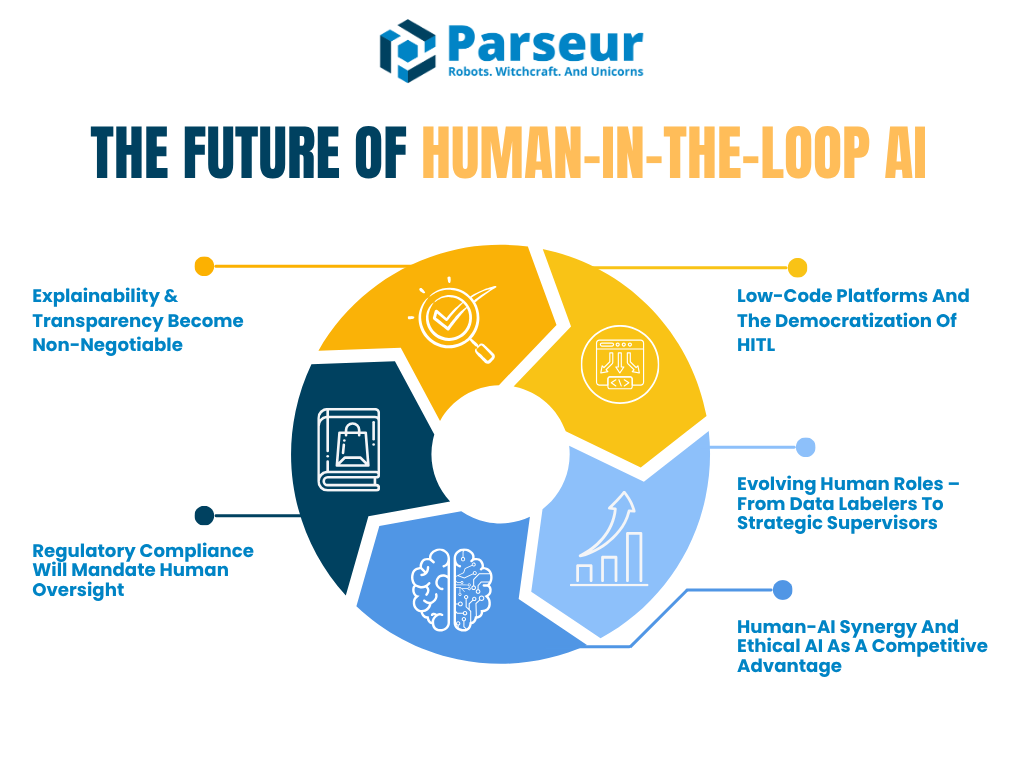

Nachfolgend beleuchten wir, wie sich HITL bis 2030 entwickeln wird – mit Fokus auf fünf Schlüsseltendenzen:

- Die Nachfrage nach erklärbarer und prüfbarer KI

- Neue regulatorische Vorgaben, die menschliche Aufsicht erfordern

- Das Wachstum von Low-Code-Plattformen für eine vereinfachte HITL-Implementierung

- Die Wandlung menschlicher Aufgaben vom Datenlabeling hin zu KI-Supervising

- Wie Mensch-KI-Synergie zum Wettbewerbsvorteil wird

Laut Venture Beat erwartet auch Tech-Vordenker Reid Hoffman eine Zukunft, die von AI Superagency geprägt ist, und sagt: „Menschen, die keine KI benutzen, werden von denen ersetzt, die dies tun“ – KI wird so zum Produktivitätsmultiplikator, nicht zur Bedrohung.

Das bestätigt auch das PwC 2026 Global AI Jobs Barometer: Seit der Verbreitung von Generativer KI 2022 hat sich das Produktivitätswachstum in KI-geprägten Branchen fast vervierfacht, von 7 % (2018–2022) auf 27 % (2018–2024), und zeigt, wie KI die Produktivität von Menschen in Bereichen wie Finanzdienstleistungen und Software erheblich steigert.

Organisationen stehen nicht mehr vor der Wahl zwischen Automatisierung oder Kontrolle. Die Zukunft liegt in hybriden KI-Architekturen, die menschliches Urteilsvermögen gezielt integrieren – mittels In-the-Loop- oder On-the-Loop-Modelle.

Trend 1: Erklärbarkeit & Transparenz werden unverzichtbar

Je stärker KI-Systeme reale Entscheidungen beeinflussen, lautet die zentrale Frage nicht mehr, ob KI Aufgaben korrekt erledigt, sondern: Können Menschen diese Entscheidungen nachvollziehen und erklären? Hier setzen erklärbare KI (XAI) und Transparenz an.

In den kommenden Jahren wird Erklärbarkeit von einer Best Practice zur verpflichtenden Anforderung, insbesondere in Bereichen wie Finanzen, Gesundheitswesen, Versicherung und Recht. Human-in-the-Loop-Workflows unterstützen nicht nur die Aufsicht – sie ermöglichen es Unternehmen, regulatorische und ethische Vorgaben einzuhalten, indem Menschen die Ergebnisse der KI interpretieren, validieren und erklären.

Laut Gartner werden bis 2026 mehr als 80 % der Unternehmen Generative KI-APIs nutzen oder entsprechende Anwendungen eingeführt haben. Das zeigt, wie dringend Erklärbarkeit und menschliche Aufsicht branchenübergreifend benötigt werden.

Ein hervorragendes Beispiel ist der EU AI Act, der bei Hochrisiko-KI menschliche Aufsicht und Erklärbarkeit bereits vorschreibt. Das NIST AI Risk Management Framework mahnt zudem, dass unklare HITL-Rollen und intransparente Entscheidungen nach wie vor gravierende Schwachstellen seien. Zukünftig werden Frameworks wie das von NIST festlegen, wie menschliche Kontrolle gestaltet und dokumentiert wird.

Ausblick: Human-in-the-Loop mit Erklärungsschnittstellen

Bis 2030 werden KI-Systeme vermutlich mit standardisierten „Erklärungsschnittstellen“ ausgestattet sein. Diese unterstützen menschliche Prüfer dabei, Modellentscheidungen zu verstehen. So könnte etwa ein Kreditsystem nicht nur einen Score, sondern auch die drei Hauptgründe für die KI-Entscheidung anzeigen – und Prüfern Kontext und Nachvollziehbarkeit für Fairness und Korrektheit bieten.

HITL entwickelt sich von manuellen Prüfungen bei jedem Schritt hin zu strategischer Validierung an kritischen Punkten. Es geht weniger um Zeile-für-Zeile-Freigaben als um die Bewertung, ob die Logik der KI-Ausgaben Unternehmenswerten, Compliance und Fairness entspricht.

Branchen, in denen das bereits Praxis ist

Gesundheits- und Finanzbranche sind Vorreiter, denn hier ist Erklärbarkeit sogar gesetzlich vorgeschrieben. Im Deloitte Tech Trends Report 2026 steht: „Je komplexer die Systeme, desto wichtiger werden menschliche Fachkräfte.“ Dieser Satz betont das Paradox der KI: Mit wachsender Automatisierung wächst auch der Bedarf an qualifizierter menschlicher Kontrolle.

Dies zeigt sich auch in 'Human-on-the-Loop'-Modellen: Menschen müssen nicht mehr ständig eingreifen, sondern überwachen permanent und greifen bei Bedarf ein – wie Piloten beim Autopiloten im Flugzeug.

Warum das relevant ist

Die Entwicklung zu mehr Erklärbarkeit bestätigt eine zentrale Wahrheit: Unternehmen können KI nicht skalieren ohne Vertrauen – und das beruht auf Transparenz. Künftig könnten Unternehmen verpflichtet werden, „Erklärungstagebücher“ zu führen oder Prüfprotokolle mit menschlicher Kontrolle und Freigabe zu erstellen.

Diese menschlichen Rollen bleiben dabei nicht nur reaktiv, sondern prägen die Weiterentwicklung von KI aktiv – durch das Aufdecken von Schwächen, Kontextualisierung und ethische Verankerung.

Trend 2: Regulierung verlangt menschliche Aufsicht

Mit wachsender KI-Leistung steigen Rechts- und Ethikpflichten. Globale Regulierer legen immer mehr Wert auf Verantwortung und menschliche Kontrolle in automatisierten Systemen. Zwischen 2026 und 2030 ist eine Regulierungswelle zu erwarten, die Human-in-the-Loop-Prozesse bei vielen risikobehafteten KI-Anwendungen formell verlangt.

Staaten und Institutionen wie EU, USA und NIST sind sich einig: KI darf keine Black Box sein. Betroffene von Algorithmen-Entscheidungen müssen diese nachvollziehen, anfechten und im Zweifel eine menschliche Überprüfung einfordern können.

So wurden allein 2024 in den USA mehr als 700 KI-Gesetze eingebracht, Anfang 2026 kamen über 40 neue hinzu, was laut Naaia den Trend zu Transparenz und Aufsicht bestätigt.

Laut GDPR Artikel 22 dürfen Individuen bei automatisierten Entscheidungen eine menschliche Intervention verlangen. Der kommende EU AI Act verlangt, dass Menschen bei Hochrisiko-Systemen eine bedeutende Überwachungs- und Steuerungsrolle übernehmen. Dies ist kaum noch Trend, sondern wird zur juristischen Norm.

Ausblick: Compliance-gesteuerte HITL-Systeme

Bis 2030 werden zahlreiche Unternehmen das umsetzen, was sich als "Compliance-HITL" bezeichnet: Governance-Workflows, die gezielt regulatorische Anforderungen adressieren. Beispiele:

- Menschliche Prüfer protokollieren und kontrollieren KI-Entscheidungen regelmäßig.

- Mancherorts entstehen AI Oversight Teams, die Live-Systeme überwachen, vergleichbar mit Kontrollräumen in Luftfahrt oder Cybersecurity.

- Menschliche Kontrollpunkte werden gezielt in Entscheidungs-Pipelines eingefügt, wo Risiken oder Fairness entscheidend sind.

Tools und Plattformen werden darauf reagieren. Unternehmen werden Dashboards nutzen, über die Modellgenauigkeit sowie menschliche Eingriffe bei KI-Entscheidungen nachvollziehbar protokolliert werden kann. Diese Nachvollziehbarkeit wird selbst zum Compliance-Indikator.

Expertensicht: Der Aufstieg hybrider KI-Governance

Branchenführer setzen schon jetzt auf hybride Frameworks. Laut Gartner haben **67 % der etablierten Unternehmen spezielle KI-Teams gegründet und neue Rollen wie KI-Ethiker, Modellmanager und Knowledge Engineers eingeführt, um einen verantwortungsvollen KI-Einsatz zu gewährleisten.

Gerade in Daten- und Analyseabteilungen werden diese Rollen zum Standard, da technische wie ethische Aufsicht der Schlüssel zum Erfolg sind. Bis 2030 werden „AI Auditor“, „AI Risk Manager“ oder „Human-in-the-Loop Supervisor“ selbstverständlich – das signalisiert eine strategische Verankerung menschlicher Kontrolle in der KI-Governance.

Erklärbarkeit wird regulatorisch verbindlich

Es genügt nicht mehr, dass Menschen beteiligt sind. Regulierer erwarten zudem, dass diese erklären können, warum Entscheidungen gefällt wurden – eine Verbindung zum ersten Trend. Dokumentation und Audit-Trails gehören dann zum Standardprozess. Das NIST AI RMF empfiehlt schon heute, dass Organisationen Menschen befähigen, KI-Ergebnisse zu überschreiben und regelmäßig zu überwachen. Zukünftig kann das Fehlen dieser Kontrollmechanismen zum Verlust von Zertifikaten oder zu Strafen führen.

Manche Firmen werden sich gezielt um KI-Vertrauenszertifikate bemühen, die belegen, dass ihre Systeme von Beginn an mit menschlicher Kontrolle aufgebaut wurden.

Trend 3: Low-Code-Plattformen und Demokratisierung

Bislang waren HITL-Workflows aufwändig: Sie erforderten Entwicklerressourcen, Integrationen und tiefgehende KI-Expertise – kaum erschwinglich für kleine Teams. Doch das ändert sich rasant. Ab 2026 und mehr noch im nächsten Jahrzehnt werden Low-Code- und No-Code-Plattformen HITL auch für Laien und Fachabteilungen zugänglich machen.

Damit lassen sich menschliche Entscheidungspunkte in KI-Workflows integrieren, ohne selbst Code zu schreiben. Schon heute bieten Tools wie UiPath, Microsoft Power Automate oder Amazon A2I Drag-and-drop-Funktionen mit eingebauten menschlichen Prüfungen.

Ausblick: KI-Workflows aus den Fachbereichen

KI-Plattformen mit HITL-Funktionen werden in Kürze zur Standardausstattung gehören. Bis 2026 planen 70 % der CX-Verantwortlichen, Generative AI in Kontaktpunkten einzusetzen – zumeist mit HITL-Komponenten zur Qualitätssicherung und Kontrolle, wie AmplifAI berichtet.

Das demokratisiert die Governance: Fachabteilungen wie Operations, Recht oder Finanzen können jetzt selbst eigene Überwachungslayer einbauen. Mehr Menschen setzen KI und Kontrolle ein – das beschleunigt Skalierung und Sicherheit.

In Zukunft könnten sogar LLMs selbst Vorschläge machen, wo ein Human-in-the-Loop Schritt sinnvoll ist, etwa basierend auf Modellvertrauen oder Datenrisiko. Plattformen enthalten Monitoring-Dashboards, in denen Menschen Entscheidungssummen einsehen, Probleme kennzeichnen und KI-Verhalten durch Feedback optimieren.

Crowdsourcing für menschliche Überprüfung

Ein weiterer Baustein: Crowd-basierte und On-Demand-Kontrolle. Services wie Amazon Mechanical Turk und BPO-Partner lassen sich in KI-Pipelines integrieren und realisieren skalierbare HITL-Prüfungen ohne große interne Ressourcen.

Beispiel: Ein E-Commerce-Unternehmen verarbeitet Produktbewertungen per KI, leitet aber verdächtige Fälle an eine HITL-Queue mit Freelance-Prüfern weiter – schnell, effizient und präzise.

Branchendynamik für zugängliches HITL

Plattformen müssen Automatisierung über Low-Code-Oberflächen ermöglichen und optional tiefe Anpassung erlauben. Daraus folgt: HITL lässt sich künftig so einfach implementieren wie eine E-Mail-Kampagne oder Website.

Dies spiegelt auch die Entwicklung von Parseur wider. Während Parseur weiterhin Flexibilität für eigene Templates und Unabhängigkeit vom KI-Engine bietet, werden HITL-Workflows zum festen Bestandteil intelligenter Automatisierung – Plattformen wie Parseur sind der Schlüssel für skalierbare, menschlich geprüfte Prozesse in jeder Branche.

Trend 4: Wandel der menschlichen Rolle – Vom Data Labeler zum Supervisor

Mit fortschreitender KI-Wirkung wandelt sich auch der menschliche Part. Anfangs fielen HITL vor allem sich wiederholende Aufgaben wie Datenlabeling oder einfache Validierung zu – doch künftig übernehmen KI oder Crowdworker diese Aufgaben. Menschen werden dagegen immer strategischer, spezialisierter und wertschöpfend eingebunden.

Laut Statistica-Report 2026 wurden 47% der Arbeit von Menschen durchgeführt, 22% von Maschinen, 30% der Aufgaben setzten eine Kombination voraus. Bis 2030 erwarten Unternehmen eine Ausweitung des Technikanteils.

Ausblick: HITL 2.0 – Supervisoren und Risikomanagement

Wir betreten das Zeitalter von “Human-in-the-Loop 2.0”. Menschen sind nicht mehr nur Prüfer, sondern agieren als Supervisoren, Coaches und KI-Risikomanager.

Ein Beispiel: Ein Arzt greift bei einer Medizin-KI nur dann ein, wenn Unsicherheit auftritt – sein Input dient nicht nur der Einzelfalllösung, sondern auch zum Retraining und für spätere Prognosen. Das ist augmented intelligence: Mensch und KI lernen gemeinsam.

Das World Economic Forum prognostiziert, dass bis 2030 60 % der Unternehmen digitalen Wandel als Treiber für analytische und Führungsfähigkeiten sehen, während manuelle Tätigkeiten rückläufig sind.

Dazu kommt: 'Human-on-the-Loop' meint, dass Menschen KI-Systeme dauerhaft überwachen und nur bei Bedarf eingreifen – vergleichbar mit der Rolle von Fluglotsen.

Menschen durch KI gestärkt

KI ist nicht nur Teil der Workflows, sondern unterstützt künftig auch die Menschen, die sie beaufsichtigen. Vorstellbar: Ein KI-Modul warnt den Compliance-Verantwortlichen proaktiv: „Diese Entscheidung weicht von bekannten Mustern ab. Bitte prüfen Sie.“ Menschen sind also nicht nur im Loop – KI hilft, den Loop intelligenter zu managen.

Neue Berufsbilder und Verantwortlichkeiten

Bis 2030 sind etwa neue Rollen denkbar:

- AI Feedback Specialist (Feedback-Manager/in)

- Algorithm Ethics Officer (Ethikbeauftragte/r)

- Model Behavior Coach

- Human-in-the-Loop Supervisor (Supervisor/in HI)

Diese sind sowohl für Qualitätssicherung als auch für die Weiterentwicklung von KI verantwortlich. Der Trend geht von der Ausführung hin zur Systemgestaltung.

Laut dem Deloitte Global Human Capital Trends 2026 sagen 57% der Führungskräfte, dass sie Mitarbeitenden beibringen müssen, wie man mit Maschinen denkt, nicht nur wie man sie bedient. Der Fokus verschiebt sich von Ausführung zu strategischer Steuerung.

Trend 5: Mensch-KI-Synergie und ethische KI als Wettbewerbsvorteil

Die Zukunft der KI wird nicht Menschen gegen Maschinen stellen – sondern eine effiziente, ethische und intelligente Zusammenarbeit fördern. Bis 2030 dominieren Unternehmen, die Automatisierung und menschliches Urteil am besten vereinen.

Das ist Augmented Intelligence: KI liefert Geschwindigkeit, Skalierung und Muster, während Menschen Ethik, Empathie und Domänenwissen einbringen. Das Ergebnis: intelligentere Entscheidungen überall.

55 % der Unternehmen haben ein AI Board oder eine Governance-Struktur zur Überwachung von KI-Initiativen aufgebaut, so Gartner.

Warum Synergie siegt

Ab 2026 ist Human-in-the-Loop kein Zusatz, sondern zentrales Merkmal vertrauenswürdiger KI. Ob Kreditvergabe, Auswahlverfahren oder medizinische Empfehlung: Menschliche Validierung sichert Genauigkeit und Vertrauen.

Unternehmen werden HITL zunehmend als Markenvorteil positionieren. Ähnlich wie „nachhaltig erzeugt“ oder „bio-zertifiziert“ erscheinen dann Labels wie „Human-Verified AI“ oder „KI mit menschlicher Kontrolle“ – besonders in sensiblen Branchen wie Gesundheit, Finanzen oder Bildung.

Wer belegen kann „Unsere KI wird von Menschen geprüft“, gewinnt Nutzervertrauen – gerade in Zeiten, in denen KI-Fehler für Skandale sorgen können.

Ethische KI als Geschäftsstrategie

Prominente KI-Pannen zeigen, wie schnell ungeprüfte Automatisierung schaden kann: Ein fehlklassifizierter Lebenslauf, ein diskriminierender Risikoscore, eine fehlerhafte medizinische Diagnose – das alles führt zu Klagen, Shitstorms und Vertrauensverlust.

Wer menschliche Kontrolle in hochriskante KI-Entscheidungen einbaut, erfüllt nicht nur Auflagen, sondern signalisiert Verantwortung gegenüber den Kunden. Ethische KI ist ingen nicht mehr nur Pflicht, sondern unternehmerische Notwendigkeit.

Zertifizierungen und Auditierbarkeit

Bald könnten KI-Systeme für HITL-Compliance zertifiziert werden. Wie ISO-Normen Sicherheit und Qualität bescheinigen, könnten zukünftige KI-Plattformen nachweisen, dass Ergebnisse von Menschen geprüft, erklärt und revidiert werden können.

Das verschafft einen klare Wettbewerbsvorteil. Unternehmen mit transparenter, auditierbarer und menschlich geführter KI gewinnen das Vertrauen von Kunden, Investoren und Behörden.

Das NIST AI Risk Management Framework fordert, KI mit eingebauter Kontrolle zu entwickeln. Human-in-the-Loop und Human-on-the-Loop gelten als Schlüssel, um systemische Risiken zu minimieren. Diese Funktionen könnten künftig für Hochrisiko-KI gesetzlich vorgeschrieben sein.

Human-in-the-Loop by Design

Das Prinzip „HITL by Design“ wird an Bedeutung gewinnen. Statt menschliche Kontrolle nachträglich einzubauen, werden KI-Systeme von Beginn an mit HITL entworfen. Das ist der Wandel hin zu verantwortungsvoller KI, bei der Fairness, Transparenz und Kontrolle zur Produktentwicklung gehören.

Viele Branchenführer leben diesen Ansatz bereits heute.

Am Ende geht es nicht um Mensch gegen Maschine, sondern um Menschen mit Maschinen. — Satya Nadella, CEO von Microsoft

Diese Überzeugung prägt die Entwicklung zahlreicher Produkte – von Unternehmenssoftware bis Consumer-Tech.

Bis 2030: Mensch und KI Hand in Hand

Mit wachsender Geschwindigkeit der KI wird eines klar: Die Zukunft gehört den Unternehmen, die Automatisierung und menschliche Expertise im Gleichgewicht halten.

KI könnte laut PWC bis 2030 bis zu 15,7 Billionen US-Dollar zur Weltwirtschaft beitragen.

HITL verliert mit dem KI-Fortschritt keineswegs an Bedeutung. Im Gegenteil: Es wird zum strategischen Muss, als integraler Teil für ethische, erklärbare und vertrauenswürdige Systeme.

Spätestens 2030 ist menschliche Kontrolle nicht mehr Ausnahme, sondern Designprinzip. HITL ist dann Standard – in Regulierungen wie in Plattformfunktionen. Wer früh handelt, sichert sich nachhaltigen Erfolg.

Man kann es so sehen: So selbstverständlich, wie heute in jedem Auto ein Sicherheitsgurt Standard ist, werden HITL-Mechanismen zur Norm für jede ernsthafte KI-Anwendung – zum Schutz der Nutzer, zur Fehlervermeidung und für verantwortungsbewusste Innovation.

Die Zeit der Vorbereitung ist jetzt: Amazon prognostiziert, dass Europa bis 2030 nahezu vollumfängliche KI-Adoption erlebt.

Führungskräfte und Technikstrategen sollten jetzt:

- In erklärbare KI-Tools und Schnittstellen investieren

- Menschliche Kontrollrollen im Team verankern

- Plattformen wählen, die einfache menschliche Validierung erlauben

- Prozesse so gestalten, dass Menschen und KI standardmäßig zusammenarbeiten

Mit zunehmender Regulierung und Vertrauensbedarf werden diese Praktiken zur Basis für Resilienz, Agilität und ethische Führungsstärke.

Zuletzt aktualisiert am