Puntos Clave

- Para 2030, HITL será un elemento esencial en el diseño de una IA confiable y explicable.

- Las regulaciones requerirán supervisión humana en decisiones sensibles respaldadas por IA.

- La colaboración humano-IA impulsará una automatización ética y escalable.

Un Futuro Híbrido para la IA y las Personas

A medida que avanzamos hacia 2030, una verdad se vuelve cada vez más clara: los sistemas de IA más exitosos no serán los más rápidos ni los más autónomos. Serán los más confiables. Esa confianza surge del equilibrio, combinando la velocidad de la automatización con la experiencia humana.

Las primeras olas de adopción de IA nos enseñaron que, aunque los sistemas autónomos pueden ser robustos, suelen conllevar riesgos como sesgos, falta de transparencia y comportamientos impredecibles. Estos desafíos han reavivado el interés por los sistemas HITL y la IA centrada en el factor humano, no como un retroceso, sino como una estrategia de diseño de futuro.

Se estima que para 2026, más del 90% del contenido en línea será generado por IA y no por humanos. Este cambio subraya la importancia de la confianza y la supervisión en los sistemas automatizados, como menciona Oodaloop.

Para entender las bases de este concepto, explora nuestra guía sobre IA Human-in-the-Loop: Definición y Beneficios, una introducción práctica al uso actual de HITL y su valor empresarial.

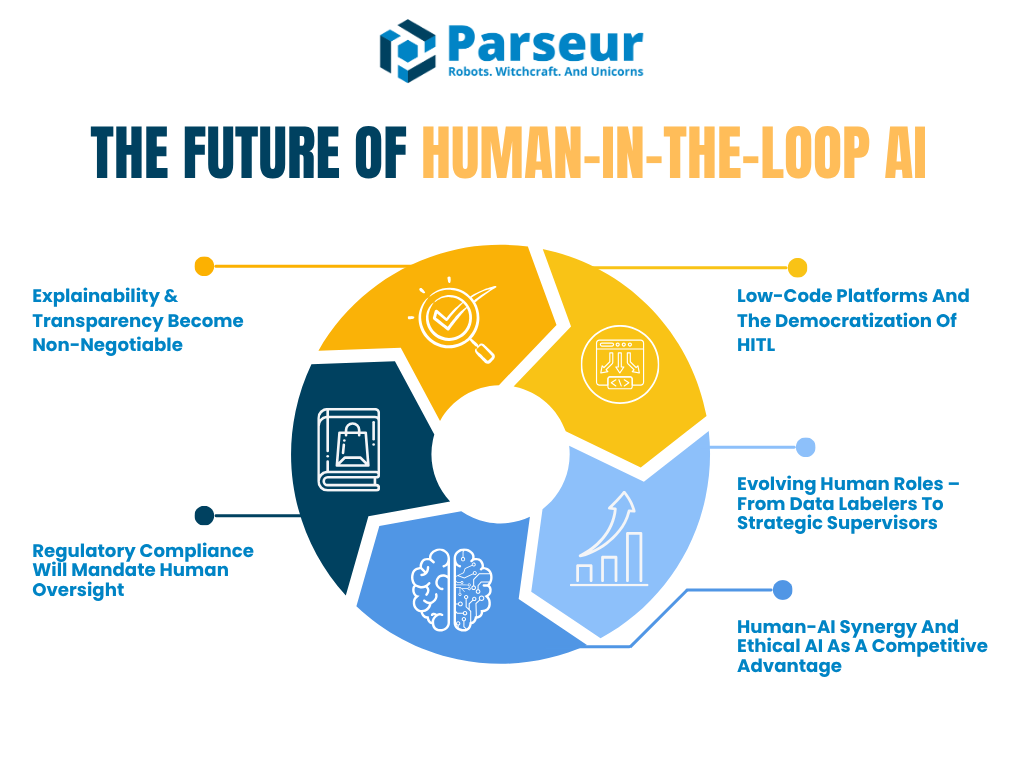

Este artículo explorará cómo evolucionará HITL desde ahora hasta 2030, centrándose en cinco tendencias clave que están dando forma al futuro de la colaboración humano-IA:

- La demanda de IA explicable y auditable

- El auge del cumplimiento regulatorio que exige supervisión humana

- El crecimiento de plataformas low-code que facilitan la implementación de HITL

- La evolución de los roles humanos de etiquetadores de datos a supervisores de IA

- Cómo la sinergia humano-IA se convertirá en una ventaja competitiva

Según Venture Beat, incluso visionarios tecnológicos como Reid Hoffman predicen un futuro modelado por la superagencia de IA, cuando dijo: “El humano que no use IA será reemplazado por humanos que usen IA”, posicionando la IA como un multiplicador de productividad y no como una amenaza.

De acuerdo con el Barómetro Global de Empleo de IA 2026 de PwC, desde la proliferación de la IA generativa en 2022, el crecimiento de la productividad en industrias expuestas a IA casi se cuadruplicó del 7% (2018-2022) al 27% (2018-2024), demostrando cómo la IA amplifica la productividad humana en sectores como servicios financieros y edición de software.

Las organizaciones ya no se ven obligadas a elegir entre automatización y garantía. El futuro está en arquitecturas de IA híbridas que integran el juicio humano en momentos clave, ya sea a través de modelos in-the-loop o on-the-loop.

Tendencia 1: Explicabilidad y Transparencia como Requisitos Indiscutibles

A medida que los sistemas de IA influyen cada vez más en decisiones del mundo real, la pregunta ya no es si la IA puede realizar tareas con precisión. La verdadera preocupación es si los humanos pueden entender y explicar esas decisiones. Aquí es donde entran la IA explicable (XAI) y la transparencia.

En los próximos años, la explicabilidad pasará de ser una buena práctica a un requisito, especialmente en sectores críticos como finanzas, salud, seguros y derecho. Los flujos de trabajo HITL no solo apoyarán la supervisión, sino que permitirán a las organizaciones cumplir con demandas regulatorias y éticas al ubicar a las personas en roles de interpretación, validación y explicación de los resultados de IA.

Según Gartner, para 2026, más del 80% de las empresas habrá utilizado APIs de IA generativa o desplegado aplicaciones habilitadas por IA generativa. Esto destaca la necesidad urgente de explicabilidad y supervisión humana en sistemas de IA en industrias como salud, legal y servicios financieros.

Un gran ejemplo es la Ley de IA de la UE, que ya exige que las aplicaciones de IA de alto riesgo incluyan supervisión humana y la capacidad de explicar los resultados. Al mismo tiempo, el Marco de Gestión de Riesgos de IA de NIST advierte que la falta de claridad sobre los roles HITL y decisiones opacas siguen siendo desafíos serios. Pronto, marcos como el de NIST formalizarán cómo se diseña y documenta la revisión humana.

Perspectiva futura: human-in-the-loop con interfaces de explicación

Para 2030, probablemente las herramientas de IA vendrán con “interfaces de explicación” integradas. Estas interfaces ayudarán a los revisores humanos a entender las decisiones de los modelos. Imagina un sistema de aprobación de créditos que califica a un solicitante y muestra las tres principales razones por las que la IA tomó esa decisión. Esto le da al revisor el contexto necesario para validar la equidad y la precisión.

HITL evolucionará de una revisión manual en cada paso a una validación estratégica en puntos críticos. Ya no se tratará de aprobar resultados uno a uno, sino de asegurar que la lógica subyacente de la IA esté alineada con los valores empresariales, el cumplimiento y los estándares de equidad.

Industrias donde esto ya está ocurriendo

Los sectores de salud y finanzas son pioneros. En estas industrias, la explicabilidad no es solo preferida; es obligatoria. Por ejemplo, un informe de Deloitte Tech Trends 2026 señalaba: “Cuanta más complejidad se añade, más vitales se vuelven los trabajadores humanos.” Esto resalta la paradoja clave de la IA: a medida que la automatización se vuelve más poderosa, la supervisión humana especializada es más crítica.

Este concepto también aparece en el auge de modelos “human-on-the-loop”. En estos sistemas, las personas no necesitan intervenir en cada instante, sino que supervisan continuamente y pueden tomar el control si es necesario, al modo de los pilotos sobre el piloto automático.

Por qué importa

La tendencia hacia la explicabilidad refuerza una verdad mayor: las empresas no pueden escalar la IA sin confianza. Y esa confianza proviene de la transparencia. En el futuro, incluso podríamos ver organizaciones obligadas a mantener “registros de explicación” o informes que resuman cómo se tomaron las decisiones, con humanos encargados de auditar o validar esas explicaciones.

Estos roles humanos son más que reactivos: moldearán la evolución de la IA identificando fallos, aportando contexto y suministrando la base ética de la que la IA carece.

Tendencia 2: El Cumplimiento Regulatorio Exigirá Supervisión Humana

A medida que la IA avanza, también lo hacen las responsabilidades legales y éticas asociadas. Los reguladores globales ponen énfasis en la responsabilidad y la supervisión humana en los sistemas automatizados. Entre 2026 y 2030, podemos esperar una oleada de regulaciones que exigirán formalmente procesos Human-in-the-Loop para muchas aplicaciones de IA de alto impacto.

Gobiernos y entidades como la Unión Europea, los Estados Unidos y NIST coinciden en un punto clave: la IA nunca debe ser una caja negra. Las personas afectadas por decisiones algorítmicas deben poder entenderlas, impugnarlas y, en muchos casos, solicitar una revisión humana.

De hecho, para 2026, más de 700 proyectos de ley relacionados con IA se introdujeron solo en Estados Unidos en 2024, y más de 40 nuevas propuestas a principios de 2026, mostrando un entorno regulatorio en rápida evolución enfocado en la transparencia y la supervisión humana, según Naaia.

El Artículo 22 del RGPD otorga a las personas el derecho a solicitar intervención humana ante decisiones automatizadas. La próxima Ley de IA de la UE exige que los humanos desempeñen un papel significativo en la supervisión y el control de sistemas de alto riesgo. Esto no es solo tendencia, es un nuevo estándar legal.

Perspectiva futura: sistemas HITL impulsados por el compliance

Para 2030, muchas empresas implementarán lo que podría llamarse "HITL de cumplimiento": flujos de trabajo de gobernanza diseñados específicamente para cumplir requisitos regulatorios. Por ejemplo:

- Auditores humanos que registrarán y revisarán decisiones de IA según un calendario definido.

- Algunas organizaciones crearán equipos de supervisión de IA para monitorear sistemas en vivo, al estilo de las salas de control en aviación o ciberseguridad.

- Se agregarán puntos de control humano en las cadenas de decisión donde el riesgo sea alto o la equidad crítica.

Las herramientas y plataformas evolucionarán para facilitar esto. Las empresas podrán utilizar tableros que controlen la precisión del modelo y la frecuencia con la que los revisores humanos anulan las decisiones de IA. Este tipo de trazabilidad se convertirá en un indicador de cumplimiento en sí mismo.

Perspectiva sectorial: auge de la gobernanza híbrida de IA

Los líderes del sector ya adoptan marcos híbridos que mezclan automatización y supervisión humana. Según Gartner, el 67% de las organizaciones maduras han establecido equipos dedicados de IA y presentado cargos como Éticos de IA, Gestores de Modelos e Ingenieros de Conocimiento para garantizar despliegues responsables de IA.

En áreas como datos y análisis, estos cargos ya son estándar porque la supervisión técnica y la responsabilidad ética son el núcleo del éxito de la IA. Para 2030, títulos como “Auditor de IA”, “Gestor de Riesgos de IA” o “Supervisor Human-in-the-Loop” serán habituales, marcando una apuesta estratégica por la supervisión humana dentro de la gobernanza de IA.

Cuando la explicabilidad se une a la regulación

Los reguladores no solo exigirán que haya personas involucradas. Esperarán que puedan explicar por qué se tomaron las decisiones. Esto enlaza con la primera tendencia. La documentación y los registros de auditoría pasarán a ser parte de los procedimientos estándar. El NIST AI RMF ya recomienda que las organizaciones permitan a los humanos anular la IA y monitorear los resultados de forma regular. En el futuro, no cumplir esto podría suponer sanciones regulatorias o la pérdida de certificaciones.

Algunas empresas incluso buscarán "certificaciones de confianza en IA" para demostrar que sus sistemas cuentan con supervisión humana desde el diseño.

Tendencia 3: Plataformas Low-Code y La Democratización

Históricamente, crear un flujo HITL requería recursos de ingeniería, integraciones personalizadas y experiencia profunda en IA. Esto dificultaba que equipos pequeños o sin perfil técnico pudiesen adoptar el modelo. Pero eso está cambiando rápidamente. A partir de 2026, las plataformas low-code y sin conocimientos técnicos requeridos harán que HITL sea accesible a un público mucho más amplio.

Estas plataformas permiten a los usuarios integrar puntos de control humano en flujos de IA sin escribir código. Herramientas como UiPath, Microsoft Power Automate y Amazon A2I ya ofrecen funciones de arrastrar y soltar que incluyen la revisión humana como parte de la automatización de decisiones.

Perspectiva futura: flujos de IA creados por usuarios de negocio

Espera que las plataformas de IA con funciones HITL sean componentes estándar en los próximos años. Para 2026, el 70% de los líderes de experiencia de cliente (CX) planean integrar IA Generativa a lo largo de los puntos de contacto clave, aprovechando herramientas que frecuentemente incluyen HITL para asegurar calidad y supervisión, como destaca AmplifAI.

Esta democratización lo cambia todo. Permite que áreas como operaciones, legal o finanzas implementen sus propias capas de gobernanza de IA. Con más personas construyendo y supervisando IA, las organizaciones pueden escalar con mayor rapidez y seguridad.

En el futuro, incluso los LLM podrán recomendar dónde insertar un paso HITL, según la confianza del modelo o el riesgo de los datos. Las plataformas también incluirán tableros para que las personas vean resúmenes de decisiones, marquen incidencias y mejoren el comportamiento futuro de la IA mediante su feedback.

Revisión humana a demanda impulsada por la multitud

Otra rama de esta tendencia es el crecimiento de la validación humana on-demand y vía crowdsourcing. Servicios como Amazon Mechanical Turk o socios BPO pueden integrarse en los flujos de IA para ofrecer HITL escalable y a bajo coste. Así, las empresas pueden equilibrar automatización y control de calidad sin recurrir a equipos internos grandes.

Imagina un escenario donde una empresa de e-commerce usa IA para procesar reseñas de productos, pero deriva todas las entradas sospechosas a una cola de validación gestionada por un equipo freelance HITL. Es rápido, eficiente y preciso.

Impulso sectorial hacia un HITL accesible

Las plataformas deberán permitir la automatización mediante interfaces low-code pero también brindar personalización a nivel de código. Esta tendencia indica que implementar HITL será tan sencillo como montar una campaña de email o crear una página web.

Esto también encaja con la evolución de Parseur. Mientras Parseur ofrece la flexibilidad de crear tus propias plantillas si no quieres depender del motor de IA, a medida que HITL se consolide como estándar de la automatización inteligente, plataformas como Parseur serán clave para escalar flujos responsables y verificados por humanos en todos los sectores.

Tendencia 4: Evolución de los Roles Humanos – De Etiquetadores de Datos a Supervisores Estratégicos

A medida que mejoran los sistemas de IA, la participación humana está cambiando de naturaleza. En los primeros tiempos de la adopción de IA, los HITL solían realizar tareas repetitivas como el etiquetado de datos o la validación de salidas básicas. Sin embargo, en el futuro estas tareas serán cada vez más gestionadas por IA o externalizadas a trabajadores por crowdsourcing. Esto no significa que los humanos estén siendo desplazados. Al contrario, sus funciones se hacen más estratégicas, especializadas y orientadas al valor.

Según el informe de Statista de 2026, los humanos realizaron el 47% de las tareas laborales, las máquinas el 22%, y un 30% requirió combinación de ambos. Para 2030, las empresas prevén una división aún más equilibrada, con las máquinas asumiendo un mayor porcentaje.

Perspectiva futura: HITL 2.0 como supervisores y gestores de riesgos de IA

Entramos en la era del “Human-in-the-Loop 2.0.” Aquí los humanos no solo son revisores. Son supervisores, entrenadores y gestores de riesgos de IA.

Por ejemplo, un médico que supervisa una IA médica solo intervendrá cuando el sistema muestre incertidumbre o marque una anomalía. Esa intervención humana no solo completa la tarea, sino que permite reentrenar el modelo y mejorar la precisión futura. Eso es inteligencia aumentada, donde humanos e IA aprenden en conjunto.

El Foro Económico Mundial informa que para 2030, el 60% de los empleadores espera que la transformación digital incremente la demanda de habilidades analíticas y de liderazgo, mientras que las manuales disminuyen.

Esto también introduce el concepto de “human-on-the-loop,” donde los humanos monitorizan los sistemas de IA continuamente, interviniendo solo si es necesario. Piensa en ello como un control de tráfico aéreo para sistemas automatizados.

Humanos aumentados por IA

Así como la IA se integra en los flujos de trabajo, también asistirá a los humanos que los supervisan. Imagina una herramienta de IA que alerta proactivamente a un responsable de cumplimiento: “Esta decisión es inconsistente con fallos anteriores. Por favor, revisa.” En el futuro, los humanos no solo estarán en el loop, sino que la propia IA les asistirá para gestionarlo de forma más inteligente.

Nuevos cargos y responsabilidades

Para 2030, podrían surgir títulos como:

- Especialista en Feedback de IA

- Responsable de Ética Algorítmica

- Entrenador de Comportamiento de Modelos

- Supervisor Human-in-the-Loop

Estos roles serán responsables tanto de la garantía de calidad como de guiar la evolución de los sistemas de IA. Es un cambio de la ejecución de tareas a la gestión de sistemas.

Según el informe Global Human Capital Trends 2026 de Deloitte, el 57% de los líderes organizacionales afirma que deben enseñar a los empleados cómo pensar con las máquinas, no solo usarlas. Esto destaca una transformación en los roles humanos, de la ejecución de tareas a la supervisión estratégica.

Tendencia 5: Sinergia Humano-IA y la IA Ética como Ventaja Competitiva

El futuro de la inteligencia artificial no será humanos contra máquinas, sino humanos trabajando junto a las máquinas para resolver problemas de manera más eficiente, ética e inteligente. A medida que las empresas miran hacia 2030, las organizaciones más competitivas serán las que dominen el equilibrio entre la automatización y el criterio humano.

Este cambio se conoce como inteligencia aumentada, donde las fortalezas de la IA (velocidad, escala, reconocimiento de patrones) se combinan con las fortalezas humanas (ética, empatía y experiencia). El resultado es una toma de decisiones más inteligente a todos los niveles.

El 55% de las organizaciones ya han establecido un consejo de IA o cuerpo de gobierno para supervisar las iniciativas de IA, lo que demuestra la creciente importancia de la vigilancia humana y la gobernanza ética en el despliegue de IA, según Gartner.

Por qué la sinergia será la vencedora

Para 2026, la idea de “human-in-the-loop” dejará de ser un recurso opcional de seguridad: será una característica central de cualquier sistema de IA confiable. Desde la aprobación de créditos hasta procesos de selección o diagnósticos médicos, la validación humana será clave para garantizar la precisión y la confianza.

Las organizaciones promocionarán el uso de HITL como diferenciador de marca. Así como “procedencia sostenible” o “orgánico certificado”, podríamos ver etiquetas como “IA verificada por humanos” o “IA con supervisión humana” en mensajes de producto, especialmente en sectores sensibles como salud, finanzas o educación.

Las compañías que puedan decir “las personas revisan nuestra IA” probablemente ganen mayor confianza del usuario, especialmente en una era donde los errores pueden viralizarse y dañar la reputación.

La IA ética como estrategia de negocio

Los fallos mediáticos de IA han demostrado cuán rápido pueden escalar los problemas cuando la automatización no está controlada. Un CV mal clasificado, una puntuación legal sesgada, o un diagnóstico médico erróneo pueden suponer demandas, crisis mediáticas y pérdida de confianza.

Al sumar revisión humana a decisiones de IA de alto impacto, las empresas cumplen las expectativas regulatorias y transmiten responsabilidad a sus clientes. La IA ética ya no es solo una cuestión moral, sino una necesidad de negocio.

Certificaciones y sistemas auditables

Incluso podríamos ver sistemas de IA certificados en cumplimiento con HITL. Como las normas ISO para validar calidad y seguridad, las plataformas de IA llevarán sellos que prueban que las decisiones pueden ser revisadas, explicadas y revertidas por una persona.

Esta tendencia brinda una ventaja competitiva clara. Las empresas con IA transparente, auditable y guiada por personas ganarán la confianza de clientes, inversores y reguladores.

Según el Marco de Gestión de Riesgos de IA de NIST, las organizaciones deben diseñar sistemas IA con supervisión integrada. Esa orientación señala a los roles human-in-the-loop y human-on-the-loop como clave para reducir riesgos sistémicos. En los próximos años, estas funciones de vigilancia podrían ser obligatorias por ley en los usos de IA de mayor impacto.

Human-in-the-loop por diseño

El concepto de "HITL por diseño" seguramente ganará impulso. En vez de agregar la revisión humana como un parche a posteriori, los sistemas de IA se construirán desde la base con HITL como elemento fundamental. Es un reflejo de la IA responsable, donde la equidad, la transparencia y la rendición de cuentas se diseñan en el ciclo de vida del producto.

Los líderes del sector ya adoptan esta mentalidad.

En última instancia, no se tratará de hombre versus máquina. Se tratará de hombre con máquinas. — Satya Nadella, CEO de Microsoft

Esa perspectiva define el desarrollo de productos en múltiples sectores, del software empresarial a la tecnología de consumo.

Hacia 2030: Humanos e IA de la Mano

A medida que la IA acelera, un mensaje es claro: el futuro será de las organizaciones que equilibren la automatización con la experiencia humana.

La IA podría aportar hasta 15,7 billones de dólares a la economía mundial para 2030, según PWC.

HITL no desaparecerá a medida que avance la IA. Al contrario, evolucionará hasta convertirse en una necesidad estratégica, integrada en la arquitectura de la IA ética, explicable y confiable.

Para 2030, la supervisión humana será un principio fundamental de diseño, y no solo un salvavidas temporal. Se esperará HITL en todo, desde marcos regulatorios hasta capacidades de plataforma. Las empresas que lo adopten temprano estarán posicionadas para el éxito a largo plazo.

Piensa en esto: así como los cinturones de seguridad se hicieron indispensables en cada vehículo, los mecanismos HITL serán estándar en todos los despliegues serios de IA. Protegerán usuarios, evitarán errores y asegurarán que la innovación ocurra de manera responsable e inclusiva.

Ahora es el momento de prepararse para ese futuro, ya que Amazon afirma que Europa podría ver una adopción casi universal de IA para 2030.

Los líderes empresariales y estrategas tecnológicos deben empezar por:

- Invertir en herramientas e interfaces de IA explicable

- Crear roles de supervisión humana en todos los equipos

- Elegir plataformas que permitan validar fácilmente con intervención humana

- Diseñar procesos donde humanos e IA colaboren por defecto

A medida que las regulaciones se endurezcan y la confianza pública sea más crítica, estas prácticas sentarán las bases de la resiliencia, la agilidad y el liderazgo ético.

Última actualización el