Principais Conclusões

- Até 2030, HITL será elemento central em projetos de IA confiáveis e explicáveis.

- Regulamentações exigirão supervisão humana em decisões sensíveis envolvendo IA.

- A colaboração entre humanos e IA impulsionará automação ética e escalável.

Um Futuro Híbrido Para IA e Humanos

À medida que nos aproximamos de 2030, uma verdade fica cada vez mais clara: os sistemas de IA mais bem-sucedidos não serão os mais rápidos ou autônomos, mas sim os mais confiáveis. Essa confiança vem do equilíbrio, combinando a agilidade da automação com o know-how humano.

As primeiras ondas de adoção de IA nos ensinaram que, embora sistemas autônomos possam ser robustos, frequentemente apresentam riscos como viés, falta de transparência e comportamentos imprevisíveis. Esses desafios reacenderam o interesse em sistemas HITL e IA centrada no humano, não como uma solução paliativa, mas como uma estratégia de design para o futuro.

Estima-se que até 2026, mais de 90% do conteúdo online será gerado por IA em vez de humanos. Essa mudança ressalta a importância da confiança e supervisão nos sistemas automatizados, como menciona a Oodaloop.

Para entender as bases desse conceito, confira nosso guia sobre Human-in-the-Loop AI: Definição e Benefícios, uma introdução prática ao uso e valor de negócios do HITL.

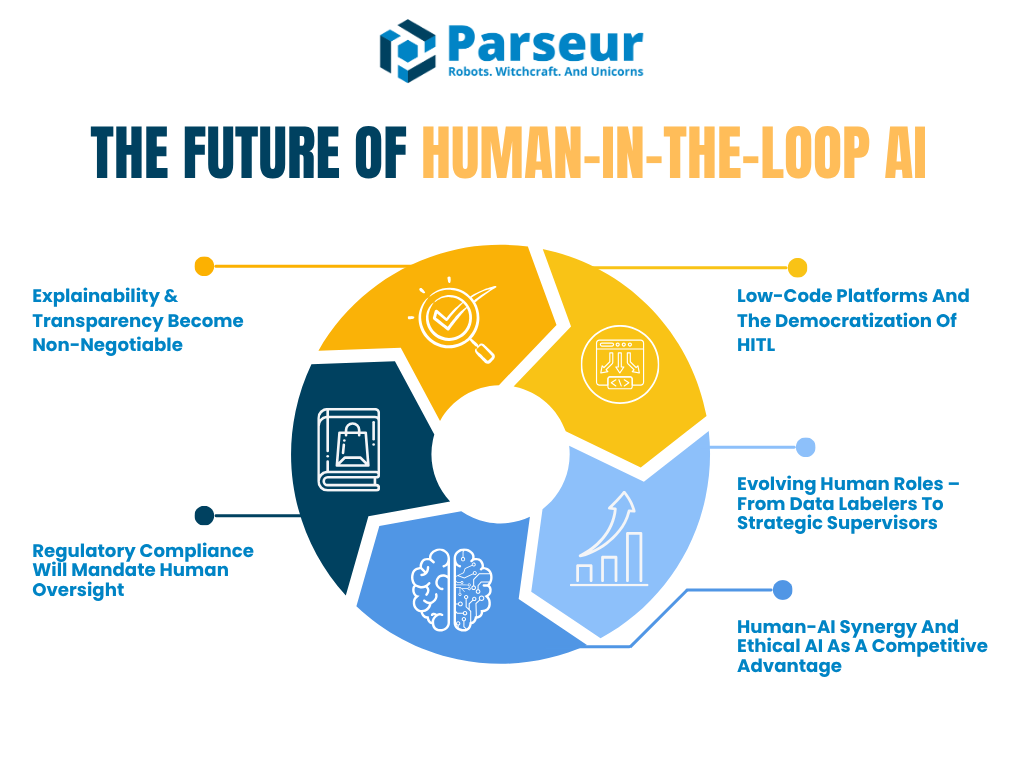

Este artigo explora como o HITL deve evoluir de agora até 2030, com foco em cinco grandes tendências que moldarão o futuro da colaboração humano-IA:

- A demanda por IA explicável e auditável

- O surgimento da conformidade regulatória exigindo supervisão humana

- O crescimento das plataformas low-code que facilitam a implementação de HITL

- A evolução dos papéis humanos: de rotuladores de dados a supervisores de IA

- Como a sinergia humano-IA se tornará um diferencial competitivo

Segundo a Venture Beat, até mesmo visionários como Reid Hoffman preveem um futuro moldado pela superagência de IA, quando afirma: “O humano que não usa IA será substituído pelo humano que usa IA”, posicionando a IA como multiplicador de produtividade, não como ameaça.

Complementando, o Barômetro Global de Empregos em IA 2026 da PwC mostra que desde a disseminação da IA generativa em 2022, o crescimento da produtividade em setores expostos à IA quase quadruplicou, passando de 7% (2018-2022) para 27% (2018-2024), demonstrando como a IA potencializa significativamente a produtividade em setores como serviços financeiros e desenvolvimento de software.

As organizações não precisam mais escolher entre automação e segurança. O futuro está em arquiteturas híbridas de IA que incorporam julgamento humano em pontos críticos, seja por meio de modelos in-the-loop ou on-the-loop.

Tendência 1: Explicabilidade & Transparência Tornam-se Inadiáveis

À medida que sistemas de IA influenciam decisões reais, a questão deixou de ser somente a precisão. A preocupação fundamental é: os humanos conseguem entender e explicar essas decisões? É aí que entram a IA explicável (XAI) e a transparência.

Nos próximos anos, a explicabilidade migrará de boa prática para requisito, especialmente em setores críticos como finanças, saúde, seguros e jurídico. Os fluxos human-in-the-loop não só apoiarão a supervisão como permitirão que organizações atendam demandas regulatórias e éticas, colocando pessoas em funções de interpretação, validação e explicação dos resultados da IA.

Segundo a Gartner, até 2026, mais de 80% das empresas terão utilizado APIs de IA generativa ou implementado aplicações habilitadas por IA generativa. Isso ressalta a urgência da explicabilidade e supervisão humana em indústrias como saúde, jurídica e serviços financeiros.

Um grande exemplo é a Lei de IA da UE, que já exige que aplicações de IA de alto risco tenham supervisão humana e capacidade de justificar resultados. Já o NIST AI Risk Management Framework alerta que a falta de clareza em papéis de HITL e decisões opacas seguem como desafios críticos. Em breve, frameworks como o do NIST formalizarão como a revisão humana deve ser projetada e documentada.

Futuro: human-in-the-loop com interfaces de explicação

Até 2030, as ferramentas de IA devem oferecer “interfaces de explicação” integradas. Essas interfaces ajudarão revisores humanos a entender as decisões dos modelos. Imagine um sistema de aprovação de crédito que atribui uma pontuação e mostra os três principais motivos para aquela decisão. Assim, o revisor tem contexto para validar justiça e precisão.

O HITL evoluirá de revisões manuais a cada passo para validações estratégicas em pontos críticos. Não será mais sobre aprovar linha por linha, mas confirmar se a lógica por trás do resultado da IA está de acordo com valores, conformidade e justiça do negócio.

Setores pioneiros

Setores de saúde e financeiro estão à frente. A explicabilidade, nesses ramos, não é só recomendada; é obrigatória. Por exemplo, um relatório Deloitte Tech Trends 2026 destaca: “Quanto mais complexidade, mais essencial a atuação humana”, ressaltando o paradoxo da IA: quanto mais poderosa a automação, maior a importância da supervisão qualificada.

Esse raciocínio aparece também na ascensão dos modelos “human-on-the-loop”, nos quais humanos não precisam intervir o tempo todo, mas supervisionam continuamente as operações da IA e podem assumir o controle quando necessário, como ocorre com pilotos monitorando o piloto automático.

Por que explicabilidade importa

A explicabilidade reforça um ponto-chave: negócios não escalam IA sem confiança. E tal confiança depende da transparência. Futuramente, organizações podem ser obrigadas a manter “logs de explicação” ou relatórios que detalham como decisões foram tomadas, com humanos encarregados de auditar e validar explicações.

Tais funções humanas deixarão de ser reativas e passarão a moldar a própria evolução dos sistemas de IA, identificando falhas, oferecendo contexto e fornecendo a base ética que a IA não tem.

Tendência 2: Conformidade Regulatória Tornará a Supervisão Humana Obrigatória

À medida que as capacidades da IA avançam, também evoluem as responsabilidades legais e éticas em torno dela. Reguladores globais estão dando mais ênfase à responsabilidade e supervisão humana em sistemas automatizados. Entre 2026 e 2030, podemos esperar uma onda de regulamentações exigindo formalmente processos Human-in-the-Loop em diversas aplicações de IA de alto impacto.

Governos e órgãos como a União Europeia, Estados Unidos e NIST concordam em um ponto: IA não pode ser uma caixa-preta. As pessoas impactadas por decisões algorítmicas precisam compreendê-las, contestá-las e, muitas vezes, solicitar revisão humana.

Na verdade, até 2026, mais de 700 projetos de lei relacionados à IA foram apresentados apenas nos Estados Unidos em 2024, com mais de 40 novas propostas já no início de 2026, refletindo um cenário regulatório em rápida evolução com foco em transparência e supervisão humana, de acordo com Naaia.

Pelo Artigo 22 do GDPR, pessoas podem pedir intervenção humana quando afetadas por decisões automatizadas. A nova Lei de IA da UE reforça a necessidade de supervisão e controle humano sobre sistemas de alto risco. Isso já não é só tendência — está virando padrão legal.

Futuro: sistemas HITL guiados pela conformidade

Até 2030, muitas companhias terão fluxos chamados de "HITL para conformidade". São processos desenhados especificamente para cumprir requisitos regulatórios, por exemplo:

- Auditores humanos revisando e registrando decisões de IA periodicamente

- Equipes de supervisão de IA monitorando sistemas em operação, semelhantes a salas de controle na aviação ou cibersegurança

- Checkpoints humanos em fluxos críticos, especialmente onde o risco é alto ou a justiça é mandatória

Ferramentas e plataformas serão adaptadas para facilitar esse monitoramento. Organizações poderão usar dashboards que acompanham a precisão do modelo e a frequência de revisões humanas. Esse tipo de rastreabilidade será um indicador de conformidade regulatória.

Visão de especialistas: ascensão da governança híbrida de IA

Líderes do setor já estão adotando frameworks híbridos, combinando automação com supervisão humana. Segundo a Gartner, 67% das empresas maduras criaram equipes dedicadas a IA e cargos como Especialista em Ética de IA, Gerente de Modelos e Engenheiro do Conhecimento para garantir o uso responsável da IA.

Essas funções já se tornam padrão em áreas como dados e analytics, à medida que as organizações reconhecem que a supervisão técnica e ética é central para o sucesso da IA. Devemos ver títulos como “Auditor de IA”, “Gestor de Risco em IA” ou “Supervisor Human-in-the-Loop” se popularizando até 2030, sinalizando a mudança estratégica de embarcar a supervisão humana na governança de IA.

Explicabilidade e regulação de mãos dadas

Reguladores não exigirão só a presença humana, mas que os humanos possam explicar o motivo das decisões. Isso se conecta à primeira tendência. Documentação e trilhas de auditoria passarão a ser praxe. O NIST AI RMF já recomenda que as organizações capacitem humanos a sobrepor decisões da IA e monitorem saídas regularmente. Em breve, descumprir esse processo pode resultar em sanções ou perda de certificação.

Algumas organizações poderão buscar certificações de confiança em IA para comprovar que seus sistemas são governados com responsabilidade e supervisão humana desde o início.

Tendência 3: Plataformas Low-Code e a Democratização

Tradicionalmente, construir fluxos HITL exigia muitos recursos de engenharia, integrações customizadas e profundo conhecimento em IA — o que dificultava sua adoção por equipes menores ou usuários não técnicos. Mas essa barreira está sumindo rapidamente. A partir de 2026, plataformas low-code e que não requerem conhecimento técnico devem tornar HITL acessível a um público muito mais amplo.

Essas plataformas permitem adicionar checkpoints humanos aos fluxos de IA sem escrever uma linha de código. Já existem ferramentas como UiPath, Microsoft Power Automate e Amazon A2I com recursos de arrastar e soltar para incorporar revisão humana nos processos automáticos.

Futuro: fluxos de IA criados por áreas de negócio

Espere ver plataformas de IA com HITL como componente padrão nos próximos anos. Até 2026, 70% dos líderes de experiência do cliente (CX) planejam integrar IA Generativa nos pontos de contato, utilizando ferramentas que já incluem recursos HITL para garantir qualidade e supervisão, como aponta a AmplifAI.

Essa democratização é um divisor de águas. Permite que áreas como operações, jurídico e finanças apliquem suas próprias camadas de governança de IA. Com mais pessoas construindo e monitorando IA, organizações poderão escalar com mais segurança.

No futuro, até LLMs poderão sugerir onde inserir um passo HITL, conforme a confiança do modelo ou o risco do dado. Plataformas também incluirão painéis de monitoramento, onde humanos poderão visualizar decisões, sinalizar problemas e melhorar a IA por meio de feedback.

Validação humana sob demanda e crowd-sourcing

Outro aspecto dessa tendência é o crescimento da validação humana via crowd-sourcing ou sob demanda. Serviços como Amazon Mechanical Turk ou parceiros de BPO podem ser integrados a pipelines de IA para oferecer HITL escalável e de baixo custo. Isso permite equilibrar automação e garantia de qualidade sem criar grandes equipes internas.

Imagine uma empresa de e-commerce usando IA para processar análises de produtos, mas direcionando entradas suspeitas para uma fila de validação humana feita por freelancers HITL. É rápido, eficiente e preciso.

Empurrão da indústria para HITL acessível

Plataformas devem viabilizar automação com interfaces low-code, mas também flexibilizar customizações avançadas. Este movimento indica que implementar HITL será tão fácil quanto criar uma campanha de e-mail ou montar um site.

Isso também se alinha à evolução do Parseur. O Parseur já oferece flexibilidade para criar seus próprios templates caso não queira depender do mecanismo de IA. À medida que o HITL se consolida como componente padrão da automação inteligente, plataformas como Parseur serão essenciais para escalar fluxos éticos e validados por humanos em todos os setores.

Tendência 4: Evolução dos Papéis Humanos – De Rotuladores para Supervisores Estratégicos

Com a sofisticação dos sistemas de IA, a natureza da participação humana se transforma. No início, HITLs realizavam tarefas repetitivas como rotular dados ou validar saídas básicas. No futuro, essas funções estarão cada vez mais automatizadas ou terceirizadas via crowd-sourcing. Isso não significa exclusão dos humanos — o papel passa a ser mais estratégico, especializado e orientado ao valor.

No relatório Statistica de 2026, humanos executaram 47% das tarefas, máquinas 22%, e 30% exigiram combinação de ambos. Para 2030, prevê-se uma divisão mais equilibrada, com máquinas assumindo maior participação.

Futuro: HITL 2.0 — supervisores e gestores de risco de IA

Estamos entrando na era do "Human-in-the-Loop 2.0". Nesse modelo, humanos deixam de ser apenas revisores e passam a ser supervisores, coaches e gestores de risco da IA.

Por exemplo, um médico acompanhando uma IA diagnóstica só intervém quando o sistema apresenta incerteza ou sinaliza uma anomalia. Esse input humano é então utilizado não só para completar a tarefa, mas para re-treinar o modelo e melhorar previsões futuras. É a inteligência aumentada em ação — humanos e IA aprendem juntos.

O Fórum Econômico Mundial aponta que até 2030, 60% dos empregadores devem demandar competências analíticas e de liderança, enquanto habilidades manuais perdem espaço.

Entra em cena também o conceito de "human-on-the-loop", no qual humanos monitoram continuamente sistemas de IA e intervêm só quando necessário — como um controlador de tráfego aéreo para sistemas automáticos.

Humanos ampliados pela IA

Assim como a IA integra fluxos de trabalho, também auxiliará os humanos na supervisão. Imagine uma ferramenta de IA alertando um responsável por compliance: "Esta decisão é inconsistente com julgamentos anteriores. Por favor, revise." No futuro, humanos não só estarão no loop, mas também serão potencializados pela IA para gerir esse loop com ainda mais inteligência.

Novos cargos e responsabilidades

Até 2030, podemos ver títulos como:

- Especialista em Feedback de IA

- Responsável por Ética Algorítmica

- Treinador de Comportamento de Modelos

- Supervisor Human-in-the-Loop

Esses papéis atuarão não apenas na garantia da qualidade, mas no direcionamento da evolução dos sistemas de IA. É a transição da execução para a curadoria do sistema.

De acordo com o relatório global de Capital Humano da Deloitte, 57% dos líderes dizem ser necessário ensinar colaboradores a pensar com as máquinas, e não só usá-las. O papel humano migra da execução de tarefas para uma supervisão estratégica.

Tendência 5: Sinergia Humano-IA e IA Ética Como Diferencial Competitivo

O futuro da inteligência artificial não será sobre humanos versus máquinas. Será sobre humanos trabalhando junto com máquinas para resolver problemas de forma mais eficiente, ética e inteligente. Olhando para 2030, as organizações mais competitivas serão aquelas que dominarem o equilíbrio entre automação e julgamento humano.

Esse movimento chama-se inteligência aumentada, quando pontos fortes da IA (velocidade, escala, reconhecimento de padrões) se unem aos talentos humanos (ética, empatia, expertise). O resultado é uma tomada de decisão mais inteligente em todos os níveis.

55% das organizações já estabeleceram conselhos ou instâncias de governança para IA, explicitando a centralidade da supervisão humana e governança ética, segundo a Gartner.

Por que a sinergia será vencedora

Até 2026, o conceito de "human-in-the-loop" deixará de ser opção de segurança para se tornar componente central dos sistemas confiáveis de IA. De aprovações de crédito a admissões ou recomendações médicas, a validação humana sustentará precisão e confiança.

Empresas passarão a divulgar o uso de HITL como diferencial de marca. Assim como “sustentável” ou “orgânico certificado”, veremos selos como “IA Verificada por Humanos” ou “IA com Supervisão Humana” em produtos, especialmente em áreas sensíveis como saúde, finanças e educação.

Empresas que afirmam “Nossas IA são revisadas por pessoas” tenderão a conquistar mais confiança, especialmente em tempos de possíveis falhas de IA viralizarem e prejudicarem reputações.

IA ética como estratégia de negócio

Falhas notórias mostram como a automação sem checagem pode escalar riscos em segundos. Um currículo mal classificado, um score legal enviesado ou um diagnóstico errado gera demandas judiciais, repercussão midiática e desconfiança dos clientes.

Ao integrar revisão humana em decisões críticas, empresas não apenas atendem exigências legais, mas assumem responsabilidade perante o consumidor. A ética em IA já não é só questão moral, mas necessidade competitiva.

Certificações e sistemas auditáveis

Podemos ver sistemas de IA certificados quanto à conformidade HITL. Assim como padrões ISO atestam qualidade em sistemas industriais, plataformas futuras terão selos provando que decisões podem ser revisadas, explicadas e revertidas por humanos.

Essa tendência gera uma vantagem competitiva clara. Empresas com IA transparente, auditável e guiada por pessoas conquistarão confiança de clientes, investidores e reguladores.

De acordo com o NIST AI Risk Management Framework, as organizações devem projetar sistemas de IA já prevendo supervisão humana. Essa diretriz exalta papéis human-in-the-loop e human-on-the-loop como centrais para mitigar riscos sistêmicos. Em breve, essas funções poderão ser exigidas por lei em aplicações de alto impacto.

Human-in-the-loop by design

O conceito de "HITL by design" deve ganhar força. Em vez de construir a revisão humana depois, sistemas de IA deverão nascer com HITL como elemento fundamental, refletindo uma abordagem de IA responsável, com justiça, transparência e accountability desde a origem.

Setores líderes já abraçam este modelo.

No fim das contas, não será homem versus máquina. Será homem com máquinas. — Satya Nadella, CEO da Microsoft

Esse entendimento pauta o desenvolvimento de produtos em todos os segmentos, do software corporativo à tecnologia de consumo.

Rumo a 2030: Humanos e IA Lado a Lado

Com a aceleração da IA, uma mensagem se sobressai: o futuro pertence às organizações que equilibrarem automação com expertise humana.

A IA pode contribuir com até US$ 15,7 trilhões para a economia global até 2030, segundo a PWC.

O HITL não desaparecerá à medida que a IA avança. Ao contrário, evoluirá para necessidade estratégica, embutida no núcleo de sistemas éticos, explicáveis e confiáveis de IA.

Até 2030, a supervisão humana será princípio fundamental de design, não uma proteção temporária. HITL será expectativa em frameworks regulatórios e funcionalidades de plataforma. Quem adotar primeiro, estará melhor posicionado para liderar a longo prazo.

Pense da seguinte forma: assim como o cinto de segurança se tornou obrigatório nos veículos, mecanismos HITL serão padrão em todo projeto sério de IA — para proteger, evitar erros e garantir inovação responsável e inclusiva.

É hora de se preparar, já que a Amazon aponta para adoção quase universal de IA na Europa até 2030.

Líderes e estrategistas podem começar por:

- Investir em ferramentas e interfaces de IA explicável

- Criar funções de supervisão humana nas equipes

- Escolher plataformas com validação humana facilitada

- Projetar processos em que humanos e IA colaborem como padrão

Com o aumento da regulação e a centralidade da confiança, esses passos serão o alicerce para resiliência, agilidade e liderança ética rumo à próxima onda da IA.

Última atualização em