Belangrijkste inzichten

- In 2030 is Human-in-the-Loop (HITL) een essentieel ontwerpelement voor vertrouwde en uitlegbare AI.

- Nieuwe regelgeving stelt menselijke controle bij gevoelige AI-beslissingen verplicht.

- Synergie tussen mens en AI wordt drijvende kracht achter ethische en schaalbare automatisering.

Een Hybride Toekomst Voor AI En Mensen

Naarmate we richting 2030 gaan, wordt één ding steeds duidelijker: de succesvolste AI-systemen zijn niet per se de snelste of meest zelfstandige, maar de betrouwbaarste. Die betrouwbaarheid ontstaat door balans: de snelheid van automatisering gekoppeld aan menselijke deskundigheid.

De vroege fases van AI-adoptie leerden ons dat autonome systemen krachtig zijn, maar vaak risico’s met zich meebrengen zoals bias, gebrek aan transparantie en onvoorspelbaar gedrag. Deze uitdagingen hebben geleid tot hernieuwde interesse in HITL-systemen en mensgerichte AI – niet als terugvaloptie, maar als vooruitstrevende ontwerpstrategie.

Naar schatting zal tegen 2026 meer dan 90% van de online content door AI zijn gegenereerd in plaats van door mensen. Deze verandering benadrukt het belang van vertrouwen en toezicht op geautomatiseerde systemen, zoals genoemd door Oodaloop.

Wil je het fundament van dit concept begrijpen? Lees dan onze gids over Human-in-the-Loop AI: Definitie en Voordelen, een praktische introductie in het huidige gebruik en de zakelijke waarde van HITL.

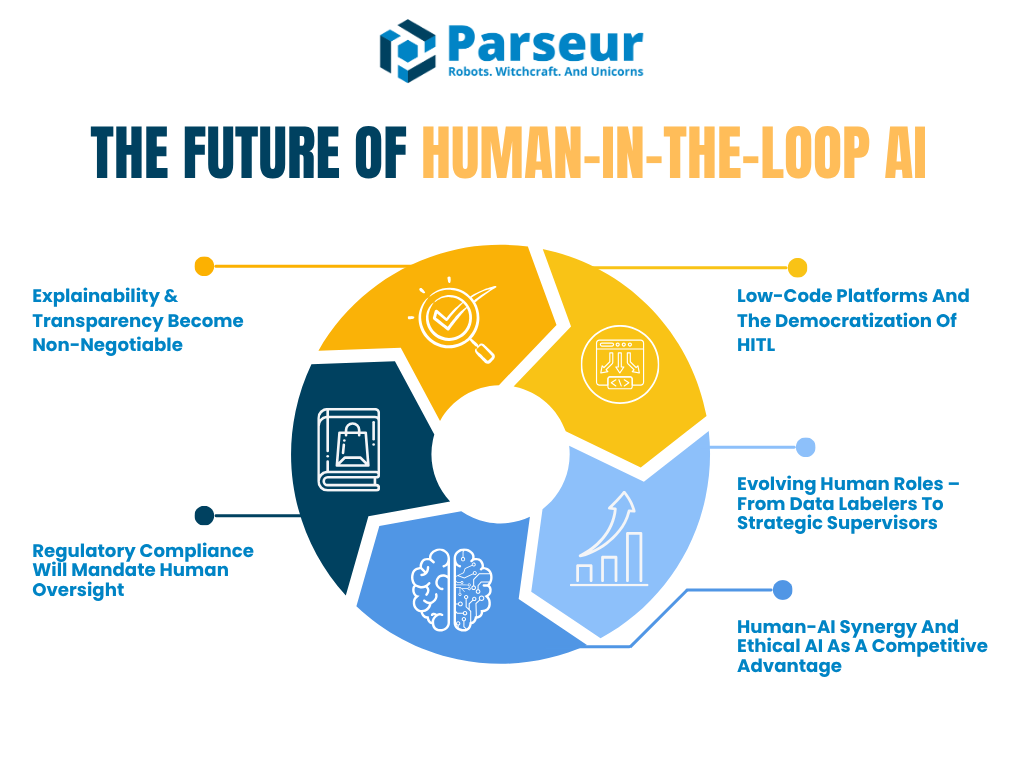

In dit artikel ontdek je hoe HITL zich tot 2030 zal ontwikkelen. We bespreken vijf trends die de toekomst van mens-AI-samenwerking gaan vormen:

- Toenemende vraag naar verklaarbare en controleerbare AI

- Opkomst van regelgeving die menselijke controle vereist

- Groei van low-code platforms die eenvoudigere HITL-implementatie mogelijk maken

- Evolutie van menselijke rollen van datalabellers tot AI-supervisors

- Hoe mens-AI-synergie een sterk concurrentievoordeel wordt

Volgens Venture Beat voorspellen visionairs als Reid Hoffman een toekomst waarin AI-superagency centraal staat: “Mensen die geen AI gebruiken zullen vervangen worden door mensen die AI wel gebruiken,” waarbij AI geldt als productiviteitsvermenigvuldiger, niet als bedreiging.

Hierop aansluitend toont PwC’s Global AI Jobs Barometer voor 2026 dat sinds de opkomst van generatieve AI in 2022, de productiviteitsgroei in AI-intensieve sectoren bijna is verviervoudigd van 7% (2018-2022) naar 27% (2018-2024). Dit laat zien hoe AI menselijke prestaties in sectoren als financiële dienstverlening en software drastisch vergroot.

Organisaties hoeven niet meer te kiezen tussen automatisering en zekerheid. De toekomst ligt in hybride AI-architecturen waarbij menselijk oordeel precies daar is ingebed waar dat kritisch is, zowel via in-the-loop als on-the-loop modellen.

Trend 1: Verklaarbaarheid & Transparantie Worden Randvoorwaarde

Nu AI-systemen steeds vaker echte beslissingen beïnvloeden, gaat het niet alleen meer om accuraatheid – de echte vraag is of mensen deze beslissingen begrijpen en kunnen uitleggen. Hier krijgen verklaarbare AI (XAI) en transparantie een centrale plek.

De komende jaren verschuift verklaarbaarheid van best practice naar vereiste, vooral in risicovolle sectoren als financiën, gezondheidszorg, verzekeringen en recht. Human-in-the-loop-workflows ondersteunen niet alleen toezicht. Ze maken het mogelijk organisaties te laten voldoen aan regelgeving en ethische eisen, door mensen als interpretator, validator en uitlegger van AI-uitkomsten in te zetten.

Volgens Gartner zal tegen 2026 meer dan 80% van de ondernemingen generatieve AI-API’s gebruiken of generatieve AI-toepassingen hebben geïmplementeerd. Dat maakt de roep om uitlegbaarheid en menselijk toezicht in AI-systemen des te urgenter – in onder meer de zorg, juridische sector en financiële dienstverlening.

Een goed voorbeeld is de EU AI Act, die eist dat risicovolle AI-toepassingen menselijke controle en de mogelijkheid tot uitleg bevatten. Ondertussen waarschuwt het NIST AI Risk Management Framework dat onduidelijkheid over HITL-rollen en ondoorzichtige besluitvorming een serieus risico blijven. Kaders als die van NIST zullen binnenkort formeel maken hoe menselijke review wordt ontworpen en vastgelegd.

Toekomstvisie: human-in-the-loop met uitleginterfaces

Tegen 2030 bevatten AI-tools waarschijnlijk standaard “explanation interfaces”. Die maken het mensen makkelijk om beslissingen van modellen te begrijpen. Stel je een kredietbeoordelingssysteem voor dat een score geeft en de drie belangrijkste redenen daarvoor toont. Zo hebben reviewers de context om eerlijkheid en juistheid te beoordelen.

HITL verschuift van handmatige controle bij elke stap naar strategische validatie op kritieke momenten. Niet langer wordt elke output goedgekeurd. Het draait om bevestigen dat de logica achter de AI-uitkomst past bij bedrijfswaarden, compliance en eerlijkheid.

Sectoren waar dit al gebeurt

De zorg en financiële sector zijn hierin voorlopers. Hier is uitlegbaarheid wettelijk verplicht. Zo stelt een 2026 Deloitte Tech Trends rapport: “Hoe meer complexiteit, hoe belangrijker de mens.” Dit toont aan dat hoe geavanceerder AI, hoe onmisbaarder menselijke controle wordt – niet minder.

Dit zie je terug in het “human-on-the-loop”-model: mensen zijn niet bij elke stap nodig, maar monitoren het systeem voortdurend en kunnen ingrijpen als het moet – net als piloten bij autopilots.

Waarom het ertoe doet

De trend richting uitlegbaarheid bekrachtigt een grotere waarheid: bedrijven kunnen AI niet opschalen zonder vertrouwen. En dat vertrouwen ontstaat door transparantie. Mogelijk gaan organisaties straks uitleglogs of rapporten bijhouden met mensen die verantwoordelijk zijn voor de controle en goedkeuring van die uitleg.

Deze menselijke rollen zijn niet reactief, maar bepalen mede de ontwikkeling van AI-systemen door fouten te signaleren, context te bieden en morele richting te geven die AI niet heeft.

Trend 2: Regelgeving Zal Menselijke Controle Eisen

Nu AI krachtiger wordt, groeien ook de juridische en ethische plichten. Regulatoren benadrukken verantwoording en menselijke controle bij geautomatiseerde systemen. Tussen 2026 en 2030 kun je nieuwe regelgeving verwachten die formele Human-in-the-Loop-processen verplicht stelt bij veel impactvolle AI-toepassingen.

Overheden en normorganisaties zoals de EU, de VS, en NIST zijn het over één ding eens: AI mag nooit een black box zijn. Wie door een algoritme geraakt wordt, moet het kunnen begrijpen, aanvechten en veelal menselijke beoordeling kunnen eisen.

In feite zijn er in 2026 meer dan 700 AI-gerelateerde wetsvoorstellen in de VS gelanceerd in 2024, met meer dan 40 nieuwe voorstellen in het begin van 2026, aldus Naaia.

Volgens GDPR Artikel 22 mogen mensen menselijke tussenkomst eisen bij geautomatiseerde besluitvorming. De komende EU AI Act borduurt hier op voort en verplicht dat mensen een betekenisvolle rol spelen bij het controleren en sturen van bepaalde risicovolle systemen. Dit is niet alleen een trend – het wordt het juridische minimum.

Toekomstvisie: compliance-gedreven HITL-systemen

Tegen 2030 bouwen veel organisaties wat je zou kunnen noemen "compliance HITL". Dit zijn governance-workflows expliciet ontworpen om aan regelgeving te voldoen, bijvoorbeeld:

- Auditors die AI-besluiten op afgesproken momenten controleren en beoordelen.

- Organisaties richten AI-toezichtteams op die live systemen monitoren, vergelijkbaar met controlekamers in luchtvaart of cyberbeveiliging.

- Menselijke checkpoints in beslisprocessen waar risico’s groot zijn of eerlijkheid cruciaal is.

Tools en platforms zullen zich hierop aanpassen. Bedrijven gebruiken dashboards die modelnauwkeurigheid volgen en bijhouden hoe vaak menselijke reviewers AI-besluiten wijzigen. Traceerbaarheid wordt zo een compliance-metriek op zich.

Expert opinion: opkomst van hybride AI-governance

Voorlopers kiezen nu al voor hybride frameworks: automatisering gecombineerd met menselijke controle. Volgens Gartner heeft 67% van de volwassen organisaties speciale AI-teams en nieuwe rollen zoals AI Ethicists, Model Managers en Knowledge Engineers gecreëerd voor verantwoord AI-gebruik.

In sectoren als data en analytics raken deze functies steeds meer ingeburgerd, omdat technische controle en ethische verantwoording fundamenteel zijn voor AI-succes. Titels zoals "AI Auditor", "AI Risk Manager" of "Human in the Loop Supervisor" zullen tegen 2030 wijdverspreid zijn – dit laat de structurele verschuiving zien naar menselijke controle als vast onderdeel van AI-governance.

Verklaarbaarheid gekoppeld aan regelgeving

Regulators eisen straks niet alleen menselijke betrokkenheid, maar verwachten ook dat die mensen kunnen uitleggen waarom beslissingen zijn gemaakt. Daarmee koppelt deze trend terug aan de eerste trend over uitlegbaarheid. Documentatie en audittrails worden standaard onderdeel van het proces. De NIST AI RMF adviseert organisaties mensen toe te staan AI te overrulen en resultaten continu te monitoren. Het niet voldoen hieraan kan in de toekomst leiden tot sancties of verlies van certificering.

Sommige bedrijven streven straks zelfs naar "AI trust certificeringen" om te laten zien dat hun systemen verantwoord en met menselijke controle zijn opgezet.

Trend 3: Low-Code Platforms En De Democratisering

Vroeger was een HITL-workflow bouwen iets voor engineers met diepgaande AI-kennis. Nu verdwijnt die drempel snel. Tegen 2026 en daarna zullen low-code- en geen-techniek-nodig-platforms HITL breed toegankelijk maken.

Deze platforms maken het mogelijk om zonder één regel code menselijke checkpoints in AI-workflows te integreren. Nu al bieden tools zoals UiPath, Microsoft Power Automate en Amazon A2I drag-and-drop-features waarmee menselijke review standaard in besluitautomatisering wordt opgenomen.

Toekomstvisie: AI-workflows gebouwd door business users

Reken erop dat AI-platforms met HITL functies de komende jaren standaard zijn. Tegen 2026 wil 70% van de CX-leiders Generatieve AI integreren bij klantcontact, gebruikmakend van tools waarin vaak HITL features zitten om kwaliteit en toezicht te waarborgen, aldus AmplifAI.

Deze democratisering is een gamechanger. Afdelingen als operations, legal of finance implementeren zo zélf hun AI-governanceprocessen. Doordat meer mensen AI bouwen en controleren, groeien bedrijven sneller en veiliger.

Straks kunnen zelfs LLMs aanbevelen waar je een human-in-the-loop stap plaatst, bijvoorbeeld bij lage modelzekerheid of datarisico. Platforms bieden dashboards waarmee mensen beslissamenvattingen zien, problemen signaleren, en het AI-gedrag verder verbeteren via feedback.

Crowd-powered menselijke review

Een deel van deze trend is de opkomst van crowd-sourced of on-demand mensvalidatie. Diensten als Amazon Mechanical Turk of BPO-partners kunnen in een AI-pijplijn worden geïntegreerd voor schaalbare, betaalbare HITL. Zo balanceren bedrijven automatisering met kwaliteitscontrole zonder grote interne teams.

Stel dat een e-commerce bedrijf AI gebruikt voor het beoordelen van productreviews, maar verdachte gevallen doorstuurt naar een menselijke HITL-queue bemand door freelancers. Snel, efficiënt en accuraat.

Momentum richting toegankelijke HITL

Platforms moeten automatisering aanbieden via low-code interfaces zonder code-kennis, én maatwerk mogelijk maken voor ontwikkelaars. Deze trend betekent dat HITL straks net zo makkelijk is als een e-mailcampagne opzetten of een website bouwen.

Dit past ook bij de koers van Parseur. Bij Parseur kun je ook je eigen templates maken als je niet op de AI-engine wilt vertrouwen. Omdat HITL een standaardonderdeel wordt van intelligente automatisering, worden platforms zoals Parseur onmisbaar voor het grootschalig implementeren van verantwoorde, mens gecontroleerde workflows.

Trend 4: Evoluerende Menselijke Rollen – Van Data Labellers Tot Strategische Supervisors

Nu AI-systemen verbeteren, verandert de aard van menselijke deelname. In de beginfase van AI deden HITLs vaak repetitief werk zoals data labelen of simpele uitkomsten controleren. In de toekomst doet AI deze taken steeds meer zelf, of worden ze geoutsourcet aan crowdworkers. Dat betekent niet dat mensen overbodig worden – hun rol wordt juist strategischer, specialer en waardevoller.

In het Statistica** rapport 2026 behandelden mensen 47% van de werktaken, machines 22% en 30% werd door beiden gezamenlijk gedaan.** Tegen 2030 verwacht men een nog evenwichtigere verdeling, waarbij machines een groter aandeel op zich nemen.

Toekomstvisie: HITL 2.0 als AI-supervisors en risicomanagers

We betreden het tijdperk van "Human-in-the-Loop 2.0”. Hier zijn mensen geen reviewers meer, maar supervisors, coaches en AI-risicomanagers.

Bijvoorbeeld: een arts controleert slechts een AI-systeem bij onzekerheid of een afwijking. Die menselijke inbreng wordt niet alleen gebruikt voor een enkele beslissing, maar om het model te trainen en de accuratesse te verbeteren. Dit is augmented intelligence in de praktijk, waarin mens en AI samen leren.

Het World Economic Forum stelt dat tegen 2030, 60% van de werkgevers verwacht dat digitale transformatie vooral behoefte creëert aan analytische vaardigheden en leiderschap, terwijl routinematige skills afnemen.

Dit leidt ook tot het concept van "human-on-the-loop", waarbij mensen AI-systemen continu monitoren en alleen ingrijpen als het nodig is – vergelijkbaar met luchtverkeersleiding voor geautomatiseerde systemen.

Mensen, versterkt door AI

AI is niet alleen in workflows ingebed, maar ondersteunt ook diegenen die toezicht houden. Denk aan een AI-tool die een compliance officer proactief waarschuwt: “Deze beslissing wijkt af van eerdere uitspraken. Controleer alsjeblieft.” In de toekomst zijn mensen niet alleen in-the-loop, AI helpt hen bovendien slimmer om het toezicht uit te voeren.

Nieuwe titels en verantwoordelijkheden

In 2030 zie je functiebenamingen als:

- AI Feedback Specialist

- Algorithm Ethics Officer

- Model Behavior Coach

- Human-in-the-Loop Supervisor

Deze professionals waarborgen kwaliteit en sturen de evolutie van AI-systemen. De focus verschuift van taakuitvoering naar systeemverantwoordelijkheid.

Uit het Deloitte 2026 Global Human Capital Trends rapport blijkt dat 57% van de organisatieleiders zegt werknemers te willen leren hoe te denken mét machines, niet alleen werken ermee. Dit benadrukt de verschuiving van taakuitvoering naar strategisch toezicht.

Trend 5: Mens-AI-synergie & Ethische AI Als Concurrentievoordeel

De toekomst van AI draait niet meer om mens versus machine. Het draait om mensen die mét machines werken om efficiënter, ethischer en slimmer te zijn. Richting 2030 zijn de winnende organisaties zij die het beste balanceren tussen automatisering en menselijk oordeel.

Dit staat bekend als augmented intelligence: AI brengt snelheid, schaal en patroonherkenning samen met menselijke kracht: ethiek, empathie en domeinkennis. Het resultaat: slimmer, beter onderbouwd beslissen.

55% van de organisaties heeft een AI-board of governance body aangesteld voor toezicht op AI-initiatieven, wat het groeiende belang van menselijke controle en ethisch toezicht op AI aantoont, aldus Gartner.

Waarom synergie wint

Tegen 2026 is "human-in-the-loop" niet langer optioneel, maar een kernonderdeel van betrouwbare AI. Van kredietbesluiten tot werving en zorgtoepassingen: menselijke validatie bepaalt nauwkeurigheid en vertrouwen.

Bedrijven zetten hun HITL-strategie steeds actiever in als merkonderscheidend. Net als labels als “sustainably sourced” of “certified organic”, krijg je straks termen als “Human-Verified AI” of “AI met Human Oversight” in productboodschappen, zeker in gevoelige sectoren als zorg, financiën en onderwijs.

Organisaties die zeggen “bij ons controleren mensen de AI” winnen sneller het vertrouwen – zeker nu AI-fouten direct viral kunnen gaan en reputatieschade veroorzaken.

Ethische AI als business-strategie

Zichtbare AI-fails laten zien hoe snel het mis gaat bij ongecontroleerde automatisering. Een verkeerd gelabeld cv, een bevooroordeelde juridische score of een foute medische diagnose leiden direct tot claims, kritiek en wantrouwen.

Door menselijke controle te integreren bij risicovolle AI-beslissingen voldoen bedrijven aan regelgeving én stellen ze klanten gerust met hun verantwoordelijkheidsgevoel. Ethische AI is niet langer alleen een morele kwestie – het is een zakelijke noodzaak.

Certificaten en auditeerbare systemen

Straks zie je AI-systemen gecertificeerd op HITL-conformiteit – vergelijkbaar met ISO-normen voor veiligheid en kwaliteit – als bewijs dat beslissingen door mensen te beoordelen, uit te leggen én terug te draaien zijn.

Dit biedt een duidelijk concurrentievoordeel. Transparante, auditeerbare en mensgestuurde AI wint het vertrouwen van klanten, investeerders en toezichthouders.

Volgens het NIST AI Risk Management Framework moeten organisaties AI-systemen ontwerpen met ingebouwd toezicht. Daarin zijn human-in-the-loop en human-on-the-loop cruciaal voor het beperken van risico’s. Binnenkort zal wettelijk worden vereist dat zulke toezichtrollen bestaan voor risicovolle AI-toepassingen.

Human-in-the-loop by design

Het idee van "HITL by design" krijgt steeds meer voet aan de grond. Niet achteraf menselijke review toevoegen, maar AI-systemen vanaf de start bouwen met HITL als onmisbare fundering. Dit past bij het idee van verantwoorde AI – eerlijkheid, transparantie en verantwoording zitten zo in het hele productleven ingebakken.

Marktleiders werken hier nu al aan mee.

Uiteindelijk gaat het niet om mens versus machine, maar om mens mét machines. — Satya Nadella, CEO van Microsoft

Die visie bepaalt productontwikkeling in uiteenlopende branches – van bedrijfssoftware tot consumententechnologie.

Richting 2030: Mens En AI Hand-In-Hand

Naarmate AI versnelt, wordt één boodschap steeds duidelijker: de toekomst is aan organisaties die automatisering balanceren met menselijke deskundigheid.

AI kan tegen 2030 tot $15,7 biljoen toevoegen aan de wereldeconomie, aldus PWC.

Human-in-the-Loop zal niet verdwijnen naarmate AI slimmer wordt. Integendeel: het wordt een strategische noodzaak en zit straks standaard in de architectuur van ethische, uitlegbare en vertrouwde AI-systemen.

Vanaf 2030 is menselijk toezicht een basisprincipe voor ontwerp, niet meer slechts een vangnet. HITL wordt verwacht in alles: van regelgeving tot platform-functionaliteit. Bedrijven die dat nu al adopteren, zijn straks futureproof.

Zie het zo: zoals de autogordel een onmisbaar onderdeel van elke auto is, zo wordt de HITL-mechaniek standaard in elke serieuze AI-toepassing. Ze beschermen gebruikers, voorkomen fouten en zorgen dat innovatie verantwoord en inclusief blijft.

Nu is hét moment om je daarop voor te bereiden, want Amazon voorspelt dat Europa tegen 2030 zo goed als universele AI-adoptie ziet.

Business leaders en tech-strategen zetten daarom nu in op:

- Investeren in uitlegbare AI-tools en -interfaces

- Toezichtsrollen voor mensen in elk team creëren

- Platforms kiezen waarbij menselijke validatie eenvoudig in te bouwen is

- Processen ontwerpen waarin mensen en AI standaard samenwerken

Nu regelgeving strenger wordt en vertrouwen cruciaal is, vormen juist deze stappen de basis voor weerbare, agile en ethisch sterke organisaties.

Laatst bijgewerkt op