关键信息总结

- 到2030年,HITL(人机协作)将成为值得信赖且可解释AI的核心设计要素。

- 法规将要求在人类敏感AI决策中有人工监管。

- 人工与AI协同将推动道德且可扩展的自动化。

AI与人的混合未来

展望2030年,有一点愈发明朗:最优秀的AI系统并非速度最快或最自动化,而是最为可靠和值得信赖。这种信任来自于自动化速度与人类专业知识的平衡。

早期AI推广过程中,我们认识到虽然纯自动化系统十分强大,但它们通常伴随偏见、透明度不足和行为不可预测等风险。这些挑战再次激发了HITL系统与以人为本AI的兴趣,不再是被动补救,而是前瞻性的设计策略。

有预测指出,到2026年,超过90%的线上内容将由AI生成。这一激进转变强调了自动系统中信任与监管的重要性,正如Oodaloop所分析。

想进一步了解核心理念,欢迎阅读我们的**人机协作AI:定义与优势指南**,全面介绍HITL在现实中的应用及业务价值。

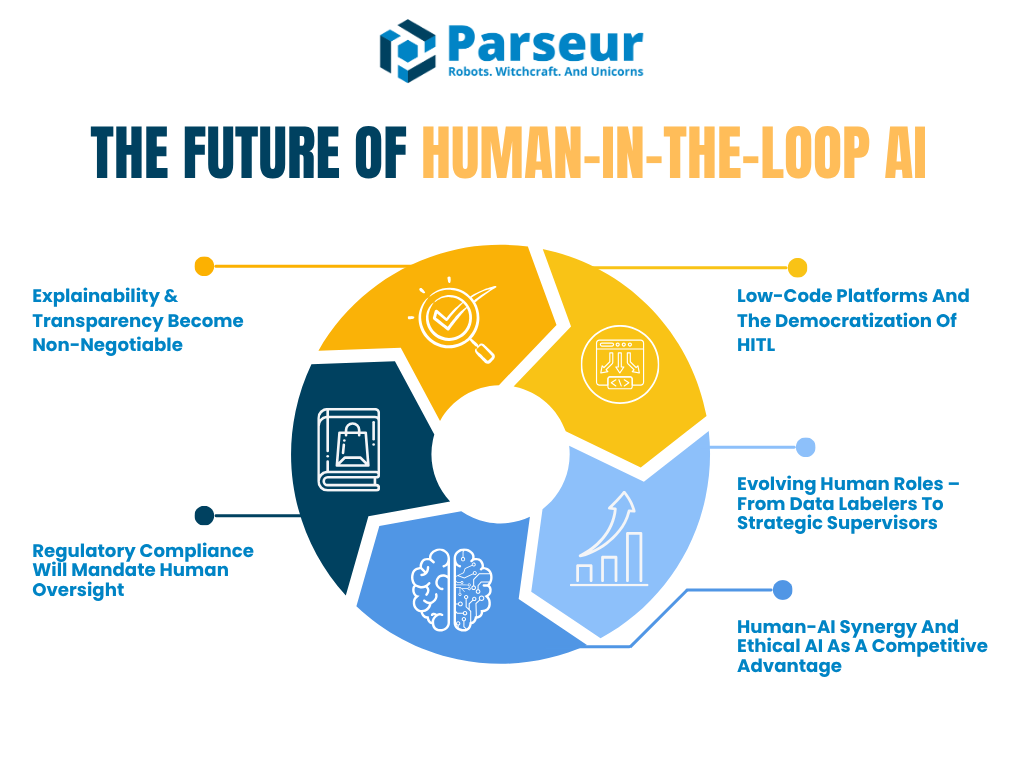

本文将介绍HITL从现在到2030年的演变,聚焦于塑造人机协作未来的五大关键趋势:

- 对可解释和可审计AI的迫切需求

- 法规合规推动人工监管体系落地

- 低代码平台让HITL普及变得容易

- 人类角色从数据标注者进阶为AI监管者

- 人机协同成为企业的全新竞争力

根据Venture Beat,如Reid Hoffman这样的技术领袖预测,我们将步入AI超级代理主导时代。他认为:“不会用AI的人,将被会用AI的人取代”,AI应提升而非威胁个人生产力。

**PwC**2026年全球AI就业晴雨表显示,自2022年生成式AI普及后,AI高曝行业生产力增长几乎是原来的四倍(2018-2022年7%,2018-2024年27%),尤其金融服务和软件出版等领域。

如今,组织不再需要在自动化与安全之间二选一。未来属于人机混合AI架构:在关键节点引入人工判断,无论是“in-the-loop”还是“on-the-loop”。

趋势一:可解释性与透明度成为核心要求

AI系统持续渗透关键决策,如今关注的不再只是能否准确完成任务,核心在于人类是否能理解和解释这些决策。这正是可解释AI(XAI)与透明度发挥最大价值之处。

未来几年,可解释性将从最佳实践晋升为必选项,特别是在金融、医疗、保险、法律等高风险领域。人机协作工作流不仅仅承担监管,更帮助企业满足监管与伦理要求,把人放在解释、验证和解读AI输出的关键位置。

Gartner预测,到2026年,超八成企业将部署生成式AI技术。这凸显了医疗、法律、金融等各行业对AI系统可解释性与人工监管的紧迫需求。

欧盟AI法案已经要求高风险AI应用须有人类监管和结果可解释。NIST AI风险管理框架则警告,HITL角色不清与决策不透明仍是重大挑战。很快,这些框架将在规范及文档层面明确人工审核如何设计和落地。

未来视角:配备解释界面的人机协作

到2030年,AI工具很可能预置**“解释界面”**。这些界面帮助人工审核人员理解模型决策。例如信贷审批,系统不仅给出分数,还会展示AI决策的三大理由,让审核员能公平和准确地判断。

HITL将从全流程人工审查进化到关键节点的战略验证。不再是机械审核每条输出,而是确保AI决策背后的逻辑契合业务价值、合规目标和公平性标准。

哪些行业率先落地?

医疗和金融行业已率先采用HITL。很多场景下可解释性不止是选择题,而是明确的法律要求。2026年Deloitte Tech Trends报告也指出:“复杂越高,越需要人类介入。”强调了自动化和人工审核的悖论——自动化越强,专业人工监督越不可或缺。

这也是**“human-on-the-loop”**模式兴起的逻辑。这类系统下,人工无需时刻干预,而是持续监督,可在关键时刻接管,类似飞行员实时监控自动驾驶系统。

为何极其重要?

追求可解释性的趋势强调了一点:企业如无法赢得信任,AI就无法大规模落地。信任基于透明。未来,企业可能要定期维护“解释日志”——由人工审核、签字背书AI决策过程。

人工角色不再只是被动补救,而是积极引领AI进化,发现漏洞、补充语境、筑牢伦理底线。

趋势二:法规合规要求更高的人类监管

AI能力不断上升,法律与伦理责任也同步升级。全球监管机关如今更侧重责任与人工监管。2026至2030年,将有大批法规明确要求诸多高风险AI场景引入人机协作流程。

无论欧盟、美国还是NIST等标准化机构,都同意一点:AI不能成为黑箱。受算法影响者应能了解、质疑,甚至请求人工复核。

据Naaia数据,仅2024年美国就提出700多项AI相关法案,2026年初又有40多个新提案,表明监管正加速聚焦AI透明和人工监管。

GDPR第22条赋予个人自动化决策中的人工干预权。即将出台的欧盟AI法案进一步明确高风险系统必须有人在场监督和最终把控。这不仅是趋势,更正在成为法律标准。

未来展望:合规驱动的人机协作系统

到2030年,企业大多将引入所谓的**“合规型HITL”**,比如:

- 定期安排人工日志审查AI决策

- 建AI监管团队,持续监测系统运行(如同航空和网络安全的监控室)

- 在高风险、重公平环节强制设置人工核查

平台和工具将支持这些措施,比如通过仪表盘追踪模型准确率及人工审核覆盖率。这类可追溯性本身也将成为重要的合规指标。

专家观点:混合AI治理快速崛起

行业领袖已拥抱混合框架,把自动化与人工监管结合。据Gartner称,67%成熟企业组建了AI专属团队,增设AI伦理师、模型经理、知识工程师等新职,保障AI部署负责任和合规。

在数据与分析等领域,这些角色正成为标配。预计“AI审计师”“AI风险经理”“人机协作监管员”之类新头衔将在2030年大范围普及,反映治理策略正在将人工监管深度嵌入。

合规对接可解释性

监管不仅要求人工参与,更要求这些人工角色能清楚解释决策理由。这呼应了趋势一。文档与审计将成为标准流程。NIST AI RMF已建议组织明确授权人工定期覆盖AI、监控输出。未来不达标的企业或被处以罚款甚至吊销资格。

部分机构甚至可能申请AI信任认证,以示从设计起就纳入全面人工监管。

趋势三:低代码平台推动HITL大规模普及

以往搭建HITL工作流极度依赖工程技术和定制开发,让中小团队和非技术职能望而却步。如今,这一门槛正被低代码和零基础平台快速打破。到2026年及以后,越来越多工具让HITL走进各类型企业。

这些平台支持用户无需编程就把人工检核节点嵌入AI流程。UiPath、Microsoft Power Automate、Amazon A2I等工具现已可拖拽式插入人工环节。

未来视角:业务用户自主构建AI流程

预计未来几年AI平台都将把HITL打包为标配功能。AmplifAI数据显示,到2026年,70%的客户体验(CX)领导者计划将生成式AI整合至各环节,这些工具通常自带HITL质控与人工监管。

这种民主化意义重大——让运营、法律、财务等更多部门能自主搭建AI治理。更多人参与AI构建和监督,企业扩展速度与安全性皆提升。

未来,甚至大模型都可以主动推荐何处引入人机协作节点(如:模型信心低/数据高风险),平台支持集中仪表盘,人工可快速查看决策概要、标记异常、反馈优化AI。

众包驱动的人工审核

还有一大趋势是众包/外包形式的灵活HITL,如Amazon Mechanical Turk或BPO团队,灵活接入流程,兼顾低成本与高质量。

比如电商用AI筛查评论,疑似问题订单自动送至众包审核队列,高效省力又保障合规。

行业趋势推动易用型HITL

理想平台应通过低代码界面拓展自动化功能,并可作代码级定制。HITL嵌入将像建站或发邮件一样容易。

这与Parseur的进化高度契合。Parseur允许你如不想完全依赖AI引擎也可灵活创建模板。HITL作为智能自动化的普遍标准,Parseur等平台将在规模化、高质量人机监管落地中发挥关键作用。

趋势四:人工角色进阶——由标注员到战略监管员

AI持续进阶,人工在AI环节的角色也正演化。早期HITL多承担标注、基础验证等重复性工作,但今后,这部分将逐步交由AI自动或众包实现。人不会被取代,而是向更具策略、专业和高价值的岗位转型。

Statistica2026年报告显示,2026年人类完成47%任务,机器为22%,另30%需人机共同参与。到2030年,分工将更偏向机器。

未来趋势:HITL 2.0——AI主管理与风险把控

我们正进入**“人机协作2.0”时代**。此模式下,人工不只是审核员,而是监管员、教练和AI风险经理。

如医疗领域,医生仅在AI出现不确定或异常时介入。这些人工输入不只是完成单点工作,更及时反哺至模型训调环路,形成真正的“增强智能”——AI和人工共同学习成长。

世界经济论坛报告称,2030年60%雇主预期数字化转型将更看重分析和领导力,体力/手工类技能则下滑。

这也带来了**“human-on-the-loop”**理念:人工实时监控AI,仅在必要时介入,类似自动系统的空管模式。

被AI增强的人类

AI工具也将反过来辅助管理环节的人工。例如,有合规官收到AI提示“此决策与历史判例冲突,请复查”。未来,人工不仅“在环中”,AI还会协助其智能管理“这个环”。

新兴岗位与责任转型

到2030年或见如下新职位:

- AI反馈专员

- 算法伦理官

- 模型行为教练

- 人机协作监管员

这些岗位不仅负责质控,更是引导AI持续进化的主力。实现角色从执行者到系统监管者的彻底转变。

据Deloitte2026全球人力发展报告,57%企业领导认为要培养员工“和机器一起思考”能力。人工从监督执行转向策略投入。

趋势五:人机协同与伦理AI成企业竞争制高点

AI的未来从不是“人对机器”,而是人与AI协作——更高效、更道德、更智能。2030年,最具竞争力企业必是善于平衡自动化与人工判断的“混合型”团队。

这正是增强智能:AI在速度、规模与模式感知上发挥所长,人工则贡献伦理、同理心和专业知识,达成更优决策。

55%组织已组建AI董事会或治理委员会监督AI项目,显示人工监管和伦理治理在AI落地中的分量与日俱增(Gartner)。

协同优势

到2026年,"人机协作"不再是可选项,而会成为AI系统值得信赖的核心。无论贷款、招聘还是健康管理,人工核验都将保障结果准确与可信。

企业将更主动把HITL作为品牌差异点。未来“人核AI”“人工监管AI”标签会在医疗、金融、教育等领域普及,类似“有机”“可持续”等概念。

“我们AI由人工把关”将成为企业赢得用户信任的法宝,尤其在AI错误可能引发公关危机的时代。

伦理AI是新的商业战略

高曝光AI事故证明盲目自动化可能致命:比如简历筛选失误、法律打分偏见或医疗误诊,均可能引发诉讼、舆论危机甚至客户流失。

高风险AI决策融合人工审核,既满足法规,也向用户传达负责与透明。伦理AI早已不止是道德标签,而是商业基础。

合规认证与可审计系统

未来,AI系统将有望获得HITL合规认证。类似ISO为工业流程背书,AI平台亦可通过“人工可审查、可解释、可撤销”获得专业认证。

这将形成明显竞争优势,拥有透明、可审计、人工监管的AI,更容易获得用户、投资者、监管方信任。

依据NIST AI风险管理框架指引,必须为AI预设监督。报告反复强调in-the-loop与on-the-loop角色之于系统性降险的价值。未来,这些监管职能或将依法强制,在重大AI场景成为法律底线。

“设计即HITL”

“设计即HITL”理念将势头更强。不是事后打补丁,而是最初架构里就把HITL当核心。即责任AI,从开发到产品全过程贯穿公平、透明和可问责。

行业巨头早已觉醒。

最终,不是机器和人的PK,而是人机并肩前进。——Satya Nadella,微软CEO

该理念已深刻影响各类企业级及消费级产品的开发。

迈向2030:人机并肩,智能共创未来

AI加快渗透,摆在眼前的现实是:只有自动化与人工管理兼修的组织才能真正制胜未来。

据PWC预测,到2030年,AI有望为全球经济创造15.7万亿美元价值。

人机协作不会因AI能力提升而消失,反而会变为构建道德、可解释、可验证AI架构的核心战略要素。

到2030年,人工监管将成为AI产品的设计原则,而非临时措施。从法律到平台能力,HITL将成为标配。率先拥抱这一变革的企业,将收获长期竞争力。

正如安全带之于汽车,HITL将在所有严肃AI项目中成为标配,守护用户,防止失误,并保证创新以责任和包容方式展开。

现在就应为这一未来做好准备,Amazon指出,到2030年欧洲可能实现AI几乎全覆盖。

企业高管与技术负责人应尽快行动:

- 投资于可解释AI工具与界面

- 在团队各层建立人工监管岗位

- 选择支持便捷人核流程的平台

- 让人机协作为默认业务流程

随着法规 tightened、信任成为信仰,这些做法将为企业打下韧性、敏捷及伦理领导力的坚实基础。

最后更新于