要点总结:

- 人机协同AI融合人类判断力与机器智能,确保高风险业务流程中的准确、公平与信任。

- 医疗、金融和客户服务等行业广泛应用HITL以减少错误、满足合规要求并提升表现。

- 随着AI普及,组织必须战略性地引入人工监管以控风险、合规并解决伦理难题。

- 引入HITL流程的企业,在关键AI应用领域显著提升了准确率、客户满意度与风险管控。

为什么2026年人机协同AI至关重要

AI正普及到各行各业,自动化范围涵盖文档处理到客户支持。然而,随着AI规模扩展,一个核心挑战浮现:在自动化带来真实决策影响时,如何确保系统始终准确、合规、可信?

这正是人机协同(HITL)AI展示战略价值的所在。HITL不仅是一种技术,更是一种战略方法,通过结合机器效率和人工判断,提升结果、降低风险,并满足透明与问责等新需求。

此外,**65%的组织如今已常态化部署生成式AI,**几乎是去年的两倍。根据Netsol Tech报道,HITL对于管理复杂度升级、合规需求及信任危机显得不可或缺。

本指南将帮您了解:

- HITL AI的真正含义及其边界

- 它如何落地于文档处理、医疗、客户支持等场景

- 为什么HITL能为高风险业务场景带来准确、合规与信任

- 如何为2026年及未来布局HITL AI

无论您在金融自动化中统筹AI应用,还是在合规层面评估AI系统,本指南都将帮助您理解HITL如何助推更智能、更安全的AI。

什么是人机协同(HITL)AI?

人机协同(HITL)AI指在AI系统的关键阶段引入人工干预的任何人工智能方案。与完全自主系统不同,HITL AI建立反馈闭环,使人类可以指导、审核和改进AI输出,实现更高准确性、可靠性和伦理监督。

根据VentureBeat,96%的AI/ML从业者认为人工标注重要,86%认为其不可或缺,说明专家监管不再是“锦上添花”,而已成刚需。

简单来说,HITL即人与AI的协作。AI负责大批量或重复性事务,有判断力和领域知识需求时则由人类介入。

正式定义:

HITL AI是一种机器学习方法,在训练、验证或决策等关键环节集成人工反馈,提升模型表现并降低错误率。

此方法在诸如文档处理、医疗诊断、金融风控、法律合规等高敏感流程中尤为重要——出错可能代价巨大。

相关术语:

- 人机监控(Human-on-the-loop):人类主要负责监视AI系统,必要时才介入

- 完全无人参与(Human-out-of-the-loop):AI系统独立运行,上线后不涉及人工参与

这种“强强联合”让HITL成为现代业务自动化不可或缺的灵活、可靠手段,助力AI深度融入企业运营。

人机协同AI如何工作?

人机协同(HITL)AI通过闭环式协作反馈——让人在AI系统全生命周期不同阶段参与——持续完善系统表现,确保输出始终准确、公平、可靠。

典型的HITL流程分为以下三步:

1. 数据标注

人工对原始数据进行标注,供AI模型训练。例如,文档处理中,人工高亮发票号、总金额、到期日等。这样形成结构化且高质量的训练数据。

2. 模型训练

模型基于标注数据进行训练。该阶段由数据科学家与机器学习工程师监控并调参。人工引导确保模型正确识别模式,避免偏见。

3. 测试与反馈

模型上线后AI继续处理新数据,但所有低置信度或歧义样本会被标记,供人工审核。人工修正或确认结果,这些调整又反哺AI模型,形成持续自我优化循环。

现实案例:文档处理

在智能文档处理(IDP)中,HITL流程是:

- AI从扫描件提取字段

- 置信度高的字段自动通过

- 置信度低(如手写体、复杂结构)交由人工审核和修正

- 人工修正数据反哺系统模型,下次性能更优

这种“人机闭环”机制保障AI覆盖更多任务的同时,人工监管始终嵌入核心质控。

据Tely.ai报道,采用HITL的流程,文档抽取准确率可提升至99.9%,实现AI速度与人工精度兼得。

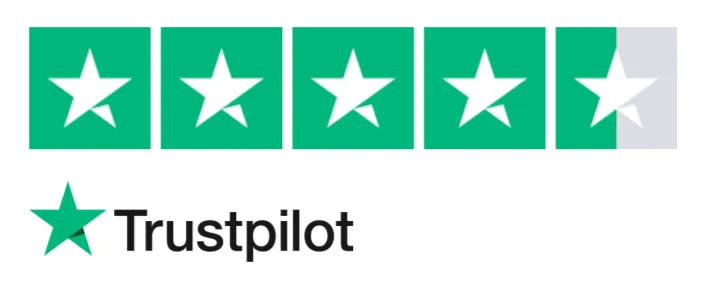

人机协同AI的核心优势

随着AI加速普及,很多企业发现单靠自动化已远远不够。(HITL)AI将AI的速度与规模和人工判断结合,确保质量、合规与信任。该方法在文档处理、客服、法律科技、医疗等风险敏感领域尤为关键。企业放弃“黑盒AI”,转投依赖人工指导、校核和批准的混合AI流程。

例如,History Tools报告显示,72%的客户在遇到复杂问题时更希望与真人交流,而引入HITL的客服企业往往可令平均处理时长下降20–40%,提升满意度和效率。

以下为部署HITL AI的核心价值:

更高准确率与结果质量

AI能快速处理海量数据,但在歧义或低置信度预测上常出错。HITL下,人工校核、修正输出,结果更精准。例如文档处理,人工最终核查发票、合同提取内容,保证金额、姓名、日期等无误,再输入后续系统。

偏见纠正与伦理保障

算法易携带或放大训练数据的偏见。HITL为人工及时识别和修正放贷、招聘、保险审核等领域里的偏见提供入口,保障系统公平、合规和道德底线。

透明度与信任

HITL让AI变得更“可解释”。引入人工验证或批准使决策流程透明、责任清晰。用户、监管、各利益相关方更易信任系统,不再担忧“黑箱”风险。

满足法规与标准

欧盟AI法案等新法规要求高风险AI必须有人工监管。HITL工作流保证输出由合资格人工复核,金融、医疗、法律等领域尤其必要,否则易触发法律和安全问题。

“混合”工作流赋能高效运营

设计优良的HITL不会拖慢运营,而是让流程更智能。AI主攻批量常规,人工精准盯低置信度或例外场景。既快又精,减少总工作量不牺牲准确率。例如发票解析,AI高置信度抽取直接进ERP,疑难则人工复核。

据Gartner预测:到2025年,30%的新法律科技自动化产品都将引入人机协同功能。 说明负责任、有人工护航的AI已成趋势。

总之,人机协同绝不是AI能力的短板,而是其可靠性、实用性与价值倍增器。融合人机智能,企业能放心大规模自动化,且稳妥远离风险。

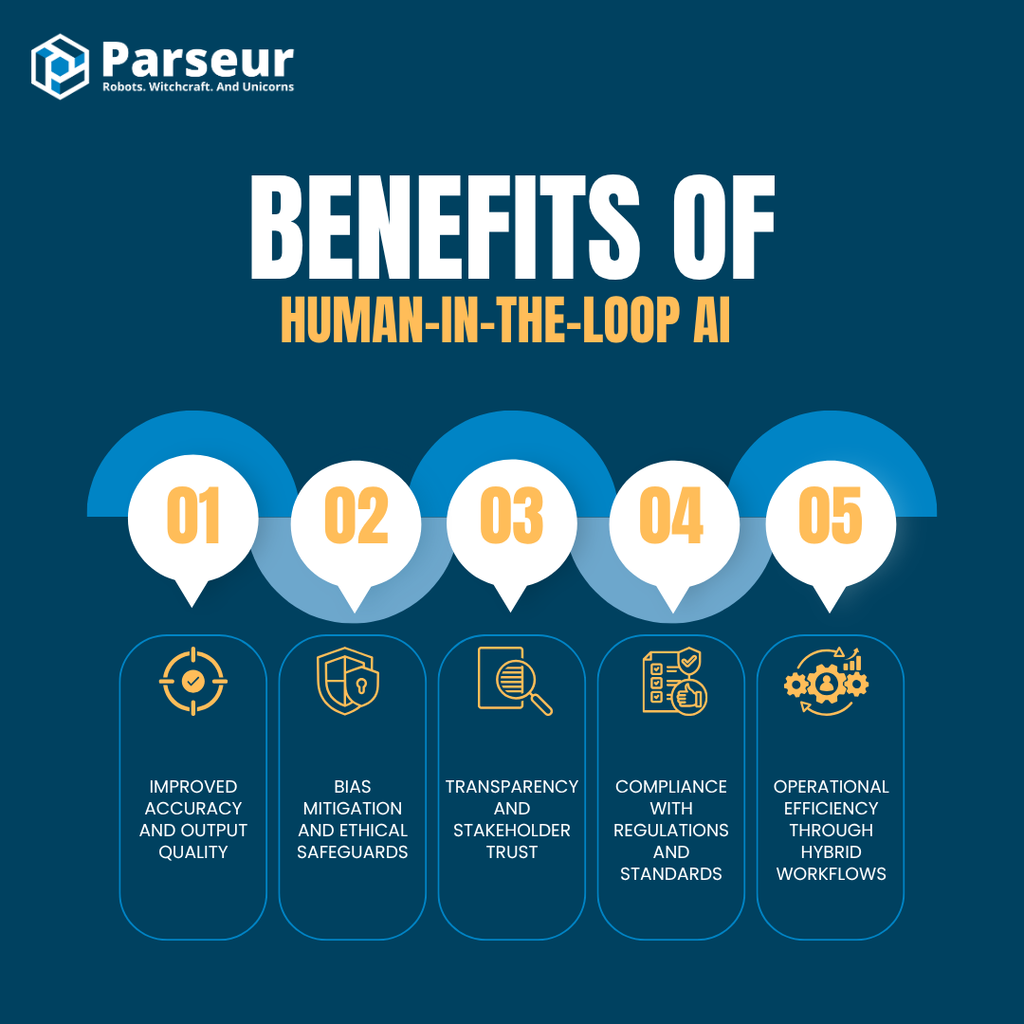

人机协同AI(HITL)的现实应用

人机协同AI早已走出概念,正在改变各行各业。以下是HITL在主流行业的典型实践场景,融合了自动化的精准与人类的上下文理解。

智能文档处理(IDP)

发票、理赔、入职表单等文档量大流程中,AI负责批量抽取,人工盯低置信度结果。此混合模式实现关键财法数据几乎100%准确,保障合规、减少出错。Parseur的文档核验能力正是在此大显身手。

结合AI和人机协同审核,文档处理企业数据抽取准确率可达99.9%,业务级可靠性几近100%(详见Tely.ai)。

客户服务与聊天机器人

AI机器人轻松应对海量咨询,但面对复杂或细腻场景仍需人介入。HITL实现无缝升级:常规问题AI处理,例外情况人工接手。

据Sekago 研究,为AI机器人引入人工应答可令客户满意率提升高达35%,客户流失减少约20%。大大提升客户支持体验,减轻坐席压力。

内容审核

AI可自动识别仇恨言论、裸露和虚假消息,但模糊案例仍需人工判定,确保最终平台表现兼顾效率与细节。

SEO Sandwich数据显示,AI可正确标注约88%的有害内容,但5–10%的边缘案例需人工复核。

医疗诊断

AI可高效解读扫描图像或实验结果,但疑难点最终仍由医生拍板。HITL可提升诊断安全、守住合规和患者利益,确保重要决策不是“只靠机器”。

Nexus Frontier的报告显示,医疗领域HITL诊断可将准确率推高至99.5%,而单AI或单人工远低于此。

自动驾驶与机器人

自动驾驶、机器人等多采用人机监控模式:人类实时监控,特殊情形人工介入。此类监管对规模化落地与真实路测尤为关键。

据Finance Buzz数据,2024年自动驾驶汽车事故近乎翻倍至544起,2023年为288起,人类监管对于安全部署至关重要。

其他适用行业

- 网络安全:AI发现可疑活动,人工调查事件

- 金融:交易系统预警时,人类介入处置异常

- 法律科技:AI预筛文档,律师把最终关

- 销售:AI初筛线索,人工聚焦有价值客户,提高转化

Cleartail Marketing CEO Magee Clegg的实际案例:

我们有家制造业客户,每月有200+网站咨询,但销售团队只能在24小时内跟进60%。我们用HITL机器人系统,AI负责初筛,遇到技术或定制需求时转人工。6个月后咨询处理率提升至85%,合格线索转化率从23%增至34%。销售团队的非精准对话数也由每月40+降至12个。真正诀窍是AI筛选、人工做关键决策,人机协作成效显著。

Invensis Technologies CEO Anupa Rongala的发票抽取案例:

我们为大型物流企业做发票数据读取,AI模型高效处理结构化数据,但遇到手写和非标准格式仍需人工修正。引入HITL后,人工审核AI标记的低置信度结果,准确率提升至98%,处理时长缩短40%。更重要的是客户信任全面提升,AI学习能力持续进步,所需人工逐步减少。最有价值的回报就是这种人机“反馈循环”。

The Rosie Apartments市场经理 Gunnar Blakeway-Walen实践分享:

HITL彻底优化了我们290万美元年度营销预算。系统自动追踪芝加哥、圣地亚哥、明尼阿波利斯和温哥华等地表现,人工决定数字营销与渠道分配。结果是节省4%预算、单元空置时间降50%,还保证了入住目标。多家庭行业为何离不开HITL?因为客户行为的细微差异只有人工才能精准判断。我们的AI做地理圈选,人工调整不同社区的信息,更有针对性。

Mediumchat Group联合创始人兼COO Amy Bos的客户交互案例:

我们每天处理成千上万的多语言、不同语气的咨询。几年前开发AI智能分单,流程提速但情感捕捉失真。我们引入HITL,由资深顾问审核AI信心不高的复杂场景。四个月后,人工审核从30%降到10%以下,客户满意度上升18%。HITL闭环让AI变强,顾问更有参与感,客户也明显感知服务提升。

Redline Minds联合创始人 Lori Appleman 的销售案例:

我们最有成效的HITL应用是在Lucky Orange和Hot Jar等工具中。AI监测了客户行为,我们发现客户因为结账太晚显示运费而困惑。我们将运费计算器前置后,两周内转化提升18%。最大误区是把HITL当替代选项,其实AI采集数据、人工负责决策才是最优解。分工明确,HITL最大化ROI。

Kell Solutions总裁 Gregg Kell专业服务落地体会:

专业服务业未来五年将最大程度受益于HITL。律师事务所用AI初筛客户与文件,最终判断和策略全靠律师。这样可多服务40%客户,客户关系更牢固。最优HITL部署半年效率翻两倍有余,ROI重点在于风险防控和收益保障——比如有客户靠人工审核避免了一起15万美元的危机。

Mexico-City-Private-Driver.com创始人Martin Weidemann物流案例:

最初尝试完全自动分配司机,直到一次重要客户被分错人才意识到风险巨大。现在所有“敏感”或VIP任务都人工最终审核,关键分配错误率由1/35降到1/500以内,高端客户信任度大增。细小的人工闭环既避免出错,也让AI持续进化。如今80%业务自动完成,但最关键20%由人工把关,关系与品牌得以长期维护。

Service Builder CEO Andrew Leger在排班与报价的HITL案例:

我们为调度引入HITL,AI先按规则排班,人类决策应对突发或客户偏好。某家HVAC公司“纯自动化”后出现30%排班冲突,采用HITL人工辅助纠偏后,特殊客户如“Johnson太太只爱上午”,AI就不会错漏了。报价也一样:AI初步生成,人工修正特殊优惠或复杂报价,准确率提升40%,满意度大升。效率也变高,AI做“重体力”,人类做“关键判断”,更快更准。

行业HITL价值综述

调研证实,HITL对金融、医疗等高风险行业研发可靠、透明AI至关重要。此类领域任何小错都可能带来巨额损失或法律、健康风险。例如医疗用HITL辅助诊断规避误判,金融用人工复审交易确保合规。

Jorie的数据表明,医疗行业86%的失误为人工管理或手工流程原因。HITL融合自动化与人工监管,显著降低这类失误,提升成绩和合规。

这进一步说明:**混合AI(自动化+人工)**不是权宜之计,而将在2026年成为最佳实践标准。

挑战与最佳实践

HITL AI虽强,但落地时也存在挑战,企业需清楚了解关键问题及应对最佳实践。

据Big Data Wire,55%的组织认为高技能人才短缺影响大规模部署生成式AI,48%认为高成本为核心障碍。

可扩展性与成本

引入人工会提升运维成本、周期变长,尤其当每一单都需要人工时尤甚。

最佳实践: 人工只聚焦边缘场景、低置信度预测或定期抽查。引入主动学习等手段最大化人工产出。

人为误判与偏差

人类也可能产生失误或主观偏见,训练不足或压力大时易无意中放过严重AI问题。

最佳实践: 明确分工角色,持续培训,关键环节用双人复核保证一致。持之以恒检测AI与人工的准确率,及时优化流程。

合理划定人工干预环节

不是所有AI决策都得人工上阵,范围不清反令流程无序低效。

最佳实践: 找准真正高风险、影响重大的决策点,这些环节最需要人工辅助。可重复、低风险任务全自动化实现整体产效最优。

集成与流程设计

人工监管嵌入自动化流程并非无缝,流程断裂会拉低成效,甚至拖慢整体效率。

最佳实践: 推荐使用可支持人工审核的平台(如Parseur),通过友好界面让人工高效校核、补充反馈,助AI系统持续迭代。

Premier Marketing Group负责人Rob Gundermann的教训总结:

最大的问题常见在两点:一是企业一口气想全自动,没留人工节点。有家暖通客户全流程自动筛线索,最后把几十万订单当小维修对待,自动回复成灾,流程全部重构。二是团队没培训到位:牙医诊所用AI排班没人会管AI预警,午休排了根管术、技师双重排班,几周才修正。还有一些企业选型失误,买的AI工具不能和CRM对接,信息还得靠人工搬,越自动越低效。

隐私与合规

人工审核需要接触敏感数据,易引发泄密、隐私和合规风险。

最佳实践: 严控权限,签署保密协议,专用环境部署,外部标注或合同工更需合规。执行GDPR、HIPAA等数据保护规范。

要充分发挥HITL价值,企业需明确评估最需人工环节,挑选专业审核人选,配备工具与培训,常测准确提升和错误率,持续优化策略。

如**NIST AI风险管理框架**,建议高风险场景一定配人机监管。将HITL策略纳入主流有助于企业负责任地扩展AI,特别是在2026及以后法规收紧的大背景下。

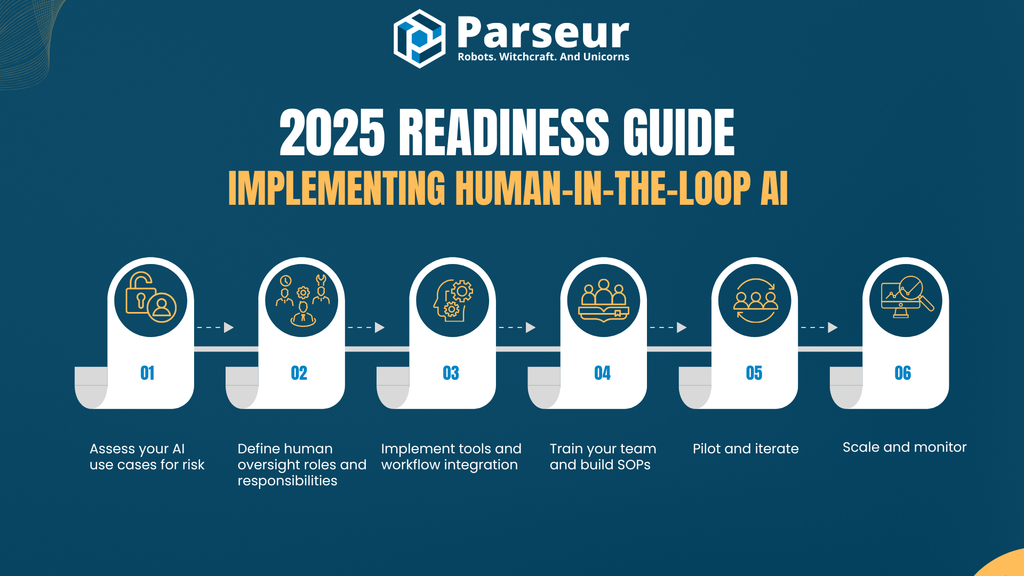

2026年HITL部署实操指南

伴随AI加速普及,企业部署人机协同(HITL)已不可或缺。2026年,合规、信任和精度更为关键——HITL具备三重保障。下面是切实可行的落地指南:

第1步:评估AI场景风险

梳理AI已应用的业务,优先识别涉法律、财务、对外等决策层级高的环节。这些位置最需人工监管,确保安全与伦理。

第2步:定义人工监管角色与权限

明确谁是流程中“人机协同点”负责人,可能是数据分析师、合规员或终端用户。其权限需清晰,比如有无推翻AI建议的权力,还是仅能核查低置信度输出。职责明晰方可防流程梗阻。

第3步:落地工具与集成流程

采用支持人工复核的工具平台,如Parseur,人工可确认或修正数据后流转。流程中建议配合通知或触发机制,确保及时介入。

第4步:团队培训与SOP制定

培训审核员如何解读AI结果、何时介入。制订统一操作规范(SOP):审核流程、修正规范与异常标记流程。

第5步:先做试点再扩展

选小型场景做试点,检测准确率、周转速度与人力投入。根据效果微调阈值、信心水平和审核判断逻辑。

第6步:规模化扩展与监控

试点成效良好后,将HITL推广至更广场景。持续监控表现、人工反馈、合规追踪,并随模型升级优化整体流程。

2026年HITL为何至关重要

AI治理趋严及新法规(如欧盟AI法案)要求高风险AI场景必须人工监管,企业应把HITL纳入核心AI战略。

这不仅仅是合规,更是建设精准、可信、可扩展AI体系的基础。

过去两年,大型语言模型推动AI工作流发生根本变革,令许多不可能成为日常。Parseur客户已可用AI自动化所有数据抽取,实现史无前例的速度与规模。但AI绝非完美:异常案例依然需要人工判断和把关。人机协同(HITL)就是将AI效率与人工高准确率结合——让AI自动完成95%,剩下关键5%交由专家审核,实现两全其美,达成端到端自动化与极致可靠。

结论

人机协同AI是完全自动化与纯人工流程之间的强大桥梁。将人工判断嵌入AI生命周期关键环节,企业能够大幅提升准确率、合规性,并赢得信任。2026年及以后,高风险行业的组织已无法绕开HITL,它已成为负责任、可靠AI落地的基石。

无论您管理复杂文档、训练AI模型,还是优化客户满意度,HITL都将助力更智能、更安全、更具伦理的自动化。借助如Parseur内置人工审核等工具,您既能保障规模扩展,又能守住合规底线。

准备好让人机协同赋能企业运营了吗?了解Parseur如何将智能文档处理与内置人工监管无缝集成,助您轻松兼得速度与可靠性。

常见问题解答

最后,这里为您解答一些关于人机协同AI的常见问题。这些见解将帮助您更清晰了解HITL是如何融入实际AI工作流程,特别是在自动化、合规和文档处理等领域。

-

人机协同和人机监控有何区别?

-

人机协同(HITL)指的是在AI流程关键环节(如训练、验证或决策阶段)主动加入人工参与。而人机监控则是一种监督模式——人类仅在系统出现问题或不确定时介入。两者都强调人工监管,但HITL更“动手”,适合高风险或高不确定性的场景,对准确率要求极高。

-

人机协同AI是否意味着AI不是全自动的?

-

是的,人机协同AI不是完全自主。它是一种融合AI速度与效率以及人类推理和场景感知的混合模式。目的并不是放慢自动化进程,而是确保质量、安全和信任,尤其是在出错可能导致合规风险、经济损失或客户体验下降的场景。HITL依然能够实现大规模自动化,同时最大限度降低风险。

-

什么时候应采用人机协同而非全自动AI?

-

当决策伴随着重大影响或需要场景判断时,应优先采用人机协同,例如处理法律文件、财务数据或复杂客户咨询。“全自动”AI适用于可预测、低风险、重复性强的任务,偶尔出错可容忍。理想策略是“搭配用”:AI处理常规事务,人类只介入复杂或关键的边缘场景。

-

人机协同AI在文档处理中的应用场景?

-

在文档处理领域,AI工具被用于从结构化或半结构化文件(如发票、合同、入职表单)中提取数据。但当遇到不清晰的版式、低置信度字段或异常格式时,人工审核员会介入验证或修正输出。这不仅提升了数据提取的准确率,也在为AI模型持续“授课”,形成反馈闭环,最终实现业务核心场景下近乎完美的结果。

最后更新于