要点总结:

- 文档解析API 用于从您拥有的文件(如PDF、图片及邮件)中提取结构化数据。

- 网页抓取API 通过解析HTML或渲染内容,从公开网页收集信息。

- 选择哪种方案取决于数据来源:您收到的文件与您主动监测的网站数据。

- 许多团队采用混合工作流,先利用网页抓取采集文档,再通过解析API实现可靠JSON提取。

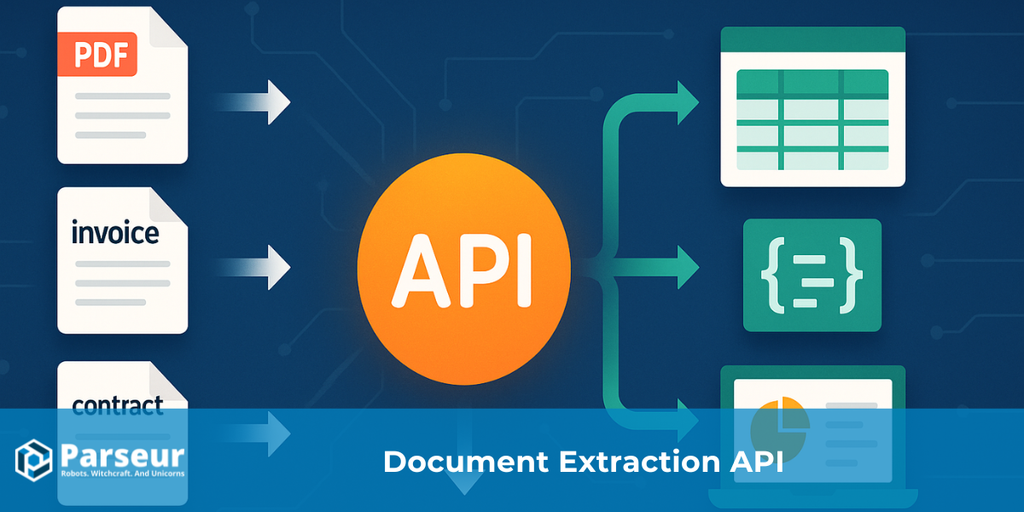

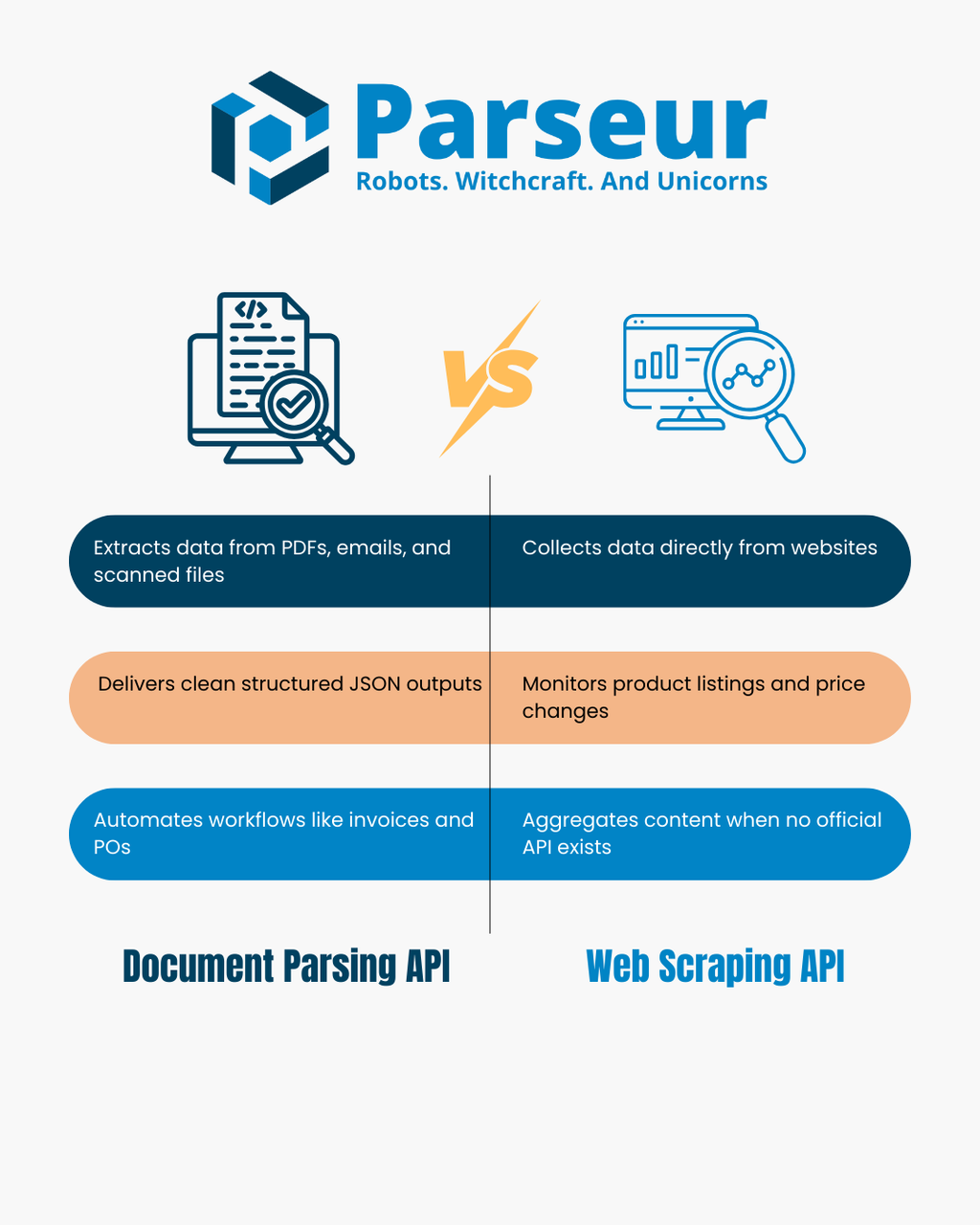

文档解析API与网页抓取API

文档解析API 可将PDF、扫描图片和邮件等文件转化为结构化JSON。它分析文档布局和文本内容,自动提取键值对与表格信息,让发票管理、采购单追踪、邮件入库等流程自动化变得更容易。

网页抓取API 则通过程序化抓取网页,解析HTML或渲染后的DOM,直接从网站采集数据。当没有官方API时,抓取通常用于监控产品列表、追踪价格变化、聚合新闻内容或构建数据集。

二者都实现数据提取,但源头区别显著:文档解析API处理您自有的文件,网页抓取API针对访问的网页内容。本文将对比其优势与局限,给出决策树、对比表,并呈现真实使用场景。想进一步了解数据自动化,可参阅我们的 数据提取API指南。

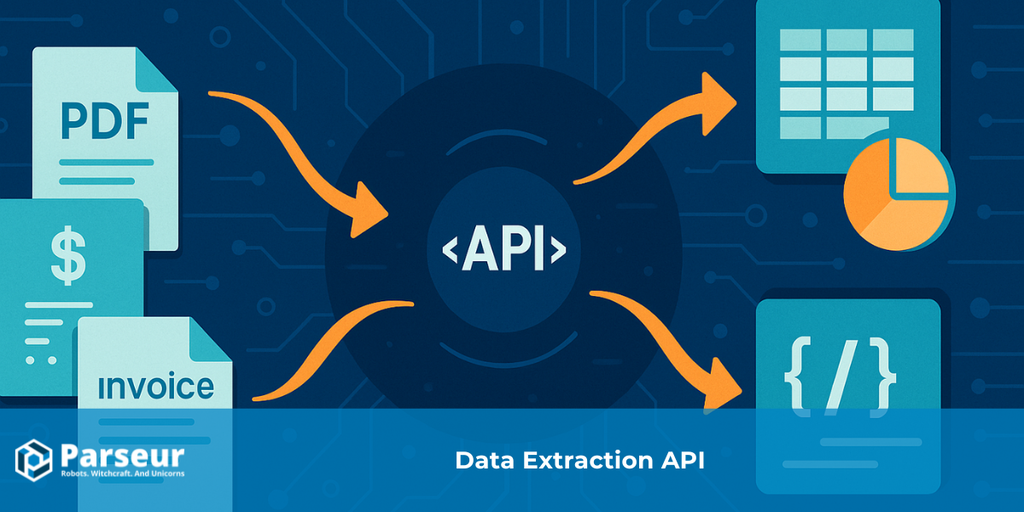

文档解析API与网页抓取API的运行机制

文档解析API和网页抓取API都属于数据提取范畴,但运行逻辑和解决方案迥异。了解二者实际工作方式,是判断何种方案适合企业需求的第一步。

据 Scrapingdog 研究,34.8%的开发者现已采用网页抓取API,趋势明显从自定义脚本向结构化、现成的数据自动提取流程倾斜。

文档解析API

文档解析API专注于从您已拥有或合法获得的文件中提取结构化数据,例如PDF、扫描件、含附件的邮件及部分Office文档。无需手动录入,API会解析文档布局和文本,发现关键信息点。

- 输入: PDF、扫描件、图片、邮件、Office文档。

- 输出: 干净、结构化的JSON,包括键值对、表格及您自定义的字段。

- 原理: 利用OCR与解析规则,自动检测文本区块、数字、表格,并映射为统一格式,方便下游系统(CRM、ERP、数据库)处理。

- 典型场景: 自动处理发票与收据、解析采购单、财务报表、批量客户表单。许多团队还用解析API将邮件转换为结构化数据,连接Zapier、Make、n8n等工具自动触发业务流。

网页抓取API

网页抓取API则专注于从开放网络直接提取数据。它无需处理文件,而是从网站采集数据并转为可用格式。抓取流程可能包含获取原始HTML、借助无头浏览器渲染页面及用选择器或JS解析目标字段。

- 输入: 网站URL、HTML内容或JSON接口地址。

- 输出: 解析后的结构化JSON或CSV,适合分析与集成。

- 原理: API加载网页、分析DOM树,通过CSS选择器或XPath等规则采集产品名称、价格、新闻标题等字段。有些工具还会处理代理与反爬策略,实现大规模抓取。

- 典型场景: 监控竞品电商价格、汇总产品目录、聚合新闻文章、追踪招聘/活动/目录等信息(当没有官方API时)。

设计之初,文档解析API适合处理您拥有或收到的文件,网页抓取API则专精于收集公开网页内容。

决策树:您该选哪一种API?

选择文档解析API还是网页抓取API,核心在于数据源头以及实现目标。下面的决策流程与说明,有助于您快速判断:

!

您的数据是PDF、图片或邮件附件,并且您合法拥有?

→ 用文档解析API。文件会转化为干净的JSON,自动提取字段,支持表格行项目,无需人工输入。

您的数据是公开网页或在线数据集?

→ 用网页抓取API。它会采集HTML或渲染页面,让您抓取所需数据,如产品列表、新闻文章等。

需要同时处理文件和网页?

→ 推荐采用混合方案。例如可用抓取API下载供应商门户PDF,再递交解析API提取结构化内容。

需要表格或行项目数据(如发票、收据、采购单)?

→ 文档解析API此时表现最佳。它专为结构化表格和财务数据设计,准确度和一致性很高。

需要实时监控动态数据(如价格变动、突发新闻)?

→ 这种情况首选网页抓取API,能持续采集网站内容并同步最新更新。

该决策树可帮助您快速匹配需求与工具,部分场景也适合组合二者实现。

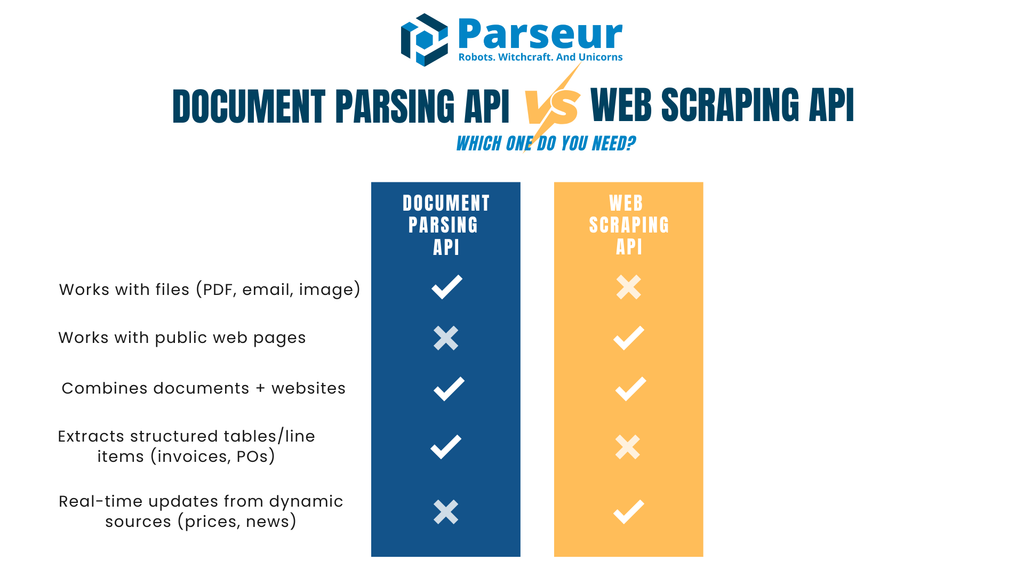

文档解析API与网页抓取API对比

将文档解析API与网页抓取API优劣一览对比有助于更明晰抉择。下表从输入输出、安全合规等标准,帮您直观判断哪种方案更适合同步您的自动化工作流。

| 评估标准 | 文档解析API | 网页抓取API |

|---|---|---|

| 主要输入 | PDF、扫描图片、含附件邮件等文件 | 网页(HTML/JSON)或渲染后的DOM |

| 典型输出 | 包含键值对、行项目表格、结构化字段的JSON | 借助选择器提取并转为JSON/CSV的结构化数据 |

| 结构变更影响 | 稳定:文档类型一经设定,解析长期一致 | 网页结构或DOM微调即可能导致抓取规则失效 |

| 应用场景 | 发票、采购单、合同、表单、财务报表、业务邮件 | 商品目录、价格监控、招聘信息、新闻聚合等 |

| 来源渠道 | 由您或用户主动提供文档 | 直接从第三方网站获取数据 |

| 合规要点 | 注重数据隐私合规(控制者/处理者职责、数据保留策略) | 关注服务条款、robots.txt、反爬技术限制 |

| 处理延迟与扩展性 | 适合批处理、异步及Webhook推送 | 受爬取速率、反爬规则、并发管理等影响 |

| 维护成本 | 偶尔调整模板或数据结构即可 | 需要频繁调整选择器、处理反爬对策 |

| 数据质量 | 结构化输出、可校验、字段规范 | 随网站质量与HTML结构波动而异 |

| 安全性 | 传输及存储加密、Webhook签名、角色权限管控 | 需管控IP与代理,注意网络安全 |

| AI/ML适配 | 结构化JSON适合直接输入AI/ML系统 | 适用于文本丰富化、摘要、分类等 |

| 适用条件 | 处理您已获得的文档/文件(如发票、收据、合同) | 需要实时网站内容(如价格、存货、新闻头条等) |

何时选网页抓取API(以及如何合规运用)

当所需信息仅出现在网站而非文件形式时,网页抓取API是最佳选择。不用等待供应商或客户传送,可直接批量采集数据,适合市场调研、价格监控、知识聚合等场景,且需求经常更新。

据 Browsercat 产业数据显示,全球网页抓取市场2024年约为10.1亿美元,有望在2032年增至24.9亿美元,复合年增长率达11.9%。

典型抓取场景包括:

- 跨多个电商网站监控价格或库存

- 聚合不同渠道新闻头条或公告

- 无官方API时,批量收集职位、名录、活动等数据

由于网页抓取涉及采集非自有信息,务必合规操作。最佳实践包括:

- 抓取前仔细阅读robots.txt与服务条款

- 设置合理频率,避免给目标服务器造成负担

- 有条件时采用数据缓存,减少重复采集

- 明确标识爬虫身份,杜绝伪装

- 若网站提供API,优先使用官方接口

网页抓取的现实挑战还在于结构极易变动。HTML微小调整就可能让选择器失效,导致数据丢失或错误。建议务必搭建监控与告警及时修正。

此外,许多自动化流程并非抓取单一环节。例如,先通过抓取采集PDF,再交由文档解析API生成结构化JSON,实现二者优势互补。

网页抓取API的挑战与局限

网页抓取API可实现实时采集,但存在诸多值得关注的障碍与成本。清楚了解这些挑战有助于合理配置自动化流程,明晰使用场景边界。

Octoparse 最新分析指出,只有约50%网站易于抓取,30%有中等难度,剩下20%由于结构或反爬防护格外艰难。

网站频繁变化

大部分网页并非为抓取而设计。哪怕微小的HTML结构更改,如CSS类名变动、页面布局调整,都可能让抓取规则与API失效,甚或增加维护成本,需持续监控以保证数据管道稳定。

反爬技术与限制

不少网站采用Captcha、IP限流、会话校验或Bot检测。为避免抓取受阻,工程团队往往用代理轮换、管理UA字段及请求频率等方法,但这也带来更多技术负担。

法律与道德风险

网页抓取的法律环境较为模糊。抓取公开数据通常被允许,但若无视服务条款、robots.txt、绕过付费墙等行为,则有合规与法律风险。企业需制定道德规范,并在不确定时事先请教法律顾问。

数据质量与一致性难题

网站原本针对人浏览设计,非机器消费。抓取数据常需附加清洗或校验。HTML结构杂乱、JS动态加载、重复记录等都可能造成杂乱的数据集,需在下游处理前进一步“保洁”。

扩展性障碍

大规模抓取远不是简单加大请求数就能实现。高并发需要稳健的基础设施来管理重试、报错和任务分发,其代理、服务器、监控等成本变高。

长期可持续性隐忧

对于持续业务流程,仅靠抓取往往脆弱。数据管道需要不断调整,而标准化文档输入或官方API机制会更可靠。企业若开展长期项目,需考虑维护资源投入。

何时选择文档解析API更合适

当您所需信息主要以文件(PDF、扫描件、带附件邮件)形式获取,文档解析API显然是更高效的选择。它可自动把未结构化文档变为结构化数据,省去一遍遍手动录入数据库或ERP的时间精力。

据 Sphereco 统计,企业数据约80%为非结构化(如邮件、PDF、扫描文档),文档解析API价值尤其突出,可大幅解锁效率与洞察力。

典型应用包括:

- 发票与收据处理:提取供应商名称、日期、金额、表格行项目等,提升应付自动化

- 采购单与对账单:快速导出订单号、金额、付款条件等,便于财务核对

- 表单与合同解析:拉取如客户详情、签约日期等标准化字段

- 运营邮件自动化:如订单确认、发货通知、预约申请等,解析为JSON自动对接下游系统

文档解析API的最大亮点就是数据准确且一致。它不仅仅能够抽取文本,还能标准化格式、校验字段,通过Webhook直接送入您的应用或数据库,免除清洗环节。

与网页抓取不同,文件结构变动远远低于HTML页面。一旦配置好解析方案,同一规则可批量处理海量文档,长期运维压力小。

如您的业务强依赖供应商文件、客户报表或邮件,文档解析API很可能是更持久、更高效的自动化路径。

混合模式:真实场景中的协同

在诸多业务流程中,文档解析与网页抓取并非对立面,而是互为补充。实际数据来源常兼有文件与网页,二者结合能构建更完善自动化解决方案。

常见混合模式包括:

- 先抓取再解析PDF:如供应商门户可下载发票/报表PDF,抓取API先登录获取,解析API随后抽取行项目、总金额等字段。

- 解析后用抓取API丰富上下文:解析发票后,需补充供应商分类或行业基准,可用抓取API采集行业外部公开数据,解析API保障财务明细准确。

- 邮件解析结合网站校验:订单确认、发货通知等常以邮件形式收到,可直接解析,再联动抓取API实时核查库存或价格。

- 智能分析与信息融合:获得文档结构化JSON后,再结合网站数据,叠加分析、归类或产品映射,实现多源数据的动态应用。

混合方案既能发挥解析API在结构化输出的优势,又能通过抓取API扩展数据广度,帮助团队减少人工,推动端到端自动化。

Parseur到底是文档解析API还是网页抓取API?

Parseur 是一款强大的文档和邮件解析API,可将非结构化文件直接转为结构化JSON。不像网页抓取API那样直接采集网站内容,Parseur聚焦于您或用户自有的文档与邮件,让自动化更加稳定可靠,无需担忧网页结构变更、抓取限制或渲染兼容性问题。借助Parseur,可轻松自动化各类发票、收据、采购单或表单处理流程。

实际用途与特性

- Parseur能做什么? 可自动接收邮件、PDF、图片、Office文档,输出易集成的结构化JSON,包含键值字段与行项目表格,通过Webhook或API直接访问。

- 数据处理机制: Parseur作为您授权下的处理者身份,支持数据处理协议(DPA),透明公开子处理方,允许自定义数据保留与删除策略,数据全程加密,并支持Webhook签名交付。

- 最适用团队: 文件主要通过邮件传递(如发票、收据、采购单、财务报表),希望低代码实现结构化数据自动提取的团队。

Parseur API的核心优势

Parseur API 的独特价值在于其兼具API和Web应用。开发者可直接集成API,客服和运营团队则能通过Web应用监控、复核并完善解析,无需额外开发复杂管理工具。

此组合省去开发者自建监控和管理界面的时间与负担。Web端点击即可定义JSON schema与字段、随时调整说明书并校验抽取效果;既保障技术和业务团队协作高效,也让集成极致轻量。

与高度依赖网页结构却易碎的抓取API不同,Parseur处理的是您已有的文件,成为关键业务自动化的更稳健基石。

Parseur如何保障数据处理安全

虽然Parseur不是网页抓取API,但正为文档与邮件的高效安全处理而设计。依靠Parseur,团队可放心将PDF、扫描图片、邮件附件变为结构化JSON,大规模对接自动化流程。

Parseur对数据安全、隐私和合规的高度承诺让其脱颖而出。企业用户无需担忧数据管理风险,可始终信赖其服务标准。

Parseur数据管理重点

为文档和邮件而生

Parseur接收PDF、图片、邮件内容后,通过Webhook或API输出干净结构化JSON,省去手工开发,实现发票管理、采购单自动化或邮件驱动集成。

数据始终归您控制

您完全拥有提交给Parseur的数据,仅基于您的指令进行处理,可自主配置数据保留策略,最短可保留一天。处理后立即删除功能支持解析后随时彻底移除文件。

数据存储位置

Parseur数据均加密安全地存储在欧盟(荷兰),位于Google Cloud Platform(GCP)数据中心,GCP本身持有ISO 27001认证。查看更多信息。

安全加密体系

全部数据静态加密(AES-256)、传输全程加密(TLS v1.2及以上)。已禁用过时传输协议。Parseur采用Let’s Encrypt SSL证书,全球业界标准,确保Parseur服务器、第三方应用及您的浏览器之间通信安全。

基础架构监控与渗透测试

Parseur持续监控其基础设施与相关依赖,发现漏洞即时修补。同时,定期委托独立第三方公司执行渗透测试,遵循OWASP Top 10与SANS 25等安全框架。企业客户可申请完整报告。2025年,Parseur荣获了 Astra渗透测试证书,进一步证明其网络安全韧性。

密码与账号保护

Parseur绝不存储明文密码。采用PBKDF2+SHA-256加密算法,配合512位salt、60万加密轮次,标准远高于NIST建议,确保账号安全。

业务可靠性与SLA保障

Parseur目标运行时间为99.9%及以上,具备自动重试和回退机制,确保服务波动时数据不丢失。邮件采集可自动重试至24小时,关键流程双路机制冗余。企业客户可升级至99.99%高可用并享额外基础设施保障。查看在线率历史

GDPR及隐私优先

Parseur完全符合GDPR规范,只作为您的受控数据处理者。您为数据控制者,拥有文档主权。Parseur绝不出售或共享您的数据,仅在您明确请求支持时由内部成员访问,成员全员接受GDPR与数据保护培训。详细了解Parseur与GDPR。

突发事件响应与数据泄露通告

极少数情况下,如发生数据泄露,Parseur承诺48小时内通知所有客户,确保合规和信息透明。您也可查阅Parseur的安全与隐私总览。

法律与合规重点一览

文档解析与网页抓取API的合法合规性需高度关注。两者都涉及数据处理,但合规要点因数据源和应用场景而异。

企业务必确保拥有文档数据的合法基础。通常需与数据所有者签约,明确控制者/处理者角色,根据相关法规(如GDPR)设立数据处理协议,优化保留/删除策略,并兼顾数据泄露告警、最小化原则等。

网页抓取的法律环境更复杂。即使抓取公开数据在部分司法辖区可行,许多网站会通过服务条款或robots.txt明确禁抓,绕过限制甚至强行访问将极大提升法律和合规风险。建议实施网页抓取前,务必咨询法律顾问,确保操作合法合约合规。

如涉及跨境数据传输,特别是欧盟及其它严格监管区用户/数据,也需规划合规机制。

结语:为您的数据选择最佳API方案

文档解析与网页抓取API各自对自动化采集发挥着不可或缺的作用,但服务对象和业务场景有本质区别。对于拥有自身文件(如发票、报表、邮件)的业务,更适合用解析API实现高效、准确的数据提取。

Experlogix 研究显示,文档自动化可将处理时间缩短至20%,凸显解析API带来的效率提升。

如果目标数据只存在于公开网站(如产品目录、价格列表),则宜选网页抓取API。不少流程也会结合:先抓取采集文件,再用解析API输出结构化数据。

核心结论:请用数据源头选API。如果数据来自PDF、扫描或邮件,解析API节省时间且更准;若纯属网页数据,则可选抓取API。对于多源任务,双API同用才能覆盖全部自动化需求。

常见问题解答

许多读者在比较文档解析和网页抓取时有共同疑问。以下是一些最常见问题的解答,帮助您澄清二者的区别与实际应用场景。

-

文档解析和网页抓取是一样的吗?

-

并不是。文档解析针对您已经拥有或收到的文件(如PDF、扫描图片或电子邮件),而网页抓取则通过分析HTML或渲染内容,从网站提取数据。

-

Parseur是网页抓取API工具吗?

-

不是。Parseur 是一个文档和邮件解析 API,并非网页抓取工具。它不会爬取或获取网页内容,而是帮助您将已拥有的文档(如邮件、PDF、图片或Office文件),直接转换为结构化的JSON格式。这让其非常适合发票、收据、采购单等流程的自动化处理,无需自建复杂的内部工具。

-

网页抓取合法吗?

-

这取决于具体情况。抓取公开数据有时是允许的,但网站通常会在服务条款或robots.txt中设限。务必审核相关规定,并在操作前咨询法律顾问。

-

应该在什么情况下避免抓取?

-

如果数据位于付费墙之后、受到严格访问控制,或被网站服务条款明确禁止,应避免抓取。试图绕过这些限制可能带来合规与法律风险。

最后更新于