Wichtigste Erkenntnisse:

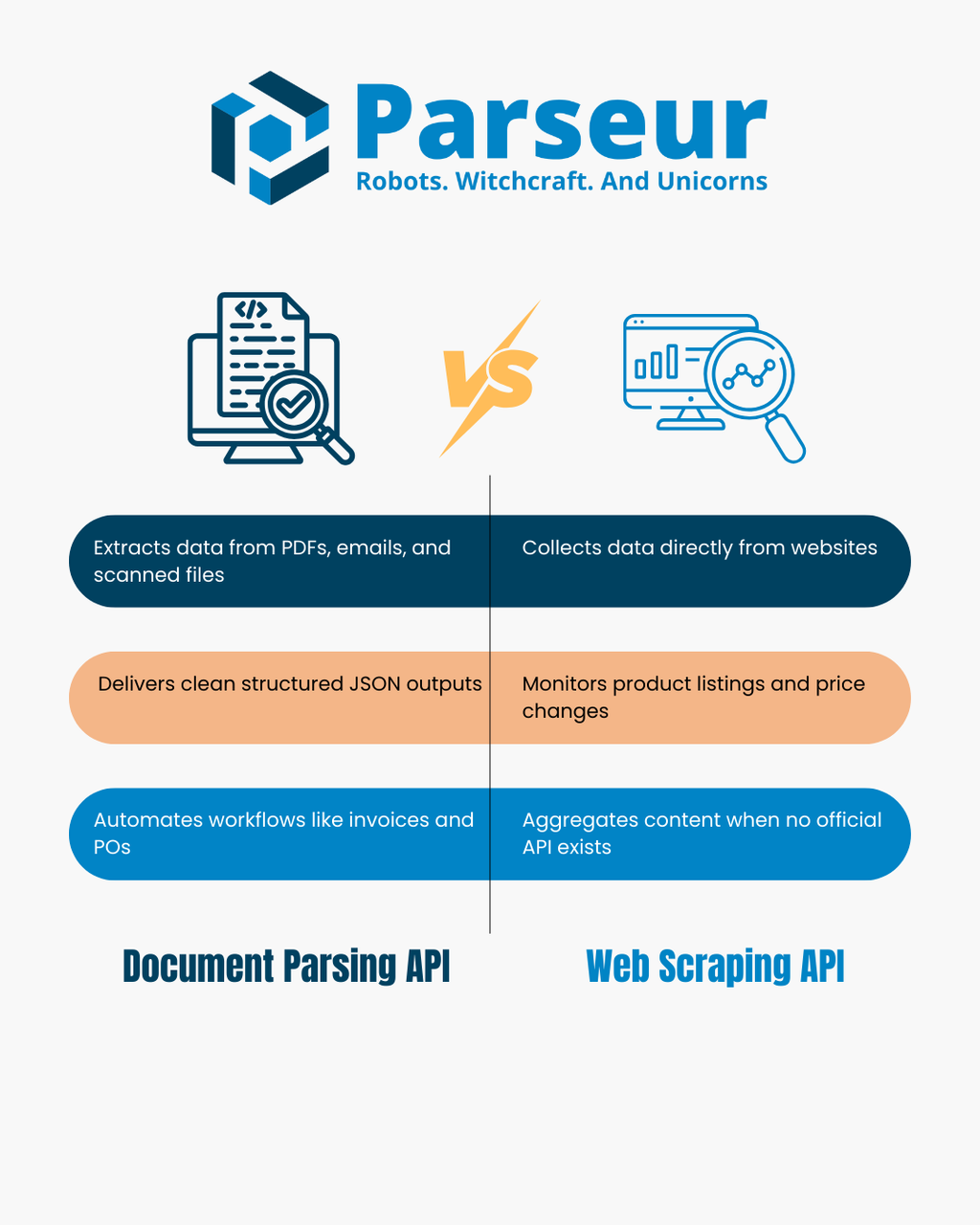

- Dokumenten-Parsing-APIs extrahieren strukturierte Daten aus Dateien, die Sie besitzen, wie PDFs, Bilder und E-Mails.

- Web-Scraping-APIs sammeln Informationen von öffentlichen Webseiten, indem sie HTML oder gerenderte Inhalte analysieren.

- Die richtige Wahl hängt von Ihrer Datenquelle ab: Dateien, die Sie erhalten, vs. Webseiten, die Sie überwachen möchten.

- Viele Teams nutzen hybride Workflows, scrapen, um Dokumente zu erhalten, und parsen im Anschluss zuverlässiges JSON daraus.

Dokumenten-Parsing-API vs Web-Scraping-API

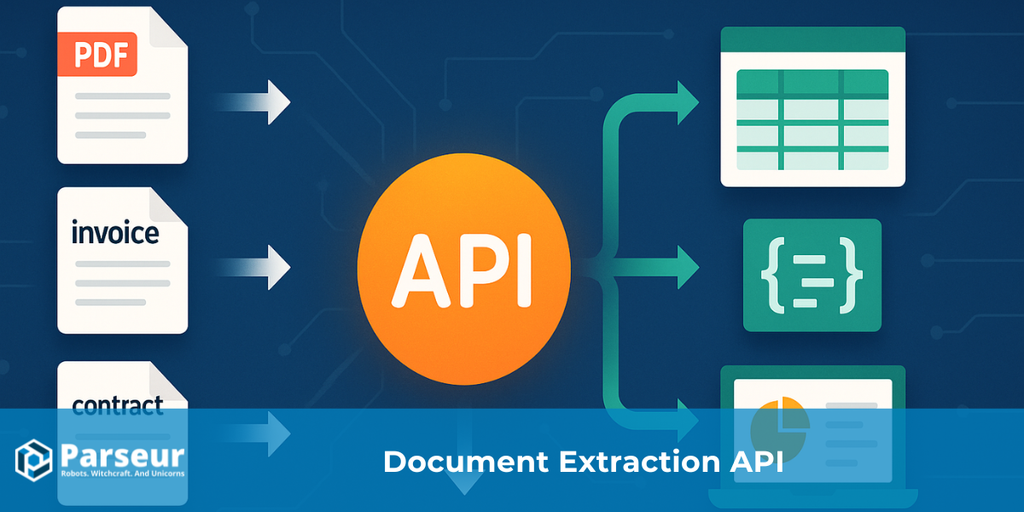

Eine Dokumenten-Parsing-API wandelt Dateien wie PDFs, gescannte Bilder und E-Mails in strukturiertes JSON um. Sie analysiert das Layout und den Text des Dokuments, um Schlüssel-Wert-Paare und Tabellen zu extrahieren, was die Automatisierung von Prozessen wie Rechnungsverwaltung, Bestellverfolgung oder E-Mail-zu-Datenbank-Workflows vereinfacht.

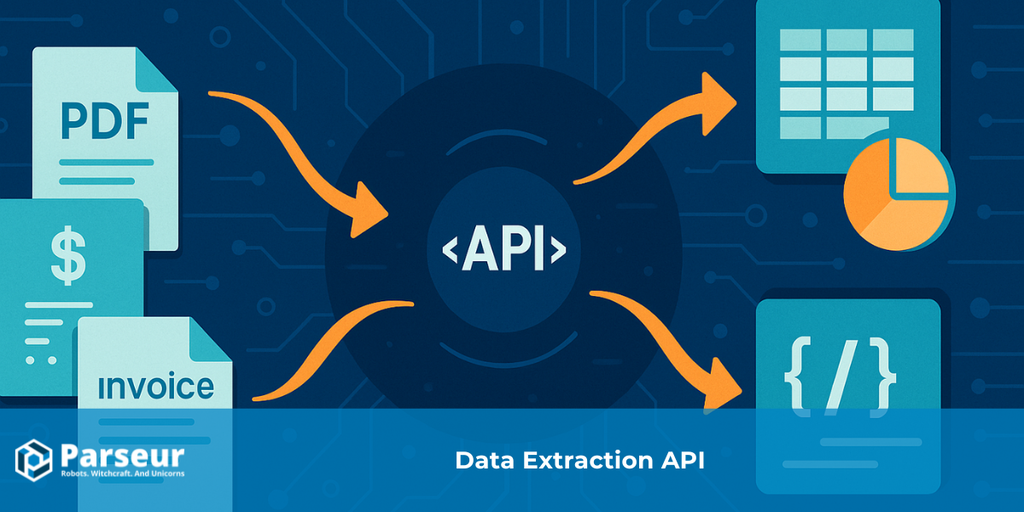

Eine Web-Scraping-API sammelt Daten direkt von Websites, indem Webseiten programmgesteuert abgerufen und das HTML oder der gerenderte DOM analysiert werden. Wenn keine offizielle API angeboten wird, kommt Web Scraping typischerweise zum Einsatz, um Produktlisten zu überwachen, Preisänderungen nachzuverfolgen, Nachrichteninhalte zu aggregieren oder Datensätze zu erstellen.

Beide Ansätze extrahieren Daten, arbeiten aber mit völlig unterschiedlichen Quellen: Dokumenten-Parsing-APIs verarbeiten Dateien, die Sie besitzen, während Web-Scraping-APIs Webseiten im Fokus haben, die Sie besuchen. In diesem Artikel vergleichen wir Stärken und Schwächen, bieten einen Entscheidungsbaum, eine tabellarische Übersicht und zeigen reale Anwendungsfälle. Für einen umfassenden Kontext zum Thema Datenautomatisierung siehe unseren Data Extraction API Guide.

Wie funktionieren Dokumenten-Parsing-APIs und Web-Scraping-APIs?

Dokumenten-Parsing-APIs und Web-Scraping-APIs fallen beide unter den Bereich Datenextraktion, doch ihre Vorgehensweise und die Probleme, die sie lösen, unterscheiden sich grundlegend. Zu verstehen, wie jede Lösung praktisch funktioniert, ist der erste Schritt, um die richtige Wahl für Ihren Anwendungsfall zu treffen.

Eine Studie von Scrapingdog zeigt, dass 34,8 % der Entwickler heute Web-Scraping-APIs nutzen – ein deutlicher Trend hin zu strukturierten, sofort nutzbaren Datenextraktions-Workflows statt individueller Scraping-Skripte.

Dokumenten-Parsing-API

Eine Dokumenten-Parsing-API konzentriert sich darauf, strukturierte Informationen aus Dateien, die Sie bereits besitzen oder rechtmäßig erhalten, zu extrahieren. Dazu gehören PDFs, gescannte Bilder, E-Mails mit Anhängen und teilweise auch Office-Dokumente. Anstatt Daten manuell einzutragen, analysiert die API das Layout und den Text des Dokuments, um sinnvolle Datenpunkte zu identifizieren.

- Eingaben: PDFs, Scans, Bilder, E-Mails, Office-Dateien

- Ausgaben: Sauberes, strukturiertes JSON mit Schlüssel-Wert-Paaren, Tabellen und Felddefinitionen nach Ihren Vorgaben

- Wie es funktioniert: Mithilfe von OCR und Parsing-Regeln erkennt die API Textblöcke, Zahlen und Tabellen. Anschließend werden sie in ein konsistentes Format gebracht, das nachfolgende Systeme (wie CRM, ERP oder Datenbanken) einfach verarbeiten können.

- Typische Anwendungsfälle: Automatisierte Rechnungs- und Quittungsbearbeitung, Extraktion von Positionen aus Bestellungen, Parsen von Finanzberichten oder das Management großer Mengen von Kundenformularen. Viele Teams nutzen das Dokumenten-Parsing zudem, um E-Mails in strukturierte Daten zu überführen, was Workflows in Tools wie Zapier, Make oder n8n auslösen kann.

Web-Scraping-API

Eine Web-Scraping-API hingegen ist darauf ausgelegt, Informationen direkt aus dem offenen Web zu extrahieren. Anstatt sich mit Dateien auseinanderzusetzen, ruft sie Daten von Websites ab und verwandelt die Inhalte in ein weiterverwendbares Format. Der Scraping-Prozess kann das Abrufen von rohem HTML, das Rendern von Seiten über einen Headless-Browser und das Anwenden von Selektoren oder JavaScript-Auswertung umfassen, um die gewünschten Felder zu extrahieren.

- Eingaben: URLs von Webseiten, HTML-Inhalte oder JSON-Endpunkte

- Ausgaben: Geparste, strukturierte Daten, meist in JSON- oder CSV-Format, bereit für Analyse oder Integration

- Wie es funktioniert: Die API lädt eine Webseite, analysiert deren DOM (Document Object Model) und wendet Regeln wie CSS-Selektoren oder XPath an, um Felder wie Produktnamen, Preise oder Schlagzeilen abzugreifen. Manche Tools übernehmen auch Proxy-Management und Anti-Bot-Maßnahmen für den Zugriff im großen Maßstab.

- Typische Anwendungsfälle: Wettbewerberpreise auf E-Commerce-Seiten überwachen, Produktkataloge sammeln, Nachrichtenartikel aggregieren, Stellenanzeigen tracken oder Datensätze aufbauen, wenn keine offizielle API vorhanden ist.

Im Design eignen sich Dokumenten-Parsing-APIs für Dateien, die Sie besitzen oder erhalten, während Web-Scraping-APIs optimal sind, um Informationen von öffentlichen Webseiten zu sammeln.

Entscheidungsbaum: Welche Lösung ist für Sie die richtige?

Die Entscheidung zwischen einer Dokumenten-Parsing-API und einer Web-Scraping-API hängt meist von der Quelle Ihrer Daten und Ihrem Ziel ab. Nachfolgend ein einfacher Entscheidungsbaum mit praktischen Erläuterungen für jede Möglichkeit.

!

Stammt Ihre Quelle aus einer Datei (PDF, Bild oder E-Mail-Anhang), die Sie rechtmäßig besitzen?

→ Nutzen Sie eine Dokumenten-Parsing-API. Damit werden diese Dateien in sauberes JSON verwandelt, Schlüsselfelder extrahiert und sogar Posten aus Tabellen erfasst – ohne manuelle Dateneingabe.

Stammt Ihre Quelle von einer öffentlichen Webseite oder einem Online-Datensatz?

→ Nutzen Sie eine Web-Scraping-API. Damit holen Sie HTML oder gerenderte Seiten ab und extrahieren die gewünschten Datenpunkte – z.B. Produktlisten oder Nachrichtenartikel.

Arbeiten Sie mit Dokumenten und Websites zugleich?

→ Manchmal benötigen Sie einen hybriden Ansatz. Sie könnten etwa ein Lieferantenportal scrapen, um PDFs herunterzuladen, und geben diese dann an eine Dokumenten-Parsing-API weiter, um strukturierte Daten zu extrahieren.

Brauchen Sie strukturierte Tabellen oder Posten (wie bei Rechnungen, Quittungen oder Bestellungen)?

→ Hier trumpft eine Dokumenten-Parsing-API auf. Sie ist auf tabellarische und finanzielle Daten ausgelegt, die höchste Präzision und ein konsistentes Schema erfordern.

Benötigen Sie Echtzeit-Updates aus dynamischen Quellen (z. B. Preisänderungen oder Breaking News)?

→ Dann ist eine Web-Scraping-API die bessere Wahl, da sie Webseiten regelmäßig überprüft und aktuelle Inhalte direkt beim Erscheinen erfassen kann.

Dieser Entscheidungsbaum hilft Ihnen, Ihren Anwendungsfall schnell dem passenden Tool zuzuordnen – oder in manchen Szenarien beide sinnvoll zu kombinieren.

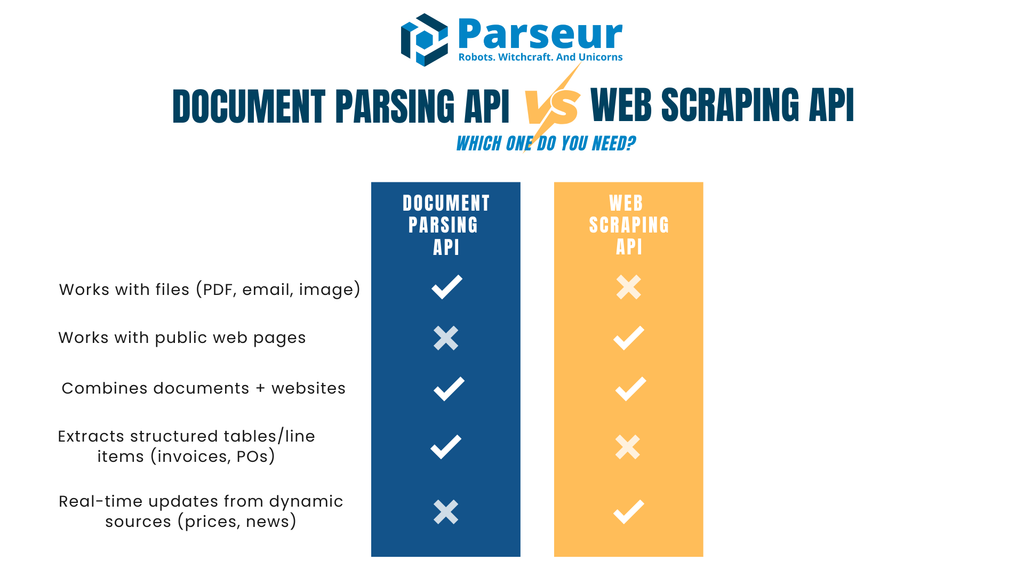

Dokumenten-Parsing-API vs Web-Scraping-API

Der direkte Vergleich von Dokumenten-Parsing-API und Web-Scraping-API gelingt am besten mit einer tabellarischen Übersicht. Die folgende Tabelle zeigt wichtige Bewertungskriterien von Eingabe und Ausgabe über Sicherheit und Compliance, damit Sie schnell sehen, welche Lösung in Ihren Workflow passt.

| Kriterium | Dokumenten-Parsing-API | Web-Scraping-API |

|---|---|---|

| Primäre Eingabe | Dateien wie PDFs, gescannte Bilder, E-Mails mit Anhängen | Webseiten (HTML/JSON) oder gerenderte DOM-Inhalte |

| Typische Ausgabe | JSON mit Schlüssel-Wert-Paaren, Positions-Tabellen und strukturierten Feldern | Geparstes HTML, umgewandelt in JSON oder CSV mittels Selektoren |

| Änderungsanfälligkeit | Stabil: Wenn Dateitypen gesetzt sind, bleibt das Parsing konsistent | Fragil: Änderungen am Layout oder DOM einer Seite können Selektoren brechen lassen |

| Anwendungsfälle | Rechnungen, Bestellungen, Verträge, Formulare, Finanzberichte, operative E-Mails | Produktkataloge, Preis-Updates, Jobbörsen und News-Aggregation |

| Daten-Beschaffung | Sie oder Ihre Nutzer liefern die Dokumente | Daten werden direkt von Drittanbieter-Webseiten abgerufen |

| Rechtlicher Fokus | Datenschutz und Compliance (Controller/Processor-Rollen, Aufbewahrungspflichten) | AGB, robots.txt, Anti-Bot-Maßnahmen |

| Latenz & Skalierung | Optimal für Batch-Jobs, asynchrone Verarbeitung, Webhook-Lieferung | Begrenzung durch Crawl-Raten, Anti-Bot-Regeln, gleichzeitige Anfragen |

| Wartungsaufwand | Gelegentliche Anpassung von Vorlagen oder Schemas | Häufige Aktualisierung von Selektoren und Anti-Bot-Strategien |

| Datenqualität | Strukturierte Ausgabe, Validierungsregeln, normalisierte Felder | Variiert je nach Seitenqualität und Sauberkeit des HTML |

| Sicherheit | Verschlüsselung bei Übertragung und Speicherung, signierte Webhooks, rollenbasierter Zugang | Erfordert IP-Rotation, sichere Proxies, Netzwerk-Hygiene |

| LLM-Kompatibilität | Ideal für strukturiertes JSON als Input für nachgelagerte KI/ML-Systeme | Ideal für Anreicherung, Zusammenfassung oder Klassifikation unstrukturierter Texte |

| Wann einsetzen | Wenn Sie bereits Dokumente erhalten (z. B. Rechnungen, Quittungen, Verträge) | Wenn Sie Live-Webinhalte benötigen (z. B. Preise, Lagerstand, Schlagzeilen) |

Wann ist Web-Scraping-API das richtige Werkzeug (und wie Sie es verantwortlich einsetzen)

Web-Scraping-APIs sind oft die beste Wahl, wenn die benötigten Informationen ausschließlich auf Webseiten vorliegen und nicht als Datei angeliefert werden. Damit können Sie Daten im großen Maßstab erfassen, ohne darauf zu warten, dass ein Partner, Lieferant oder Kunde Ihnen ein Dokument zusendet. Scraping eignet sich besonders gut für Marktanalysen, Preisbeobachtung und Wissenssammlung, bei denen es auf aktuelle Daten ankommt.

Branchenzahlen von Browsercat zeigen, dass der globale Web-Scraping-Markt 2024 etwa 1,01 Milliarden USD wert war und bis 2032 auf 2,49 Milliarden USD wachsen soll – das entspricht einer jährlichen Wachstumsrate (CAGR) von 11,9 %.

Typische Anwendungsfälle, in denen Scraping punktet:

- Preise oder Warenverfügbarkeit über mehrere E-Commerce-Sites hinweg beobachten

- Nachrichtenüberschriften oder öffentliche Mitteilungen aus verschiedenen Quellen aggregieren

- Datensätze mit Stellenanzeigen, Firmenverzeichnissen oder Veranstaltungshinweisen aufbauen, wenn keine API existiert

Da Web Scraping das Sammeln von Informationen aus Websites bedeutet, die nicht Ihnen gehören, ist ein verantwortungsvoller Umgang wichtig. Gute Praxis umfasst:

- robots.txt und AGB vor dem Scraping prüfen

- Ratenbegrenzungen einhalten, um Server nicht zu überlasten

- Caching nutzen, um unnötige Wiederholungen zu vermeiden

- Den Scraper offen kennzeichnen, nicht zu Tarnungszwecken manipulieren

- Offizielle APIs bevorzugen, sofern verfügbar

Eine praktische Herausforderung beim Web Scraping ist die hohe Änderungsrate von Webseiten. Schon eine kleine HTML-Änderung kann Selektoren brechen und zu fehlenden oder fehlerhaften Daten führen. Überwachung mit Benachrichtigungen ist daher unverzichtbar, um Fehler frühzeitig zu erkennen und zu beheben.

Auch hier gilt: In vielen Workflows ist Scraping keine alleinige Lösung. Beispielsweise entdecken oder laden Sie per Scraping PDF-Dateien von einem Lieferantenportal herunter und extrahieren anschließend mit einer Dokumenten-Parsing-API daraus strukturiertes JSON. Dieser hybride Ansatz verbindet die Reichweite des Web Scraping mit der Genauigkeit des Dokumenten-Parsings.

Herausforderungen von Web-Scraping-APIs

Web-Scraping-APIs sind ein mächtiges Werkzeug, um Echtzeitdaten von Webseiten zu sammeln, bringen aber auch erhebliche Hürden für Unternehmen mit sich. Das Bewusstsein für diese Herausforderungen hilft, realistische Erwartungen zu setzen und zu verdeutlichen, warum Scraping nur für bestimmte Szenarien sinnvoll ist.

Eine aktuelle Analyse von Octoparse zeigt: Nur rund 50 % der Websites lassen sich einfach scrapen, 30 % sind mäßig schwierig und die übrigen 20 % sind besonders herausfordernd wegen komplexer Strukturen oder starker Anti-Scraping-Maßnahmen.

Häufige Veränderungen der Webseiten

Websites sind nicht fürs Scraping konzipiert. Selbst kleine Änderungen im HTML – etwa eine umbenannte CSS-Klasse oder ein Layoutwechsel – können Scraping-Skripte und APIs lahmlegen. Das führt zu regelmäßigen Wartungskosten und erfordert Monitoring, damit Datenflüsse stabil bleiben.

Anti-Bot-Maßnahmen

Viele Webseiten setzen CAPTCHA, IP-Drosselung, Session-Validierung oder Bot-Erkennungsalgorithmen ein. Scraping-Teams müssen Proxy-Rotation, User-Agent-Management und begrenzte Anfrage-Raten implementieren – das erhöht den technischen Aufwand.

Rechtliche und ethische Aspekte

Web Scraping bewegt sich oft in einer Grauzone. Zwar ist das Parsen öffentlicher Daten meist erlaubt, das Ignorieren von Nutzungsbedingungen, robots.txt oder das Umgehen von Bezahlschranken kann jedoch rechtliche Risiken mit sich bringen. Unternehmen sollten klare ethische Richtlinien aufstellen und sich im Zweifel rechtlich beraten lassen.

Datenqualität und Konsistenz

Websites sind für Menschen, nicht für Maschinen entworfen. Ge-scrapte Daten benötigen meist zusätzliche Reinigung und Validierung. Uneinheitliche HTML-Strukturen, dynamischer JavaScript-Content oder doppelte Einträge führen zu unordentlichen Datensätzen, die vor der Nutzung weiterverarbeitet werden müssen.

Skalierbarkeitsprobleme

Eine Web-Scraping-Operation zu skalieren, ist nicht einfach mit mehr Anfragen getan. Großangelegte Projekte erfordern starke Infrastruktur für gleichzeitige Anfragen, Retry-Logik, Fehlerbehandlung und verteilte Aufgaben. Je größer das Scraping wird, desto schneller steigen die Kosten für Proxies, Server und Monitoring.

Langfristige Nachhaltigkeit

Scraping ist für dauerhafte Geschäftsprozesse eine fragile Lösung. Anders als strukturierte Dokumenteingaben oder offizielle APIs müssen Scraping-Pipelines ständig angepasst werden. Unternehmen müssen entsprechend dauerhaft Zeit und Ressourcen für die Wartung einplanen.

Wann ist eine Dokumenten-Parsing-API die bessere Wahl?

Eine Dokumenten-Parsing-API ist die beste Wahl, wenn die benötigten Informationen ohnehin als Dokument zu Ihnen gelangen – nicht als Webseiten-Inhalt. Diese Unterlagen kommen als PDFs, Scanbilder oder E-Mail-Anhänge. Statt die Details manuell in eine Datenbank oder ein ERP einzutragen, automatisiert eine Parsing-API diesen Prozess und verwandelt unstrukturierte Dateien in strukturierte Daten.

Laut Sphereco sind 80 % aller Unternehmensdaten unstrukturiert – darunter E-Mails, PDFs und Scans –, was Dokumenten-Parsing-APIs unverzichtbar für Effizienz und Einsichten macht.

Typische Anwendungsfälle:

- Rechnungs- und Quittungsverarbeitung: Lieferantenname, Datum, Gesamtsumme und Positionstabellen für die Buchhaltung extrahieren

- Bestellungen und Kontoauszüge: Auftragsnummern, Beträge, Zahlungsbedingungen für schnellere Abstimmung erfassen

- Formulare und Verträge: Standardisierte Felder wie Kundendaten oder Unterschriftsdaten auslesen

- Betriebs-E-Mails: Bestellbestätigungen, Versandbenachrichtigungen oder Buchungsanfragen direkt als JSON in Workflows integrieren

Eine Dokumenten-Parsing-API ist besonders wertvoll, wenn Genauigkeit und Konsistenz gefragt sind. Sie extrahiert nicht nur Text, sondern kann Formate normalisieren, Felder validieren und Ergebnisse per Webhook direkt in Ihre Anwendung oder Datenbank liefern – für strukturierte, zuverlässige und automatisierungsfähige Daten.

Dokumenten-Parsing ist stabiler als Web Scraping, da sich Dateistrukturen seltener ändern als HTML von Webseiten. Einmal konfigurierte Parsing-Regeln können tausende Dokumente zuverlässig abwickeln.

Setzt Ihr Unternehmen stark auf den Austausch von Lieferantendokumenten, Kundenauszügen oder E-Mails, ist eine Dokumenten-Parsing-API meist die schnellere und nachhaltigere Lösung.

Hybride Muster: Überschneidungen in der Praxis

In vielen Workflows stehen Dokumenten-Parsing und Web Scraping nicht im Wettbewerb, sondern ergänzen sich. Oft stammen verschiedene Datenquellen aus Dokumenten und Webseiten – die Kombination beider Methoden ergibt die vollständigste Lösung.

Einige praktische hybride Muster sind:

- Scrapen, um PDFs herunterzuladen, dann parsen: Ein Lieferantenportal stellt Rechnungen oder Abrechnungen als downloadbare PDFs bereit. Ein Scraping-API kann sich einloggen und die Dateien abrufen, während ein Dokumenten-Parsing-API Posten, Summen und strukturierte Daten herausliest.

- Dokumente parsen und mit gescrapten Daten anreichern: Nach dem Parsen von Rechnungen brauchen Sie vielleicht noch Metadaten wie Lieferanten-Branchenkategorien oder Branchen-Benchmarks. Scraping-APIs liefern diesen Kontext aus öffentlichen Quellen, und das Parsing-API stellt sicher, dass die Finanzdaten exakt und konsistent sind.

- E-Mail-Parsing mit Web-Überprüfung: Bestellbestätigungen und Versandavise kommen oft per E-Mail. Sie parsen die Details direkt und nutzen dann eine Scraping-API, um Lagerbestand oder aktuelle Preise auf der Lieferantenwebsite zu verifizieren.

- Intelligenzschichten kombinieren: Strukturierte JSON-Daten werden aus Dokumenten gewonnen, mit Webseiteninformationen angereichert und dann durch Analysen oder Klassifizierungen ergänzt. So können Teams Lieferanten vereinheitlichen, Auffälligkeiten erkennen oder Produkte übergreifend abgleichen.

Hybride Setups spielen die jeweiligen Vorteile beider Methoden aus: Parsing-APIs liefern verlässliche, schemagesteuerte Outputs aus Dokumenten, während Scraping-APIs Einblicke in webbasierte Daten geben, die andernorts nicht verfügbar sind. Wer beides einsetzt, reduziert manuellen Aufwand und erreicht umfassendere Automatisierung im Unternehmen.

Ist Parseur eine Dokumenten-Parsing-API oder eine Web-Scraping-API?

Parseur ist eine leistungsstarke Dokumenten- und E-Mail-Parsing-API, die unstrukturierte Dokumente in strukturiertes JSON wandelt. Im Gegensatz zu klassischen Web-Scraping-APIs, die Informationen direkt von Webseiten extrahieren, konzentriert sich Parseur auf die Dokumente und E-Mails, die Ihnen oder Ihren Nutzern bereits vorliegen. Das macht Parseur zu einer stabilen und skalierbaren Lösung zur Workflow-Automatisierung – ohne das Risiko unvorhersehbarer Webseiten-Änderungen, Scraping-Beschränkungen oder Darstellungsproblemen. Mit Parseur können Sie Prozesse wie Rechnungsautomatisierung, Belegverfolgung, Bestellabwicklung oder Formularbearbeitung problemlos aufwerten.

Was das in der Praxis bedeutet

- Was Parseur macht: Es nimmt E-Mails, PDFs, Bilder und Office-Dateien auf und liefert strukturiertes JSON mit Schlüssel-Wert-Feldern sowie Positionstabellen zurück. Daten können per Webhook zugestellt oder direkt über die API abgerufen werden.

- Umgang mit Daten: Parseur agiert ausschließlich als Prozessor unter Ihrer Kontrolle. Es unterstützt Auftragsverarbeitungsverträge (DPA), bietet eine transparente Liste von Subprozessoren, ermöglicht konfigurierbare Aufbewahrungs- und Löschrichtlinien, verschlüsselt Daten bei Übertragung und Speicherung und stellt signierte Webhooks für sichere Zustellung bereit.

- Am besten geeignet für: Parseur ist ideal für Teams, deren Dokumente vor allem per E-Mail eintreffen – etwa Rechnungen, Quittungen, Bestellungen oder Kontoauszüge –, und die eine schnelle, zuverlässige Strukturdatenextraktion mit minimalem Programmieraufwand benötigen.

Warum Parseur API herausragt

Der entscheidende Vorteil der Parseur API gegenüber anderen Lösungen: Sie kombiniert eine API mit einer Webanwendung. Entwickler können die API direkt in ihre Anwendungen integrieren, während Support- und Operationsteams die Web-App nutzen, um Parsing-Ergebnisse zu überwachen, zu prüfen und zu optimieren – ganz ohne zusätzliche Entwicklung.

Dieses Dual-Konzept spart Entwicklern eigene Monitoring- oder Verwaltungs-Tools, die meist aufwendig und wartungsintensiv sind. In der Weboberfläche definieren Nutzer das JSON-Schema und die Datenfelder mit wenigen Klicks, passen Anweisungen flexibel an und prüfen Extraktionsergebnisse. Diese Flexibilität garantiert, dass technische und nicht-technische Teams effizient zusammenarbeiten und die Integration schlank bleibt.

Im Gegensatz zu Web-Scraping-APIs, die von fragilen Webseitenstrukturen abhängen, arbeitet Parseur mit vorhandenen Dateien – eine zuverlässige Basis für geschäftskritische Automatisierung.

Wie Parseur mit Daten umgeht

Parseur ist zwar keine Web-Scraping-API, ist aber speziell dafür konzipiert, Dokumente und E-Mails effizient und sicher zu verarbeiten. Für Teams, die auf PDFs, gescannte Bilder oder E-Mail-Anhänge angewiesen sind, bietet Parseur eine zuverlässige Möglichkeit, diese Dateien in strukturiertes JSON zu transformieren und Workflows in großem Maßstab zu automatisieren.

Parseur sticht durch umfassende Datensicherheit, Datenschutz und Compliance hervor. Unternehmen können sicher sein, dass ihre Informationen verantwortungsvoll und nach strengsten Industriestandards verarbeitet werden.

Wichtige Aspekte des Parseur-Datenmanagements

Speziell für Dokumente und E-Mails gemacht

Parseur nimmt PDFs, Bilder und E-Mail-Inhalte entgegen und liefert sauberes, strukturiertes JSON per Webhook oder über die API. Damit werden Rechnungsverwaltung, Bestellabwicklung oder E-Mail-zu-Datenbank-Workflows ohne aufwändige Programmierung automatisiert.

Sie behalten die volle Kontrolle über Ihre Daten

Sie sind Eigentümer der an Parseur gesendeten Daten. Parseur verarbeitet Informationen ausschließlich auf Ihre expliziten Anweisungen, und Sie können eine eigene Aufbewahrungsrichtlinie bis auf einen Tag einstellen. Die Process then Delete-Funktion erlaubt das sofortige Entfernen von Dokumenten nach abgeschlossener Extraktion.

Wo Daten gespeichert werden

Alle Parseur-Daten werden sicher in der Europäischen Union (Niederlande) in einem besonders sicheren Rechenzentrum auf Basis der Google Cloud Platform (GCP) gespeichert. Die GCP ist ISO 27001-zertifiziert. Weitere Infos finden Sie hier.

Sicherheits- und Verschlüsselungspraktiken

Alle Daten werden mit AES-256 im Ruhezustand und mit TLS v1.2 oder höher bei der Übertragung verschlüsselt. Veraltete Transportlayer (SSLv2, SSLv3, TLS 1.0, TLS 1.1) sind deaktiviert. Parseur nutzt Let’s Encrypt SSL-Zertifikate als globalen Industriestandard, um die Kommunikation zwischen Parseur-Servern, Drittanbieter-Apps und Ihrem Browser abzusichern.

Infrastruktur-Monitoring und Penetrationstests

Parseur überwacht dauerhaft die Infrastruktur und deren Abhängigkeiten, spielt Patches bei Schwachstellen ein und lässt unabhängige Dritte regelmäßig Penetrationstests anhand von Standards wie OWASP Top 10 und SANS 25 durchführen. Unternehmenskunden können vollständige Pentest-Berichte anfordern. 2025 erhielt Parseur außerdem das offizielle Astra Pentest Certificate, als Nachweis für ihre Cybersicherheits-Resilienz.

Passwortsicherheit und Kontenschutz

Parseur speichert niemals unverschlüsselte Passwörter. Stattdessen kommt ein PBKDF2-Algorithmus mit SHA-256-Hashing und ein 512-Bit-Salt mit 600.000 Iterationen zum Einsatz – weit über NIST-Empfehlungen –, um Kontenzugänge zu schützen.

Betriebszuverlässigkeit und SLA

Parseur strebt eine Verfügbarkeit von 99,9 % oder höher an, mit Retry- und Backoff-Mechanismen, die bei Störungen Datenausfall verhindern. E-Mail-Plattformen wiederholen Zustellungen bis zu 24 Stunden lang, doppelte Sendewege bieten Redundanz. Für Enterprise-Pläne sind 99,99 % Verfügbarkeit mit weiteren Infrastrukturzusicherungen möglich. Prüfen Sie die historische Verfügbarkeit hier.

DSGVO und Privacy-First-Ansatz

Parseur ist vollständig DSGVO-konform und fungiert als Verarbeiter unter Ihrer Kontrolle. Sie bleiben verantwortlicher Datencontroller mit vollem Eigentum an Ihren Dokumenten. Parseur verkauft oder teilt Ihre Daten niemals. Mitarbeitende erhalten Zugriff auf Ihre Daten nur bei ausdrücklicher Support-Anfrage, und das gesamte Team erhält laufend Schulungen in Datenschutz und DSGVO. Mehr zu Parseur und DSGVO.

Vorfallreaktion und Meldung bei Datenschutzverstößen

Im unwahrscheinlichen Fall einer Datenpanne benachrichtigt Parseur seine Kunden innerhalb von 48 Stunden, für vollständige Transparenz und gesetzliche Compliance. Die offizielle Security & Privacy Übersicht von Parseur finden Sie hier.

Recht und Compliance im Überblick

Rechtliche und Compliance-Aspekte sind zentral bei der Wahl zwischen Dokumenten-Parsing und Web Scraping. Beide Methoden involvieren Datenverarbeitung, die Pflichten unterscheiden sich aber je nach Quelle und Kontext.

Organisationen brauchen eine rechtmäßige Grundlage für die Verarbeitung von Dokumenten – meist durch Vereinbarungen mit dem Dateninhaber oder -bereitsteller. Dazu kommt die Festlegung der Rollen im Sinne des Datenschutzes (Controller/Auftragsverarbeiter), ein Auftragsverarbeitungsvertrag und klar definierte Aufbewahrungsrichtlinien. Workflows fürs Dokumenten-Parsing sollten außerdem Meldepflichten bei Vorfällen und Grundsätze zur Datensparsamkeit berücksichtigen.

Beim Web Scraping ist die Rechtslage komplexer. Während das Scrapen öffentlicher Daten in einigen Ländern zulässig ist, verbieten es viele Websites ausdrücklich durch Nutzungsbedingungen oder ihre robots.txt. Das Umgehen von Bezahlschranken, Zugriffsbeschränkungen oder Anti-Bot-Maßnahmen erhöht Compliance- und Rechtsrisiken. Unternehmen, die Web Scraping einsetzen, sollten stets juristischen Rat einholen und sicherstellen, dass alle Vorgaben und Verträge beachtet werden.

Grenzüberschreitende Datenübermittlungen schaffen eine weitere Komplexität: Sobald personenbezogene Daten aus der EU oder anderen regulierten Regionen betroffen sind, brauchen Sie einen rechtssicheren Übertragungsmechanismus.

Fazit: Die passende API für Ihre Daten

Dokumenten-Parsing- und Web-Scraping-APIs sind wertvolle Bausteine für die Automatisierung von Datenerhebung – aber sie lösen unterschiedliche Aufgaben. Parsing eignet sich ideal, wenn Sie mit Dokumenten arbeiten, die Sie besitzen, wie Rechnungen, Auszüge oder E-Mails.

Laut Experlogix kann Dokumentenautomatisierung die Bearbeitungszeit um bis zu 80 % senken, was das enorme Effizienzpotenzial von Dokumenten-Parsing-APIs verdeutlicht.

Scraping ist die passende Wahl, wenn sich Ihre Daten auf öffentlichen Webseiten befinden – etwa Produktkataloge oder Preisinformationen. In manchen Workflows nutzen Teams Scraping, um Dateien zu sammeln, und Parsing, um daraus strukturierte Ausgaben zu erzeugen.

Die wichtigste Erkenntnis: Entscheiden Sie nach Ihrer Quelle. Erhalten Sie Ihre Daten als PDFs, Scans oder E-Mails, spart eine Dokumenten-Parsing-API Zeit und sorgt für Genauigkeit. Leben Ihre Daten auf Webpages, ist eine Scraping-API die richtige Wahl. Teams mit mehreren Quellen fahren am besten mit einer Kombination aus beiden Strategien.

Häufig gestellte Fragen

Viele Leser haben ähnliche Fragen, wenn sie Dokumenten-Parsing und Web Scraping vergleichen. Nachfolgend finden Sie Antworten auf einige der am häufigsten gestellten Fragen, um die Unterschiede und praktischen Anwendungsfälle zu verdeutlichen.

-

Ist Dokumenten-Parsing dasselbe wie Web Scraping?

-

Nein. Dokumenten-Parsing arbeitet mit Dateien wie PDFs, gescannten Bildern oder E-Mails, die Sie bereits besitzen oder erhalten haben, während Web Scraping Daten von Websites extrahiert, indem es HTML- oder gerenderte Inhalte analysiert.

-

Ist Parseur ein Web-Scraping-API-Tool?

-

Nein. Parseur ist eine Dokumenten- und E-Mail-Parsing-API, kein Tool für Web Scraping. Es crawlt oder lädt keine Webseiten herunter. Stattdessen hilft es Ihnen, Dokumente, die Sie besitzen, wie E-Mails, PDFs, Bilder oder Office-Dateien, in sauberes, strukturiertes JSON umzuwandeln. Das macht es ideal für Workflows wie die Verarbeitung von Rechnungen, Quittungen und Bestellungen, ohne komplexe interne Tools entwickeln zu müssen.

-

Ist Web Scraping legal?

-

Das hängt vom Kontext ab. Das Scrapen öffentlicher Daten ist manchmal erlaubt, allerdings legen Webseiten oft Einschränkungen in ihren Nutzungsbedingungen oder der robots.txt-Datei fest. Überprüfen Sie immer diese Dokumente und sprechen Sie im Zweifel vorab mit Rechtsbeistand.

-

Wann sollte ich auf Scraping verzichten?

-

Scraping sollte vermieden werden, wenn sich Daten hinter Bezahlschranken befinden, strengen Zugriffsbeschränkungen unterliegen oder ausdrücklich in den Nutzungsbedingungen der Website untersagt sind. Der Versuch, solche Beschränkungen zu umgehen, kann zu Compliance- und Rechtsrisiken führen.

Zuletzt aktualisiert am