Points Clés :

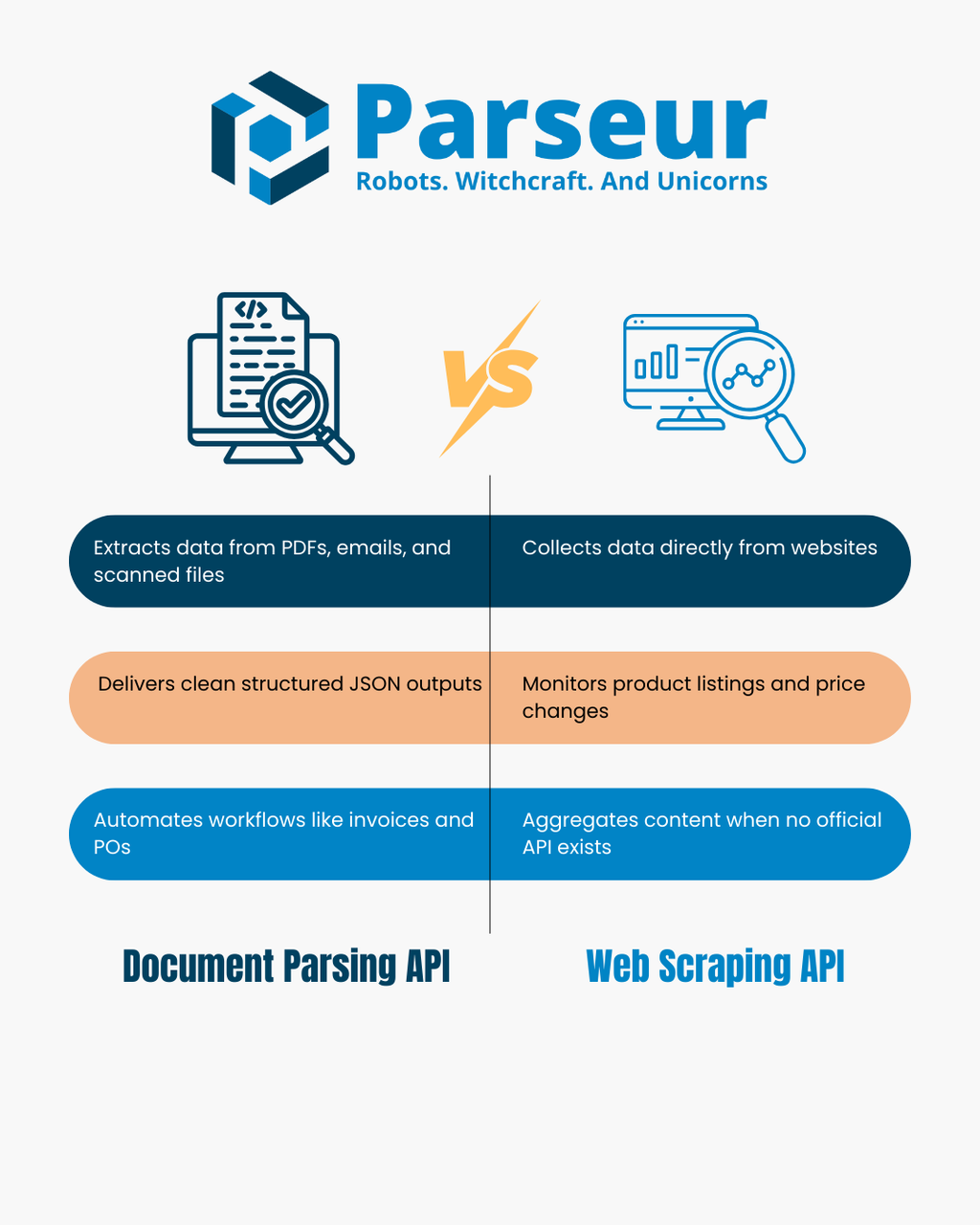

- Les APIs de parsing de documents extraient des données structurées à partir de fichiers que vous possédez, comme des PDF, images et emails.

- Les APIs de web scraping collectent des informations à partir de pages web publiques en traitant le HTML ou le contenu rendu.

- Le bon choix dépend de votre source : fichiers reçus vs sites web à surveiller.

- Beaucoup d’équipes utilisent des workflows hybrides, en scrapant pour obtenir des documents puis en les traitant via parsing pour obtenir un JSON fiable.

API de Parseur de Documents vs API de Web Scraping

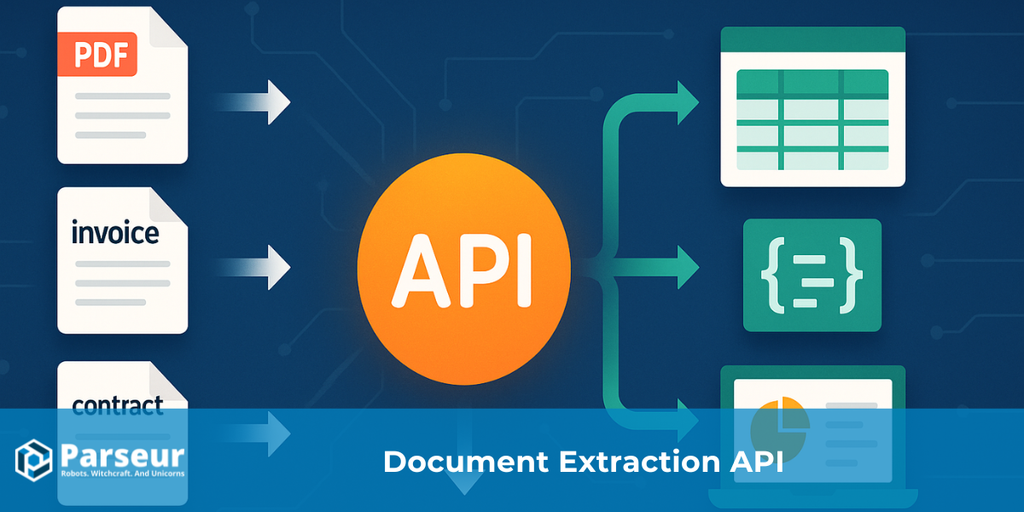

Une API de parsing de documents convertit des fichiers tels que des PDF, images scannées ou emails en JSON structuré. Elle analyse la mise en page et le texte du document pour extraire des couples clé-valeur et des tableaux, rendant plus facile l’automatisation de processus comme la gestion de factures, le suivi de bons de commande ou les workflows email-vers-database.

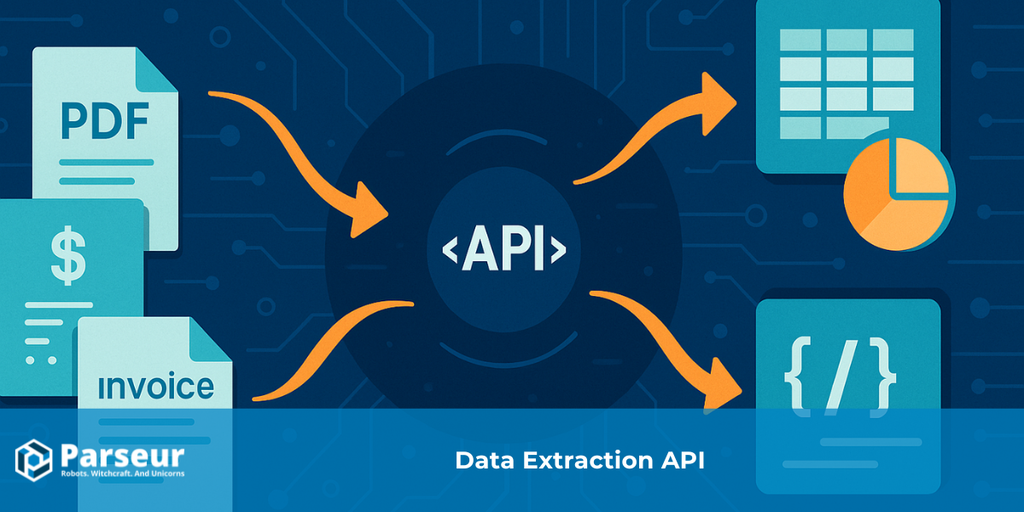

Une API de web scraping collecte des données directement depuis des sites web en récupérant et traitant les pages web, puis en parcourant le HTML ou le DOM rendu. En l’absence d’API officielle, le web scraping est utilisé pour surveiller des catalogues produits, suivre les changements de prix, agréger de l’actualité ou construire des jeux de données.

Les deux méthodes extraient des données mais s’appliquent à des sources très différentes : les APIs de parsing de documents traitent les fichiers que vous possédez, tandis que les APIs de web scraping ciblent les pages web que vous consultez. Cet article compare leurs forces et faiblesses, vous propose un arbre décisionnel, un tableau comparatif et des exemples concrets. Pour un panorama plus large de l’automatisation de la donnée, consultez notre guide sur l’API d’extraction de données.

Comment Fonctionnent les APIs de Parsing de Documents et de Web Scraping

Les APIs de parsing de documents et les APIs de web scraping relèvent toutes deux de l’extraction de données, mais leur fonctionnement et les problèmes qu’elles résolvent sont fondamentalement différents. Comprendre comment chacune opère est la première étape pour choisir l’option adaptée à vos besoins métier.

Une étude de Scrapingdog révèle que 34,8 % des développeurs utilisent désormais des APIs de web scraping, illustrant la tendance à privilégier les solutions clé en main au développement de scripts maison.

API de parseur de documents

Une API de parseur de documents se concentre sur l’extraction d’informations structurées depuis des fichiers que vous possédez ou recevez légalement. Ceux-ci incluent des PDF, images scannées, emails avec pièces jointes et parfois des fichiers Office. L’API analyse la disposition et le texte du document pour extraire automatiquement les données importantes, évitant ainsi la saisie manuelle.

- Entrées : PDF, scans, images, emails et fichiers Office.

- Sorties : JSON structuré et propre contenant des couples clé-valeur, tableaux et champs paramétrés.

- Fonctionnement : Via l’OCR et des règles de parsing, l’API détecte blocs de texte, montants et tableaux, puis les formate de manière homogène pour intégration dans vos systèmes aval (CRM, ERP, base de données…).

- Cas d’usage : Automatisation du traitement de factures ou reçus, extraction des lignes de bons de commande, parsing d’états financiers ou gestion de grands volumes de formulaires clients. De nombreuses équipes utilisent le parsing pour transformer leurs emails en données structurées afin de déclencher des workflows dans Zapier, Make ou n8n.

API de web scraping

Une API de web scraping, à l’inverse, est conçue pour extraire de l’information directement sur le web ouvert. Elle n’a pas affaire à des fichiers : elle récupère des pages web et transforme leur contenu en format exploitable. Le scraping consiste à collecter le HTML brut, à rendre des pages via navigateur sans interface graphique, et à appliquer des sélecteurs ou des instructions JavaScript pour extraire des champs précis.

- Entrées : URL de sites web, contenu HTML, endpoints JSON.

- Sorties : Données parsées structurées, souvent en JSON ou CSV, prêtes pour analyse ou intégration.

- Fonctionnement : L’API charge la page, analyse son DOM (Document Object Model) et applique des instructions comme sélecteurs CSS ou XPath pour capter produits, prix ou titres. Certains outils gèrent aussi proxies et protections anti-bot pour l’accès à grande échelle.

- Cas d’usage : Suivi des prix sur les e-shops concurrents, collecte de catalogues produits, agrégation de news, suivi d’offres d’emploi ou constitution de jeux de données sans API officielle.

Par conception, le parsing de documents convient aux fichiers que vous détenez ou recevez, tandis que le web scraping excelle à collecter l’information depuis des pages web publiques.

Arbre Décisionnel : De Quoi Avez-vous Besoin ?

Choisir entre une API de parsing de documents et une API de web scraping dépend le plus souvent de la source de vos données et de l’objectif final. Voici un mini-arbre décisionnel avec des explications pratiques pour chaque cas.

!

Votre source est-elle un fichier (PDF, image, ou pièce jointe d’email) que vous possédez légalement ?

→ Optez pour une API de parsing de documents. Elle transformera ces fichiers en JSON propre, extraira les champs clés et pourra récupérer les lignes des tableaux automatiquement.

Votre source est-elle une page web publique, ou un jeu de données en ligne ?

→ Optez pour une API de web scraping. Elle récupérera le HTML ou le contenu affiché et vous permettra d’extraire les points de données nécessaires, comme des listes produits ou des articles d’actualité.

Vous gérez à la fois des documents et des sites web ?

→ Parfois, il faut adopter une approche hybride. Exemple : vous scrapez un portail fournisseur pour télécharger des PDF, puis vous passez ces fichiers à une API de parsing pour extraction structurée.

Avez-vous besoin de tableaux structurés ou de lignes détaillées (factures, reçus, bons de commande) ?

→ C’est là qu’une API de parsing de documents est imbattable. Elle traite précisément les tableaux et données financières pour garantir cohérence et exactitude du schéma.

Avez-vous besoin de mises à jour en temps réel depuis des sources dynamiques (changements de prix, news, etc.) ?

→ Préférez une API de web scraping, capable de sonder les sites en continu et de capter les mises à jour au fil de l’eau.

Cet arbre de décision vous aide à associer rapidement votre cas d’usage à la bonne solution, ou à la combinaison des deux si besoin.

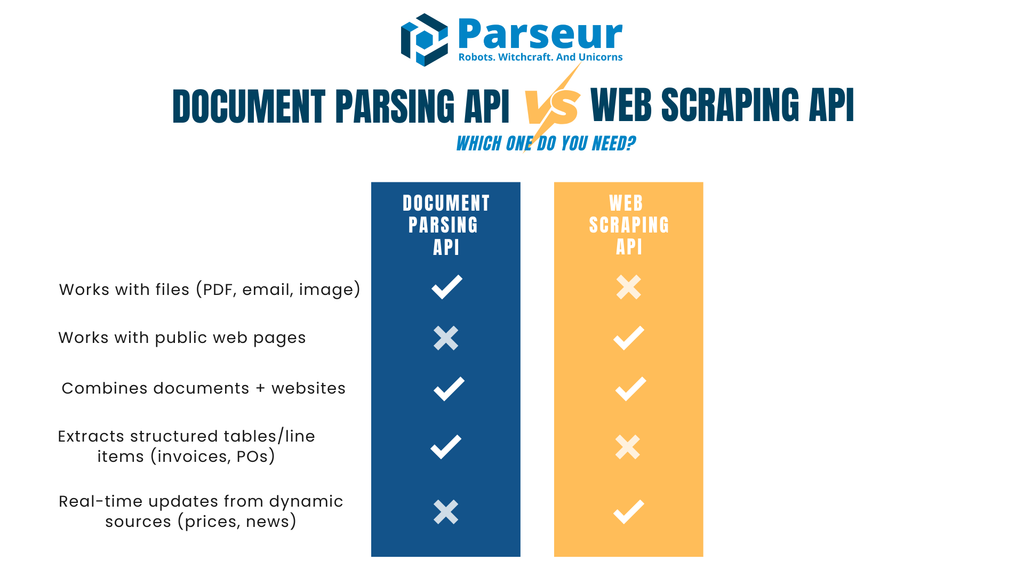

API de Parseur de Documents vs API de Web Scraping

Comparer les APIs de parsing documentaire et de web scraping demande d’analyser leurs avantages et limites en vis-à-vis. Le tableau ci-dessous détaille les critères standard d’évaluation : entrées et sorties, sécurité, conformité… pour savoir laquelle cadre le mieux avec vos besoins.

| Critère | API de Parsing de Documents | API de Web Scraping |

|---|---|---|

| Entrée Principale | Fichiers (PDF, images scannées, emails avec pièce jointe) | Pages web (HTML/JSON), ou contenu DOM rendu |

| Sorties Types | JSON avec couples clé-valeur, tableaux de lignes, champs structurés | HTML parsé converti en JSON ou CSV via sélecteurs |

| Sensibilité aux changements | Stable : une fois le type de fichier défini, le parsing reste cohérent | Fragilité : un changement du DOM ou du layout peut casser les sélecteurs |

| Cas d’usage | Factures, bons de commande, contrats, formulaires, états financiers, emails opérationnels | Catalogues produits, veille prix, sites d’emploi, agrégation de news |

| Acquisition | Vous (ou vos utilisateurs) fournissez les documents | Les données sont récupérées sur des sites tiers |

| Enjeux légaux | Vie privée et conformité (contrôleur/sous-traitant, politique de rétention) | Conditions d’utilisation, robots.txt, protections anti-bot |

| Latence & échelle | Idéal pour lots, traitements asynchrones, intégration via webhook | Contraintes sur le taux de crawl, règles anti-bot, gestion concurrence |

| Maintenance | Ajustements de templates ou schémas à l’occasion | Mises à jour régulières des sélecteurs, gestion anti-bot |

| Qualité des données | Sortie structurée, validation, normalisation des champs | Dépend de la qualité du site et du HTML |

| Sécurité | Chiffrement en transit et au repos, webhooks signés, accès par rôles | Nécessite rotation IP, proxies, sécurité réseau |

| Compatibilité LLM | Idéal pour alimentation JSON structurée vers IA/ML | Idéal pour enrichissement texte libre, synthèse, classification |

| Quand choisir ? | Si vous recevez déjà des documents (factures, reçus, contrats…) | Si vous avez besoin de contenu web en direct (prix, stocks, titres…) |

Quand le Web Scraping est-il l’Outil Idéal (et comment le pratiquer de façon responsable) ?

Les APIs de web scraping sont préférables lorsque l’information recherchée n’est disponible que sur des sites web et non fournie en fichier. Elles permettent la collecte à grande échelle sans attendre qu'un partenaire, fournisseur ou client vous transmette un document. Le scraping excelle pour l’étude de marché, le suivi tarifaire et l’agrégation de connaissances nécessitant des mises à jour fréquentes.

Les données de Browsercat montrent que le marché mondial du web scraping était estimé à 1,01 milliard USD en 2024 ; il devrait atteindre 2,49 milliards USD en 2032, soit une croissance annuelle composée de 11,9 % (CAGR).

Exemples où le scraping brille :

- Suivi des prix ou de la disponibilité produit sur plusieurs sites e-commerce

- Agrégation de titres d’actu ou d’annonces publiques de différents médias

- Création de jeux de données d’offres d’emploi, d’annuaires, d’événements… sans API officielle

Comme le web scraping consiste à collecter des infos sur des sites tiers, il est impératif d’adopter de bonnes pratiques :

- Lire robots.txt et conditions d’utilisation avant de scraper

- Appliquer des limites de fréquence pour ne pas saturer les serveurs

- Utiliser du cache pour éviter des requêtes répétées inutiles

- S’identifier clairement, pas de dissimulation du scraper

- Privilégier l’API officielle si elle existe

En pratique, le scraping est fragile : la moindre modification du HTML peut casser les sélecteurs et produire des données erronées ou incomplètes. Il faut donc mettre en place du monitoring et des alertes pour corriger sans délai.

Enfin, dans beaucoup de workflows, le scraping n’est qu’une brique : par exemple, vous scrapez des fichiers PDF sur un portail fournisseur, puis vous les passez à une API de parsing de documents pour extraction structurée. Ce modèle hybride conjugue la puissance du scraping et la fiabilité du parsing.

Défis des APIs de Web Scraping

Les APIs de web scraping sont puissantes pour collecter des données en temps réel, mais présentent de vrais défis à anticiper. Les connaître permet d’intégrer la démarche dans le bon contexte.

Une analyse de Octoparse montre que seuls 50 % des sites sont faciles à scraper, 30 % sont moyennement difficiles et les 20 % restants sont particulièrement complexes, à cause de structures web alambiquées ou de protections anti-scraping.

Changements fréquents de sites web

Les sites web ne sont pas conçus pour être scrapés : une simple modification du HTML, un renommage de classe CSS ou un changement de layout peut casser vos scripts de scraping. Cela se traduit par des frais de maintenance récurrents et l'obligation de monitorer la chaîne de scraping pour préserver la fiabilité.

Mesures anti-robots

Beaucoup de sites recourent à des mesures telles que CAPTCHA, limitation d’IP, validation de session ou détection de bots. Pour éviter les blocages, il faut recourir à la rotation de proxies, gestion des agents utilisateurs, limitation des requêtes : autant de surcoût technique.

Problèmes juridiques et éthiques

Le web scraping se situe dans une zone légale grise. Scraper des données publiques peut être autorisé, mais ignorer les CGU, robots.txt ou contourner des paywalls expose à de vrais risques. Il est crucial d’établir des règles d’éthique claires et, en cas de doute, de consulter un juriste avant tout scraping d’ampleur.

Qualité et cohérence des données

Les sites sont conçus pour les humains, pas pour les machines. Les données scrapées nécessitent souvent un nettoyage supplémentaire. HTML incohérent, contenu dynamique ou doublons entraînent des datasets à retraiter avant exploitation.

Défis de montée à l’échelle

Le scraping à grande échelle requiert une infrastructure solide : gestion de la concurrence, des erreurs, de la distribution des charges… Plus l’opération grossit, plus les coûts (proxies, serveurs, monitoring) augmentent vite.

Durabilité sur le long terme

Le scraping reste fragile pour des processus métier continus. Les pipelines de scraping nécessitent des ajustements constants, à la différence des API officielles ou des flux documentaires structurés. Il faut donc prévoir un budget et une équipe pour la maintenance durable.

Quand privilégier une API de Parsing de Documents ?

Une API de parsing de documents est la meilleure option si l’information recherchée vous parvient déjà sous forme de documents, pas via des sites web. Ces documents (PDF, scans, emails avec PJ…) arrivent chez vous ou vos clients. Plutôt que de les saisir à la main, l’API automatise la transformation en données structurées.

D’après Sphereco, 80 % des données en entreprise sont non structurées (emails, PDF, scans), rendant le parsing documentaire essentiel pour l’efficacité et l’analyse.

Cas d’usage typiques :

- Factures et reçus : extraction du nom du fournisseur, dates, montants, lignes pour workflows comptables

- Bons de commande et relevés : collecte de numéros, montants, échéances pour réconciliation plus rapide

- Formulaires et contrats : extraction de champs comme infos clients ou dates de signature

- Emails opérationnels : conversion de confirmations, avis d’expédition ou demandes de réservation en JSON pour intégration SI

Une API de parsing documentaire est particulièrement utile quand il faut précision et cohérence. Elle structure le texte, normalise formats et valide les champs, avec résultat livré par webhook ou API directement exploitable. Vos données deviennent fiables et prêtes à l’automatisation sans traitement supplémentaire.

Le parsing de documents est plus stable que le scraping web : la structure des fichiers évolue bien moins souvent que celle d’un site. Une fois paramétrées, les règles de parsing fonctionneront sur des milliers de documents sans modification.

Si votre activité traite beaucoup de documents fournisseurs, relevés clients ou emails, une API de parsing documentaire est souvent la solution la plus rapide et la plus pérenne.

Modèles Hybrides : Chevauchements Réels

Dans de nombreux workflows, parsing documentaire et web scraping ne sont pas en concurrence mais complémentaires. Vos sources peuvent être à la fois des documents et des sites : combiner les deux méthodes offre une solution globale et efficace.

Exemples de modèles hybrides :

- Scraper pour télécharger des PDF, puis les parser : Un portail fournisseur héberge des factures/BP en PDF ; un scraping API télécharge les fichiers, puis une API de parsing extrait lignes, totaux, champs structurés.

- Parser puis enrichir avec des données scrapées : Après parsing de factures, il peut manquer du contexte fournisseur ou un benchmark : un scraping API collecte cette info publique, tandis que le parsing garantit la justesse des données financières.

- Parsing d’emails + vérification web : Les confirmations ou expéditions arrivent par email : vous parsez les détails, puis vérifiez la disponibilité en stock ou le prix en temps réel via API de scraping sur le site fournisseur.

- Ajout d’une couche d’intelligence : Dès qu’un JSON structuré est disponible, vous pouvez le croiser avec des données du web puis appliquer analytics ou catégorisation. Ce modèle permet de normaliser, détecter les anomalies ou centraliser vos sources.

Le modèle hybride valorise les atouts de chaque méthode. Les APIs de parsing produisent une sortie structurée et fiable depuis les documents, tandis que les APIs de scraping offrent le complément d'information web indisponible autrement. En combinant les deux, vous réduisez la saisie manuelle et élargissez l’automatisation sur l’ensemble de vos opérations.

Parseur : API de Parsing de Documents ou API de Web Scraping ?

Parseur est une API de parsing de documents et d’emails puissante, qui transforme des fichiers non structurés en données JSON structurées. Contrairement à une API de web scraping, qui extrait l’information directement sur les sites web, Parseur travaille sur les fichiers et emails que vous ou vos utilisateurs possédez déjà. C’est une solution stable et évolutive pour automatiser le traitement des données, sans dépendre des changements web, restrictions ou problèmes de rendu. Avec Parseur, vous pouvez booster vos processus d’automatisation de factures, reçus, bons commande ou formulaires clients.

Concrètement, cela veut dire :

- Ce que fait Parseur : ingestion d’emails, PDF, images et fichiers Office, restitution en JSON structuré (champs clé-valeur, tableaux). Livraison des données par webhook ou accès direct via API.

- Gestion des données : Parseur agit strictement en tant que sous-traitant sous votre contrôle. DPA disponible, liste de sous-traitants transparente, politiques de rétention et suppression réglables, chiffrement des données en transit et au repos, webhooks signés pour la livraison.

- Pour qui ? Parseur est idéal pour les équipes recevant surtout des documents par email (factures, reçus, bons de commande, relevés financiers…), qui veulent extraire rapidement et fiablement des données structurées sans coder.

Pourquoi l’API Parseur se démarque

L’avantage clé de Parseur API : elle combine API et application web. Les développeurs intègrent l’API dans leurs applications ; le Support Client et les Opérations utilisent l’interface web pour contrôler, valider et améliorer les résultats du parsing, sans recourir au développement.

Cet usage double évite d’avoir à construire des outils de supervision complexes. L’application web permet à chacun de définir son schéma JSON et ses champs en quelques clics, d’ajuster les règles à la volée et de valider ses extractions. Cette flexibilité favorise la collaboration technique et non-technique, tout en gardant l’intégration légère.

Contrairement au web scraping, dépendant de la fragilité des sites, Parseur travaille avec les fichiers que vous possédez déjà—ce qui constitue un socle fiable pour l’automatisation métier.

Comment Parseur Gère vos Données

Parseur n’est pas une API de web scraping, mais il est conçu pour traiter vos documents et emails de manière performante et sécurisée. Si vos équipes reçoivent beaucoup de PDF, images scannées ou pièces jointes email, Parseur reste une solution fiable pour convertir ces fichiers en JSON structuré intégrable à grande échelle.

L’engagement fort de Parseur pour la sécurité, la vie privée et la conformité en fait un outil à part. Vous pouvez utiliser Parseur en toute confiance, sachant que vos informations sont traitées de façon responsable, dans le respect des meilleures pratiques internationales.

Points clés de la gestion de la donnée chez Parseur

Conçu pour les documents et emails

Parseur prend en charge PDF, images et emails, puis fournit un JSON structuré via webhooks ou appels API. Cela permet d’automatiser la gestion des factures, des bons de commande, ou des workflows email-to-database sans coder.

Vous gardez la maitrise de vos données

Vous restez propriétaire de vos données envoyées à Parseur. L’outil n’agit que sur instructions explicites : vous choisissez votre durée de conservation (jusqu’à un jour). Une fonction Process then Delete permet d’effacer immédiatement les documents après parsing.

Où sont stockées vos données ?

Toutes les données Parseur sont conservées dans l’Union Européenne (Pays-Bas), dans un datacenter hautement sécurisé propulsé par Google Cloud Platform (GCP), lui-même certifié ISO 27001. Voir plus d'infos ici.

Sécurité et chiffrement

Toutes vos données sont encryptées au repos (AES-256) comme en transit (TLS v1.2 et plus). Les protocoles anciens (SSLv2, v3, TLS 1.0/1.1) sont désactivés. Parseur utilise Let’s Encrypt SSL Certificates, standard mondial, pour sécuriser la communication entre ses serveurs, les apps tierces et votre navigateur.

Surveillance de l’infra et tests de pénétration

Parseur contrôle en continu son infrastructure et ses dépendances, corrigeant toute faille identifiée. Des sociétés indépendantes procèdent régulièrement à des tests de pénétration selon les référentiels OWASP Top 10 et SANS 25. Les clients entreprise peuvent demander les rapports complets. En 2025, Parseur a reçu une certification Astra Pentest, preuve concrète de sa robustesse cybersécurité.

Sécurité des mots de passe et comptes

Parseur ne stocke jamais vos mots de passe : il utilise un algorithme PBKDF2 SHA-256 avec sel 512 bits et 600 000 cycles d’itération, largement au-delà des recommandations NIST, pour garantir la sécurité d’accès.

Fiabilité opérationnelle et SLA

Parseur vise 99,9 % de disponibilité ou plus, avec mécanismes de retry et backoff pour qu’aucune donnée ne soit perdue même en cas d’indisponibilité. Les plateformes d’emails tentent les envois durant 24h, double expédition pour la redondance. Les offres entreprise montent à 99,99 % uptime avec garanties supplémentaires. Historique de disponibilité ici.

RGPD et confidentialité dès la conception

Parseur est totalement RGPD conforme et agit en tant que sous-traitant sous votre unique contrôle. Vous restez le Contrôleur et propriétaire de vos documents. Parseur ne vend ni ne partage vos données. Les membres de l’équipe n’y accèdent que sur demande explicite. Tous suivent une formation régulière à la confidentialité et la protection. En savoir plus RGPD & Parseur.

Gestion des incidents et notifications de faille

En cas exceptionnel de faille de sécurité, Parseur s’engage à notifier ses clients sous 48h : transparence et conformité légale garanties. Parcourez également l’Aperçu sécurité et confidentialité ici

Législation & Conformité en Bref

L’aspect légal et la conformité sont essentiels pour trancher entre parsing documentaire et web scraping. Les deux impliquent une manipulation de la donnée, mais les obligations diffèrent selon la source.

Les organisations doivent garantir une base légale solide pour traiter les documents, souvent via un accord avec le détenteur de la donnée. Il s’agit aussi de définir les rôles réglementaires (contrôleur/sous-traitant), signer un DPA, fixer la politique de rétention, et anticiper l’obligation d’alerte en cas d’incident et la minimisation des données récoltées.

Le web scraping, lui, est plus complexe juridiquement. S’il peut être permis dans certains pays sur de la donnée publique, de nombreux sites l’interdisent (conditions d'utilisation, robots.txt). Contourner paywall, contrôle d’accès ou mesures anti-bot accroît le risque légal. Les entreprises doivent toujours consulter leur service juridique pour garantir la conformité.

Les transferts internationaux ajoutent une couche de complexité supplémentaire. Si votre flux traite de la donnée personnelle en provenance de l’UE ou de zones réglementées, il faudra vérifier la conformité juridique du mécanisme de transfert.

Conclusion : Quelle API Choisir pour vos Données ?

Le parsing de documents et le web scraping sont tous deux essentiels pour automatiser la collecte de données, mais ils répondent à des besoins bien différents. Le parsing s’applique quand vous traitez des documents que vous possédez (factures, relevés, emails…).

D’après Experlogix, l’automatisation documentaire peut réduire jusqu’à 80 % le temps de traitement, preuve des gains majeurs apportés par le parsing de documents.

Le scraping est adapté si vos données n’existent que sur des sites publics (catalogues produits, prix, etc.). Dans certains workflows, les équipes scrapent pour récupérer des documents, puis les parsant pour sortir un JSON fiable.

En résumé : choisissez selon l’origine de vos données. Si elles arrivent en PDF, scan ou email, une API de parsing vous fera gagner du temps et garantira la précision. Si elles résident sur des pages web, le scraping sera le mieux adapté. En présence de multiples sources, combiner les deux stratégies donne une solution complète.

Questions Fréquemment Posées

De nombreux lecteurs se posent des questions récurrentes lorsqu'ils comparent le parsing de documents et le web scraping. Voici les réponses aux questions les plus posées pour clarifier leurs différences et cas d’usage concrets.

-

Le parsing de documents est-il la même chose que le web scraping ?

-

Non. Le parsing de documents travaille avec des fichiers comme des PDF, images scannées ou emails que vous possédez déjà ou avez reçus, tandis que le web scraping extrait des données de sites web en analysant le HTML ou le contenu affiché.

-

Parseur est-il un outil API de web scraping ?

-

Non. Parseur est une API de parsing de documents et d'emails, pas un outil de web scraping. Il ne recherche pas et ne récupère pas de pages web. Il vous aide à transformer les documents que vous possédez, tels que des emails, PDF, images ou fichiers Office, en JSON structuré et propre. C’est idéal pour des workflows comme le traitement de factures, de reçus ou de bons de commande, sans avoir à développer des outils internes complexes.

-

Le web scraping est-il légal ?

-

Cela dépend du contexte. Scraper des données publiques est parfois possible, mais les sites stipulent souvent des restrictions dans leurs conditions d'utilisation ou leur fichier robots.txt. Lisez toujours ces documents et consultez un conseiller juridique avant toute extraction.

-

Quand dois-je éviter le scraping ?

-

Il faut éviter le scraping si les données sont protégées par des paywalls, soumises à des contrôles d’accès stricts ou explicitement interdites par les conditions d’utilisation du site. Tenter de contourner ces restrictions présente un risque légal et de conformité.

Dernière mise à jour le