Belangrijkste Punten:

- Document parsing API’s halen gestructureerde data uit bestanden waar jij eigenaar van bent, zoals PDF’s, afbeeldingen en e-mails.

- Web scraping API’s verzamelen informatie van openbare webpagina’s door HTML of gerenderde inhoud te parsen.

- De juiste keuze hangt af van jouw databron: bestanden die je ontvangt versus websites die je wilt monitoren.

- Veel teams gebruiken hybride workflows, waarbij scraping wordt ingezet om documenten te verzamelen en parsing om betrouwbare JSON eruit te halen.

Document Parsing API vs Web Scraping API

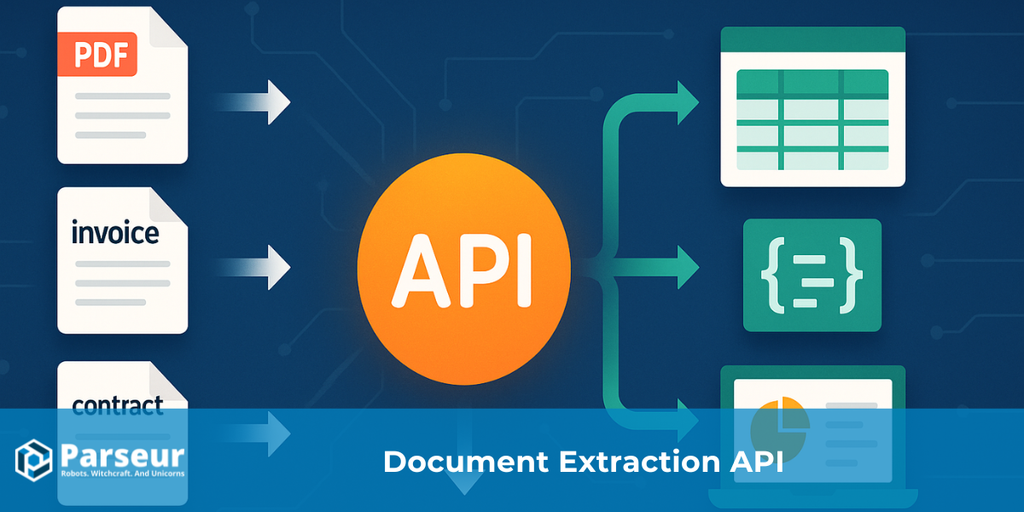

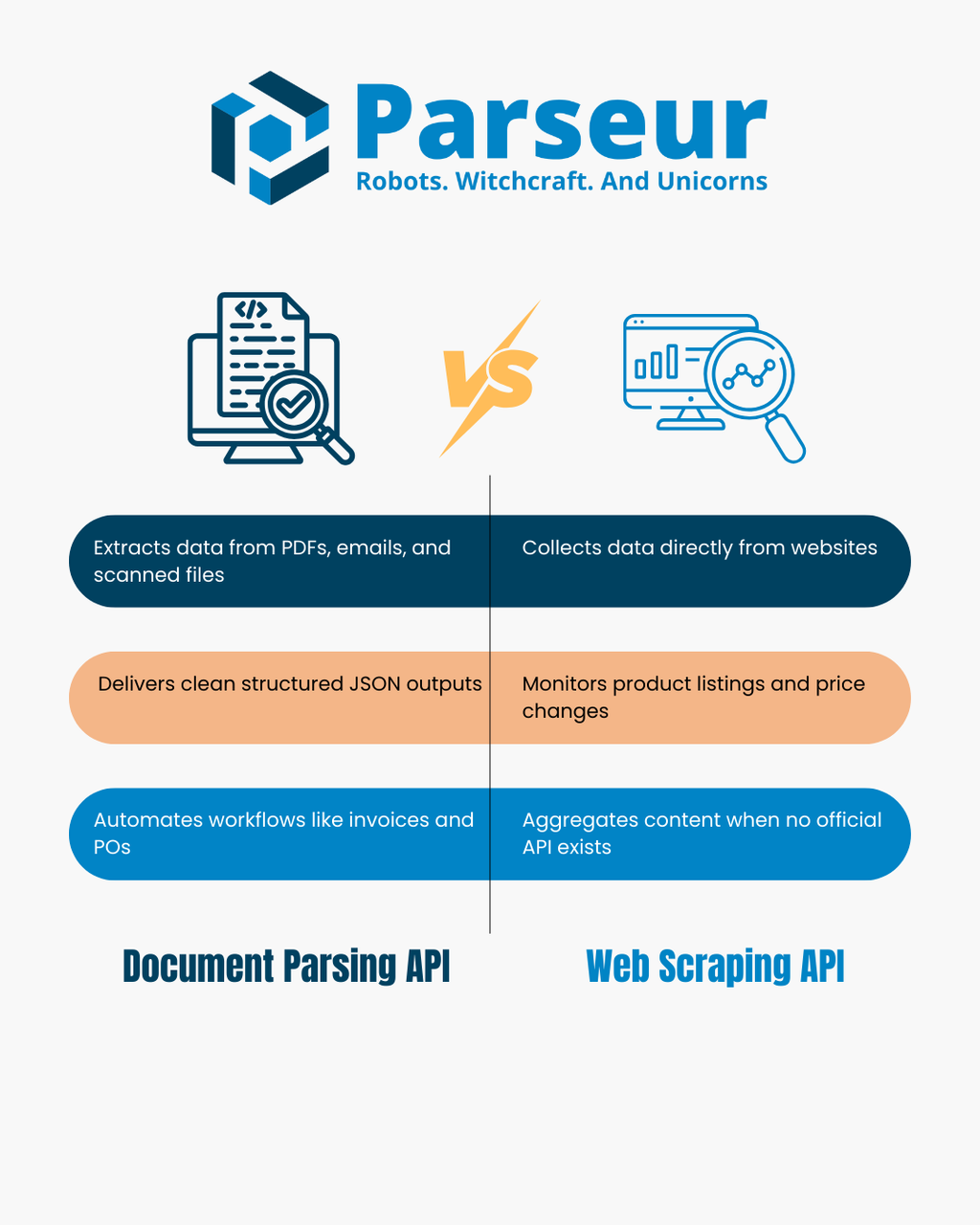

Een document parsing API zet bestanden zoals PDF’s, gescande afbeeldingen en e-mails om in gestructureerde JSON. Deze API analyseert de opmaak en tekst van het document om belangrijke gegevens en tabellen te extraheren, zodat je processen als factuurbeheer, orderverwerking of e-mail-naar-database automatisering moeiteloos kunt stroomlijnen.

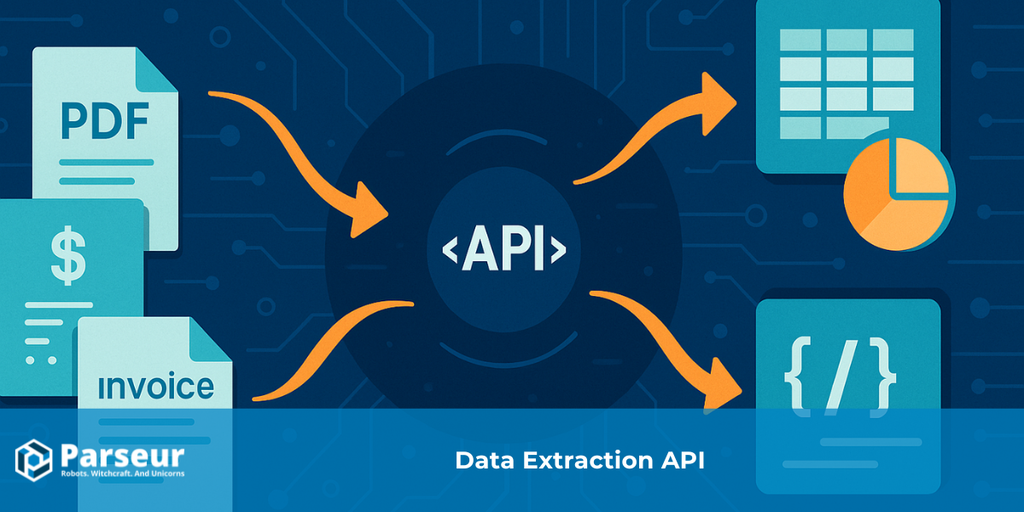

Een web scraping API haalt rechtstreeks data van websites door webpagina’s automatisch op te halen en de HTML of het gerenderde DOM te analyseren. Wanneer er geen officiële API’s beschikbaar zijn, wordt web scraping ingezet om producten te monitoren, prijzen bij te houden, nieuws te verzamelen of datasets samen te stellen.

Beide methodes bieden data-extractie, maar ze werken met fundamenteel verschillende bronnen: document parsing API’s verwerken eigen bestanden, terwijl web scraping API’s zich richten op externe webpagina’s. In dit artikel vergelijken we hun sterke en zwakke punten, presenteren we een beslisboom, een overzichtstabel en praktijkvoorbeelden. Voor meer context over data-automatisering, lees ook onze Data Extraction API-gids.

Hoe Werken Document Parsing API’s en Web Scraping API’s?

Document parsing API’s en web scraping API’s vallen beide onder data-extractie, maar verschillen wezenlijk in techniek en toepassingsgebied. Begrijpen hoe beide oplossingen werken, helpt je de juiste keuze te maken voor jouw organisatie.

Uit onderzoek van Scrapingdog blijkt dat 34,8% van de ontwikkelaars inmiddels web scraping API’s gebruikt, een duidelijke trend richting gestructureerde, kant-en-klare data-extracties in plaats van eigen scripts.

Document parsing API

Een document parsing API is gespecialiseerd in het extraheren van gestructureerde informatie uit bestanden die jij al bezit of rechtsgeldig hebt ontvangen. Denk aan PDF’s, gescande documenten, e-mails met bijlagen of Office-bestanden. In plaats van handmatige data-invoer verwerkt de API deze documenten automatisch en haalt er relevante informatie uit.

- Input: PDF’s, scans, afbeeldingen, e-mails en Office-bestanden.

- Output: Schone, gestructureerde JSON met sleutel-waarde paren, tabellen en aangepaste velden.

- Hoe werkt het: Met Zonale OCR, Dynamische OCR en parsing-routines worden tekstgebieden, cijfers en tabellen herkend. De API zet deze om naar een constant formaat dat eenvoudig te integreren is in downstreamsystemen zoals CRM, ERP of databases.

- Typische toepassingen: Automatiseren van factuur- en bonnetjesverwerking, het extraheren van regels uit bestelbonnen, uitlezen van financiële rapporten of het beheren van grote aantallen klantformulieren. Veel teams gebruiken document parsing ook om e-mails automatisch om te zetten in gestructureerde data die workflowtools als Zapier, Make of n8n kunnen aansturen.

Web scraping API

Een web scraping API daarentegen is ontwikkeld om informatie direct vanaf het open web te verzamelen. Er zijn dus geen bestanden nodig; in plaats daarvan wordt data direct van websites verzameld en verwerkt. Het scrapingproces omvat het ophalen van HTML, eventueel renderen via een headless browser, en het toepassen van selectors of JavaScript om gewenste velden te extraheren.

- Input: URL’s van websites, HTML-pagina’s of JSON-endpoints.

- Output: Geparste en gestructureerde data, meestal in JSON- of CSV-formaat, klaar voor integratie of analyse.

- Hoe werkt het: De API laadt een webpagina, analyseert het DOM (Document Object Model), en gebruikt bijvoorbeeld CSS-selectors of XPath om informatie zoals productnamen, prijzen of headlines te extraheren. Geavanceerde tools bieden ook ondersteuning voor proxies en anti-bot-technieken voor betrouwbare resultaten op schaal.

- Typische toepassingen: Concurrentieanalyse, prijsmonitoring, productcatalogi verzamelen, nieuwsaggregratie, vacatures verzamelen of omvangrijke datasets bouwen wanneer een officiële API ontbreekt.

Door het ontwerp zijn document parsing API’s bij uitstek geschikt voor bestanden die jij bezit of ontvangt, terwijl web scraping API’s uitblinken in informatie verzamelen van openbare webpagina’s.

Beslisboom: Welke Heb Jij Nodig?

Bepalen of een document parsing API of web scraping API de juiste oplossing is, hangt af van de bron van je data en je doelstelling. Deze beslisboom helpt je snel de juiste richting te kiezen, met korte praktijkgerichte toelichtingen.

!

Is je bron een bestand (PDF, afbeelding of e-mailbijlage) waar je wettelijk over beschikt?

→ Gebruik een Document Parsing API. Hiermee converteer je deze bestanden moeiteloos naar heldere JSON, inclusief belangrijke velden en tabellen, zonder handmatige invoer.

Is je bron een openbare webpagina of online dataset?

→ Gebruik een Web Scraping API. Hiermee verzamel je HTML of gerenderde pagina-inhoud, zodat je gericht de gewenste data binnenhaalt, zoals productoverzichten of nieuws.

Werk je met zowel documenten als websites?

→ Soms heb je een hybride aanpak nodig. Je kunt bijvoorbeeld een leveranciersportaal scrapen om PDF’s te downloaden, en deze daarna met een document parsing API gestructureerd uitlezen.

Heb je gestructureerde tabellen of detailregels nodig (zoals bij facturen, bonnetjes of bestellingen)?

→ Dan is een Document Parsing API perfect. Deze is ontworpen voor betrouwbare verwerking van tabulaire en financiële data wanneer nauwkeurigheid en schema-consistentie essentieel zijn.

Heb je realtime updates nodig van dynamische bronnen (denk aan prijswijzigingen of breaking news)?

→ Kies in dat geval voor een Web Scraping API, omdat deze continu websites kan monitoren en snel nieuwe informatie verwerkt.

Met deze beslisboom stem je je use-case razendsnel af op de juiste tool, of combineer je beide methodes efficiënt.

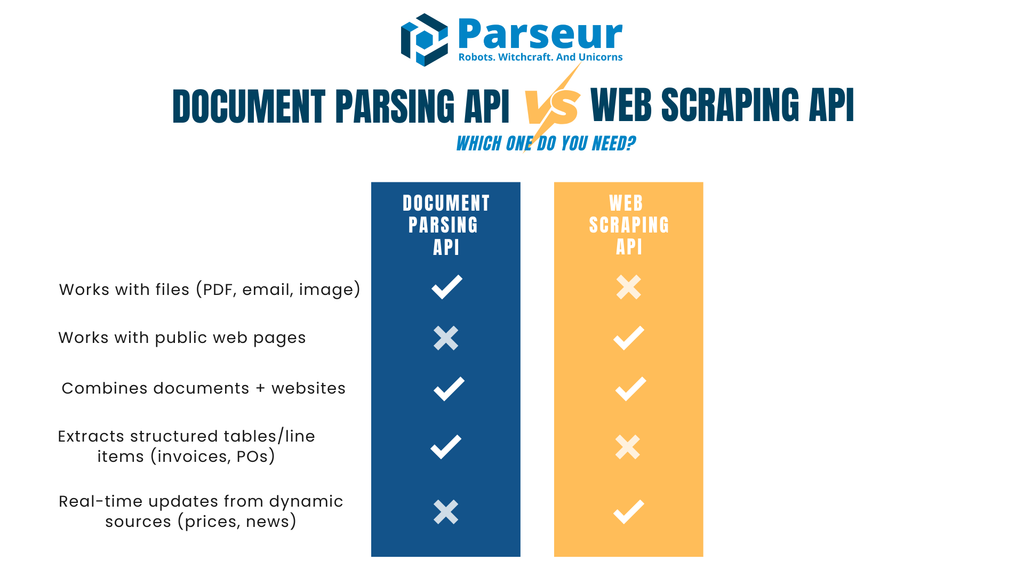

Document Parsing API vs Web Scraping API

Om goed te kiezen tussen een document parsing API of web scraping API, is het handig om de voornaamste verschillen op een rij te zetten. Onderstaande tabel biedt een overzicht langs belangrijke criteria van input tot beveiliging.

| Criterium | Document Parsing API | Web Scraping API |

|---|---|---|

| Primaire Input | Bestanden (PDF’s, scans, e-mails met bijlagen) | Webpagina’s (HTML/JSON), gerenderde DOM |

| Typische Output | JSON met sleutel-waardeparen, regeltabellen en gestructureerde velden | Geparste HTML-data omgezet in JSON of CSV via selectors |

| Veranderingsgevoeligheid | Stabiel: als documenttypes zijn ingesteld, blijft parsing consequent | Fragiele site-layout of DOM-wijzigingen kunnen selectors breken |

| Toepassingen | Facturen, bestelbonnen, contracten, formulieren, financiële rapporten, operationele mails | Productcatalogi, prijsupdates, vacatures, nieuwsaggregatie |

| Acquisitie | Jij of je gebruikers leveren de documenten aan | Data wordt direct van externe websites gehaald |

| Juridische focus | Privacy, compliance (data controller/processor, bewaarbeleid) | Sitevoorwaarden, robots.txt, anti-botbeleid |

| Latentie & schaal | Geschikt voor batchprocessing, asynchrone processen, webhooklevering | Beperkt door crawl rates, anti-botregels en concurrentiebeheer |

| Onderhoud | Sporadisch template-aanpassingen of schemawijzigingen | Regelmatig selectors bijwerken en anti-botmaatregelen |

| Datakwaliteit | Gestructureerd, validatieregels, gestandaardiseerde velden | Afhankelijk van sitekwaliteit en netheid van de HTML |

| Security | Encryptie in transport & opslag, getekende webhooks, toegang op rollen | Behoefte aan IP-rotatie, veilige proxies, nette netwerkhygiëne |

| LLM-koppeling | Ideaal voor gestructureerde JSON-input naar downstream AI/ML-systemen | Ideaal voor enrichment, samenvatten of classificatie van ongestructureerde tekst |

| Wanneer te kiezen | Gebruik als je al documenten ontvangt (facturen, bonnen, contracten) | Gebruik als je live websitecontent nodig hebt (prijzen, voorraad, headlines) |

Wanneer Is Web Scraping API De Beste Keuze (En Hoe Doe Je Dit Verantwoord)?

Web scraping API’s werken ideaal als de benodigde informatie alleen via websites openbaar gemaakt wordt en niet als downloadbare bestanden beschikbaar is. Je kunt data snel en op grote schaal verzamelen, onafhankelijk van externe leveranciers of klanten die documenten sturen. Web scraping werkt bijzonder goed bij marktanalyse, prijsmonitoring en content-aggregatie met hoge frequentie.

Volgens Browsercat bedroeg de wereldwijde markt voor web scraping in 2024 circa USD 1,01 miljard en groeit richting USD 2,49 miljard in 2032, met een indrukwekkende jaarlijkse groei (CAGR) van 11,9%.

Typische scenario’s voor web scraping:

- Vergelijken van prijzen of voorraad op diverse e-commercesites

- Nieuwsupdates of aankondigingen verzamelen van meerdere bronnen

- Opbouwen van datasets met vacatures, bedrijven of evenementen als geen officiële API bestaat

Omdat je scrapt van websites die je niet zelf beheert, is verantwoord gebruik extra belangrijk:

- Check altijd robots.txt en de sitevoorwaarden voor restricties

- Implementeer rate limiting; voorkom serveroverbelasting

- Zet caching in om onnodige verzoeken te vermijden

- Geef je scraper een nette identificatie; vermijd verbergen

- Bestaat er een officiële API? Gebruik deze als eerste keuze

De praktijk leert dat websites vaak wijzigen. Een kleine aanpassing in hun HTML-structuur kan al voor scraping-fouten zorgen of selectors laten breken, wat leidt tot ontbrekende of foute data. Monitoring en alerting zijn cruciaal om direct te kunnen reageren en bij te sturen.

In veel workflows is scraping niet de enige oplossing. Je kunt bijvoorbeeld scraping inzetten om PDF-bestanden te vinden of downloaden uit een leveranciersportaal en deze vervolgens door een document parsing API laten verwerken tot betrouwbare, gestructureerde JSON. Zo vul je het bereik van web scraping aan met de precisie van document parsing.

Uitdagingen Van Web Scraping API’s

Web scraping API’s zijn krachtig voor realtime data uit websites, maar brengen aanzienlijke uitdagingen en beperkingen met zich mee. Deze uitdagingen helpen juiste verwachtingen te scheppen en tonen waarom scraping in sommige gevallen wel, en in andere niet ideaal is.

Uit analyse van Octoparse blijkt dat slechts ongeveer 50% van de websites makkelijk te scrapen is, 30% matig uitdagend, en 20% zeer complex door ingewikkelde structuren of anti-scrapingmaatregelen.

Regelmatig veranderende websites

Websites zijn niet ontworpen met scraping in het achterhoofd. Zelfs kleine HTML-wijzigingen — een andere CSS-class of verschoven lay-out — kunnen scraping scripts breken. Hierdoor ontstaat doorlopend onderhoud en noodzaak tot actieve monitoring om je datastroom betrouwbaar te houden.

Anti-botmaatregelen

Veel sites beschermen zich met CAPTCHA’s, IP-throttling, sessiechecks en botdetectie. Om storingen te voorkomen moeten scraping-teams aan de slag met proxyrotatie, gebruikersagentmanagement en limieten, wat extra technisch werk vraagt.

Juridische en ethische kwesties

Web scraping zit in een juridische grijze zone. Publieke data scrapen mag vaak, maar het negeren van sitevoorwaarden of robots.txt, of het omzeilen van toegangsbeperkingen, brengt compliance- en juridische risico’s. Stel een duidelijk ethisch beleid op en raadpleeg legal als je grootschalige scrapers inzet.

Datakwaliteit en consistentie

Websites zijn bedoeld voor menselijke bezoekers, niet voor machines. Gescrapete data moet vaak verder opgeschoond en gevalideerd. Onregelmatige HTML-opbouw, JavaScript-content of dubbele records zorgen voor rommelige datasets die extra nabewerking vereisen.

Schaalbaarheid

Een scraping-operatie opschalen is niet zo simpel als meer requests sturen. Je hebt stevige infrastructuur nodig: concurrency, retry-logica, foutafhandeling en distributie. Grootschalig scrapen maakt proxies, meer servers en monitoringtools snel duurder.

Langetermijn houdbaarheid

Scraping kan een fragiele oplossing zijn voor structurele processen. Terwijl officieel gedefinieerde API’s of document parsing minder wijzigingen nodig hebben, vragen scraping pipelines structureel om tijd en onderhoud.

Wanneer Is Een Document Parsing API Beter?

Een document parsing API past perfect wanneer de informatie die je nodig hebt al bij jou binnenkomt als documenten, en niet op een website wordt gepubliceerd. Dit kunnen PDF’s zijn, gescande afbeeldingen of e-mails met bijlagen. In plaats van handmatig overtikken naar je database of ERP, automatiseert een parsing API deze stap en verandert ongestructureerde bestanden in bruikbare, gestructureerde data.

Volgens Sphereco is 80% van alle enterprise-data ongestructureerd, zoals e-mails, PDF’s en gescande documenten. Document parsing API’s zijn dus essentieel om op grote schaal efficiëntie en inzicht te ontsluiten.

Typische voorbeelden:

- Factuur- en bonverwerking: leveranciersnamen, data, bedragen en regeltabellen ophalen voor finance

- Bestelbonnen en statements: snel ordernummers, bedragen, betaalvoorwaarden registreren

- Formulieren en contracten: klantinformatie, ondertekeningsmomenten of standaardvelden extraheren

- Operationele e-mails: orderbevestigingen, verzendmeldingen, boekingsverzoeken direct naar JSON voor je systemen

Een document parsing API levert niet alleen tekst op, maar kan tevens velden normaliseren, valideren en via webhooks direct in applicaties of databases afleveren. Zo ontvang je direct bruikbare resultaten, klaar voor automatisering — zonder bijkomende schoonmaakrondes.

Document parsing is daarbij stabieler dan web scraping, omdat de structuur van bestanden minder vaak verandert dan HTML van websites. Zodra parsing-instructies zijn opgezet kun je jarenlang documenten betrouwbaar verwerken.

Draait jouw bedrijf om het verwerken van leveranciersdocumenten, klantafschriften of binnenkomende e-mails? Dan is een document parsing API vrijwel altijd sneller en duurzamer.

Hybride Modellen: Slimme Combinaties

In de praktijk zijn document parsing en web scraping vaker aanvullend dan concurrerend. Veel processen draaien op data uit documenten én van websites, waardoor combineren juist een sterke oplossing oplevert.

Enkele praktische hybride patronen:

- Scrapen om PDF’s te downloaden en dan parsen: Een leveranciersportaal heeft facturen als PDF’s. Een scraping API logt in en haalt deze op, de parsing API haalt daarna de regeltabellen, totalen en andere structuurdata.

- Document parsing verrijken met webdata: Nadat je facturen hebt geparsed kan je extra metadata, zoals leverancierscategorieën of benchmarks, scrapen en toevoegen.

- E-mail parsing combineren met websitevalidatie: Orderbevestigingen of verzendmeldingen per mail? Parse direct de data en check daarna via scraping de actuele voorraad of prijs op de leveranciersite.

- Intelligentielagen bovenop parsing: Zodra je JSON uit documenten hebt, combineer je dat met gescrapete websitedata en voeg je analyses en verrijking toe. Dit helpt bij het normaliseren van leveranciersnamen, het detecteren van afwijkingen of het koppelen van producten uit meerdere bronnen.

Hybride patronen benutten de sterktes van beide methodes. Parsing API’s zijn uitblinkers in gestructureerde, schema-gedreven output uit documenten; scraping geeft inzicht in live, web-native data. Door ze slim te combineren bespaar je handwerk en ga je richting volledige automatisering.

Is Parseur Een Document Parsing API Of Een Web Scraping API?

Parseur is een krachtige document- en e-mail parsing API die ongestructureerde documenten omzet naar gestructureerde JSON-data. In tegenstelling tot web scraping API’s, die informatie rechtstreeks van websites halen, richt Parseur zich volledig op de documenten en e-mails waar jij of jouw gebruikers eigenaar van zijn. Dit maakt het een stabiele en schaalbare oplossing voor workflow-automatisering zonder zorgen over websitewijzigingen, scrapingrestricties of renderingproblemen. Parseur helpt je processen te versnellen zoals factuurautomatisering, bontracking, orderafhandeling of het verwerken van klantformulieren.

Wat Dit In De Praktijk Betekent

- Wat doet Parseur: Verwerkt e-mails, PDF's, afbeeldingen en Office-bestanden tot gestructureerde JSON met sleutelvelden en regeltabellen. Data kan via webhooks of rechtstreeks via de API geleverd worden.

- Dataverwerking: Parseur treedt volledig op als verwerker onder jouw controle. Het ondersteunt verwerkingsovereenkomsten (DPA’s), biedt een helder overzicht van subprocessoren, instelbare bewaartermijnen en verwijderopties, versleutelt data in transport én opslag, en beveiligt levering met getekende webhooks.

- Ideale toepassing: Parseur is ideaal voor teams waarvan documenten vooral per e-mail binnenkomen — denk aan facturen, bonnetjes, bestellingen of financieel administratief papierwerk — en die snel, betrouwbaar en met weinig code gestructureerde data willen extraheren.

Waarom Parseur API Opvalt

Het unieke aan de Parseur API is dat die zowel een API als een webapplicatie biedt. Ontwikkelaars kunnen rechtstreeks de API koppelen aan eigen systemen, terwijl support- en operationele teams via de webapp parsingresultaat kunnen monitoren, corrigeren en verbeteren zonder extra ontwikkelwerk.

Deze dubbele opzet bespaart developers het bouwen én onderhouden van eigen managementtools, die vaak complex en tijdrovend zijn. In de webapp definieer je in enkele klikken een JSON-schema en je datavelden, pas je parsingregels direct aan en check je de output. Hierdoor werken technische en niet-technische collega’s soepel samen en hou je je integratie supersimpel.

In tegenstelling tot web scraping API’s — die afhankelijk zijn van kwetsbare webstructuren — werkt Parseur met bestanden die je al hebt. Zo bouw je kritische automatisering op een steviger, betrouwbaarder fundament.

Hoe Parseur Met Data Omgaat

Parseur is geen web scraping API, maar is gemaakt voor veilige en efficiënte verwerking van documenten en e-mails. Teams die werken met PDF’s, scans of bijlagen kunnen rekenen op een betrouwbare oplossing die deze bestanden razendsnel vertaalt naar gestructureerde JSON die je end-to-end in je workflows koppelt.

De toewijding van Parseur aan datasoevereiniteit, privacy en compliance maakt het uniek. Bedrijven gebruiken Parseur met vertrouwen, in lijn met de strengste industriestandaarden wereldwijd.

Belangrijkste aspecten van Parseur's datamanagement

Toegespitst op documenten en e-mails

Parseur verwerkt PDF’s, afbeeldingen en mailinhoud en levert schone, gestructureerde JSON via webhooks of API. Hiermee automatiseer je factuurbeheer, orders of e-mails-naar-database zonder zware custom code.

Jij behoudt de controle over je data

Alles wat je Parseur aanlevert blijft jouw eigendom. Parseur verwerkt alleen op jouw expliciete instructie. Je stelt je eigen bewaarbeleid in tot op één dag nauwkeurig. Met de Process then Delete functie kun je documenten direct verwijderen na parsing.

Waar data wordt opgeslagen

Je Parseur-gegevens staan veilig opgeslagen binnen de Europese Unie (Nederland) in een beveiligd datacenter op Google Cloud Platform (GCP). GCP voldoet aan ISO 27001. Bekijk details hier.

Beveiliging en encryptie

Alle data wordt ‘at rest’ versleuteld met AES-256, tijdens transport met TLS v1.2 of hoger. (Oude transportlagen zoals SSLv2/3 en TLS 1.0/1.1 zijn volledig uitgeschakeld.) Parseur gebruikt Let’s Encrypt SSL-certificaten. Zo is alle communicatie tussen Parseur, je browser en externe apps wereldwijd optimaal beveiligd.

Infrastructuur monitoring en penetratietests

Parseur monitort alle systemen en afhankelijkheden continu en installeert direct patches waar nodig. Onafhankelijke derden voeren regelmatig penetratietests uit conform OWASP Top 10 en SANS 25-standaarden. Enterprise-klanten kunnen volledige pentest-rapporten opvragen. In 2025 behaalde Parseur ook officieel het Astra Pentest Certificaat.

Wachtwoordveiligheid en accountbescherming

Parseur slaat nooit platte wachtwoorden op. In plaats daarvan gebruikt het een PBKDF2-algoritme met SHA-256, gecombineerd met een 512-bit salt en 600.000 iteraties (ruim boven NIST-adviezen).

Operationele betrouwbaarheid en SLA

Parseur streeft naar 99,9% of hoger uptime, met automatische retries en backoff om dataverlies bij storingen te vermijden. E-mailcollectiesystemen proberen tot 24 uur opnieuw, dubbele levermechanismen zorgen voor maximale zekerheid. Voor Enterprise-plannen geldt tot 99,99% uptime. Bekijk actuele uptime.

GDPR en privacy-first beleid

Parseur is volledig GDPR compliant en verwerkt uitsluitend namens en onder regie van jou. Jij bent altijd data Controller en je documenten blijven 100% jouw eigendom. Parseur verkoopt of deelt je data niet. Alleen waar jij het expliciet vraagt krijgen medewerkers toegang voor support. Alle teamleden volgen doorlopend GDPR- en privacytrainingen. Meer over Parseur en GDPR.

Incident response en meldingen

Komt er toch een datalek, dan meldt Parseur klanten strikt binnen 48 uur, volledig transparant en in lijn met privacywetgeving. Bekijk het volledige Security & Privacy Overzicht

Juridisch & Compliance In Vogelvlucht

Juridische en compliance-aspecten zijn essentieel bij de keuze tussen document parsing en web scraping API’s. Beide verwerken data, maar hun verplichtingen verschillen per bron en context.

Organisaties moeten over een rechtsgrond beschikken voor verwerking van documenten. Dat betekent afspraken met de data-eigenaar, duidelijke rolverdeling (controller/processor), een verwerkersovereenkomst en heldere bewaartermijnen. Neem meldingsplichten en dataminimalisatie op in je documentworkflows.

Het juridische landschap voor web scraping is ingewikkelder. Publieke data scrapen mag soms, maar veel websites verbieden dit expliciet in hun voorwaarden of robots.txt. Betaalmuur, toegangsrestricties of anti-botmaatregelen omzeilen verhoogt de compliance- en juridische risico’s. Gebruik je scraping, raadpleeg altijd legal zodat je beleid aansluit bij wet- en regelgeving.

Internationale datatransfers vormen een extra laag complexiteit. Verwerk je bijvoorbeeld Europese persoonsgegevens, dan heb je altijd een compliant overdrachtsmechanisme nodig.

Tot Slot: De Juiste API Voor Jouw Data

Document parsing- en web scraping API’s spelen beide een waardevolle rol in geautomatiseerde dataverzameling, maar dan wel elk voor een andere bron. Parsing is ideaal voor documenten die je bezit, zoals facturen, afschriften of e-mails.

Volgens Experlogix kan documentautomatisering de verwerkingstijd tot wel 80% verkorten – een enorme efficiëntieslag dankzij moderne document parsing API’s.

Scraping is perfect als de data die jij nodig hebt enkel via openbare websites beschikbaar is, zoals productcatalogi of prijzen. In sommige workflows gebruiken teams scraping om bestanden te verzamelen en parsing voor gestructureerde output.

Het draait om de bron: ontvang je data als PDF’s, scans of e-mails, dan levert document parsing je snelheid en nauwkeurigheid. Staat je data op webpagina’s, dan is een scraping API waarschijnlijk de juiste keuze. Werk je met beide? Door beiden te combineren heb je een complete oplossing voor je datavraagstuk.

Veelgestelde Vragen

Veel lezers hebben dezelfde vragen wanneer ze document parsing en web scraping vergelijken. Hieronder vind je antwoorden op de meest gestelde vragen om hun verschillen en praktische toepassingen te verduidelijken.

-

Is document parsing hetzelfde als web scraping?

-

Nee. Document parsing werkt met bestanden zoals PDF's, gescande afbeeldingen of e-mails waar jij al van in het bezit bent of hebt ontvangen, terwijl web scraping data van websites haalt door HTML of gerenderde inhoud te analyseren.

-

Is Parseur een web scraping API-tool?

-

Nee. Parseur is een document- en e-mail parsing API, geen web scraping tool. Het crawlt of haalt geen webpagina’s op. In plaats daarvan helpt het jou om documenten waar jij eigenaar van bent, zoals e-mails, PDF's, afbeeldingen of Office-bestanden, om te zetten naar gestructureerde JSON. Dit maakt het ideaal voor workflows zoals het verwerken van facturen, bonnetjes en bestelbonnen zonder dat je zelf ingewikkelde interne tools hoeft te bouwen.

-

Is web scraping legaal?

-

Dat hangt af van de context. Het scrapen van openbare data is soms toegestaan, maar websites vermelden vaak beperkingen in hun algemene voorwaarden of in het robots.txt-bestand. Bekijk deze documenten altijd goed en raadpleeg een juridisch adviseur voordat je begint.

-

Wanneer moet ik scraping vermijden?

-

Scraping moet je vermijden als data achter betaalmuren zit, onder strenge toegangscontrole staat, of expliciet verboden is door de voorwaarden van de site. Pogingen om beperkingen te omzeilen kunnen leiden tot compliance- en juridische risico’s.

Laatst bijgewerkt op